在我們的論文中,我們介紹了DailyTalk,這是一種專為文本到語音設計的高質量對話演講數據集。

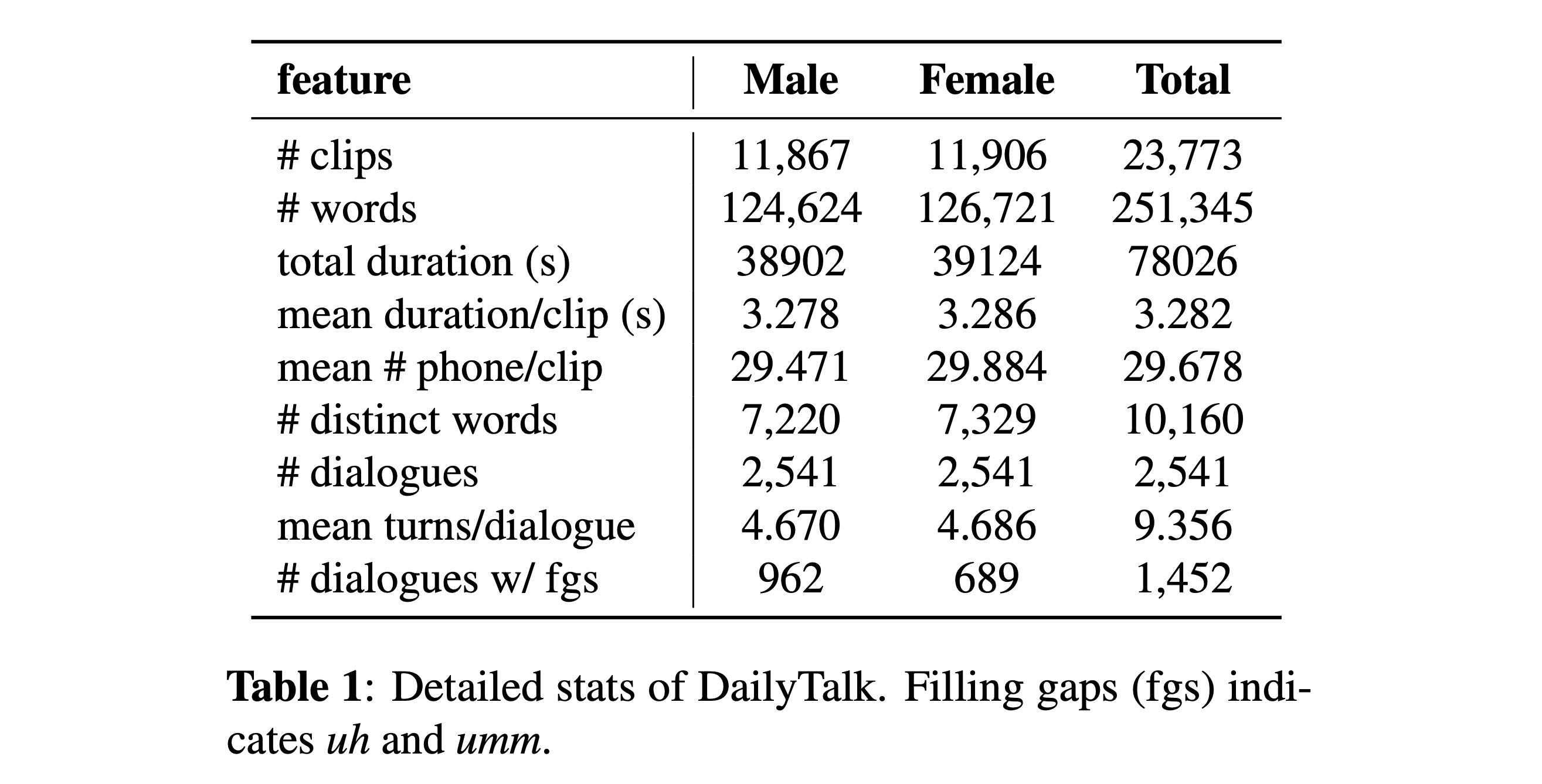

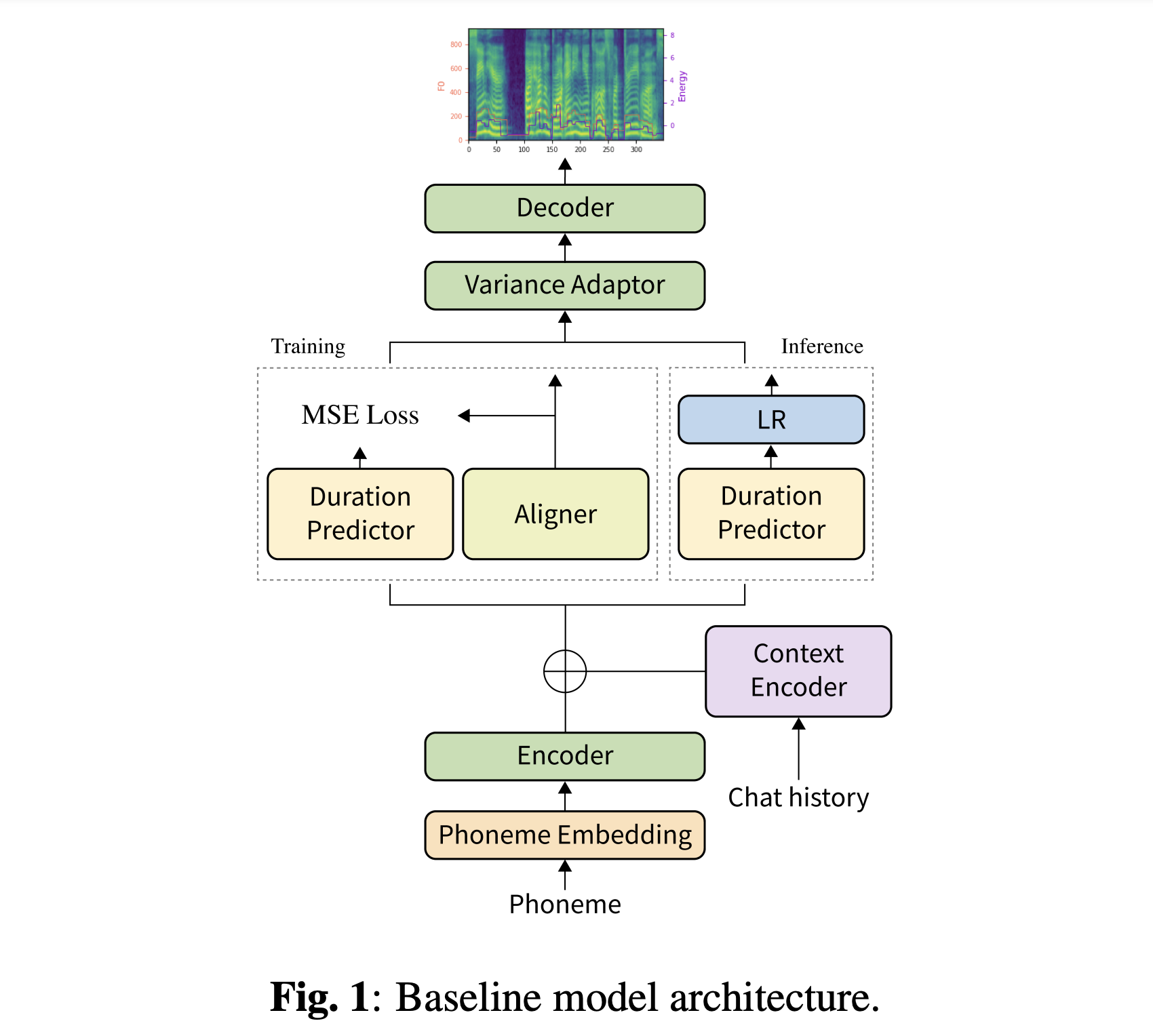

摘要:當前文本到語音(TTS)數據集的大多數是單個話語的集合,幾乎沒有對話方面。在本文中,我們介紹了DailyTalk,這是一個專為對話tts設計的高質量對話語音數據集。我們從開放域對話數據集Dabordialog中取樣,修改並記錄了2,541個對話,以繼承其註釋的屬性。在我們的數據集之外,我們將先前的工作擴展為我們的基準,在該基線中,非自動回憶TTS的對話中的歷史信息為條件。從一般和我們的新型指標的基線實驗中,我們表明每日talk可以用作一般的TTS數據集,而且我們的基線還可以代表來自DailyTalk的上下文信息。 DailyTalk數據集和基線代碼可自由使用CC-BY-SA 4.0許可證。

您可以下載我們的數據集。有關詳細信息,請參閱統計詳細信息。

您可以下載我們驗證的型號。有兩個不同的目錄:“ history_none”和“ history_guo”。前者沒有歷史編碼,因此它不是對話性上下文感知的模型。後者俱有在語音代理的端到端TTS之後的歷史編碼(Guo等,2020)。

通過

# In the model.yaml

history_encoder :

type : " Guo " # ["none", "Guo"]您可以使用

pip3 install -r requirements.txt

此外,還為Docker用戶提供Dockerfile 。

您必須下載我們的兩個數據集。下載驗證的型號,並將其放入output/ckpt/DailyTalk/ 。也在hifigan文件夾中的unzip generator_LJSpeech.pth.tar或generator_universal.pth.tar 。在變壓器構建塊和歷史編碼類型下,對模型進行了無監督的持續時間建模培訓。

僅支持批次推理,因為轉彎的產生可能需要對話的上下文歷史。嘗試

python3 synthesize.py --source preprocessed_data/DailyTalk/val_*.txt --restore_step RESTORE_STEP --mode batch --dataset DailyTalk

綜合preprocessed_data/DailyTalk/val_*.txt中的所有話語。

對於帶有外部揚聲器嵌入式的多揚聲器TT ,下載cacknn softmax+三胞胎預算的Philipperemy DeepSpeaker的揚聲器嵌入模型,並將其定位在./deepspeaker/pretrained_models/中。請注意,我們驗證的模型未接受此培訓(他們接受了使用speaker_embedder: "none" )。

跑步

python3 prepare_align.py --dataset DailyTalk

用於一些準備工作。

對於強制對準,蒙特利爾強制對準器(MFA)用於獲得發音和音素序列之間的比對。此處提供了數據集的預提取對齊。您必須在preprocessed_data/DailyTalk/TextGrid/中解壓縮文件。或者,您可以自己運行對準器。請注意,我們驗證的模型未接受有監督的持續時間建模培訓(他們接受了learn_alignment: True培訓)。

之後,通過

python3 preprocess.py --dataset DailyTalk

培訓您的模型

python3 train.py --dataset DailyTalk

有用的選項:

--use_amp參數附加到上述命令。CUDA_VISIBLE_DEVICES=<GPU_IDs> 。使用

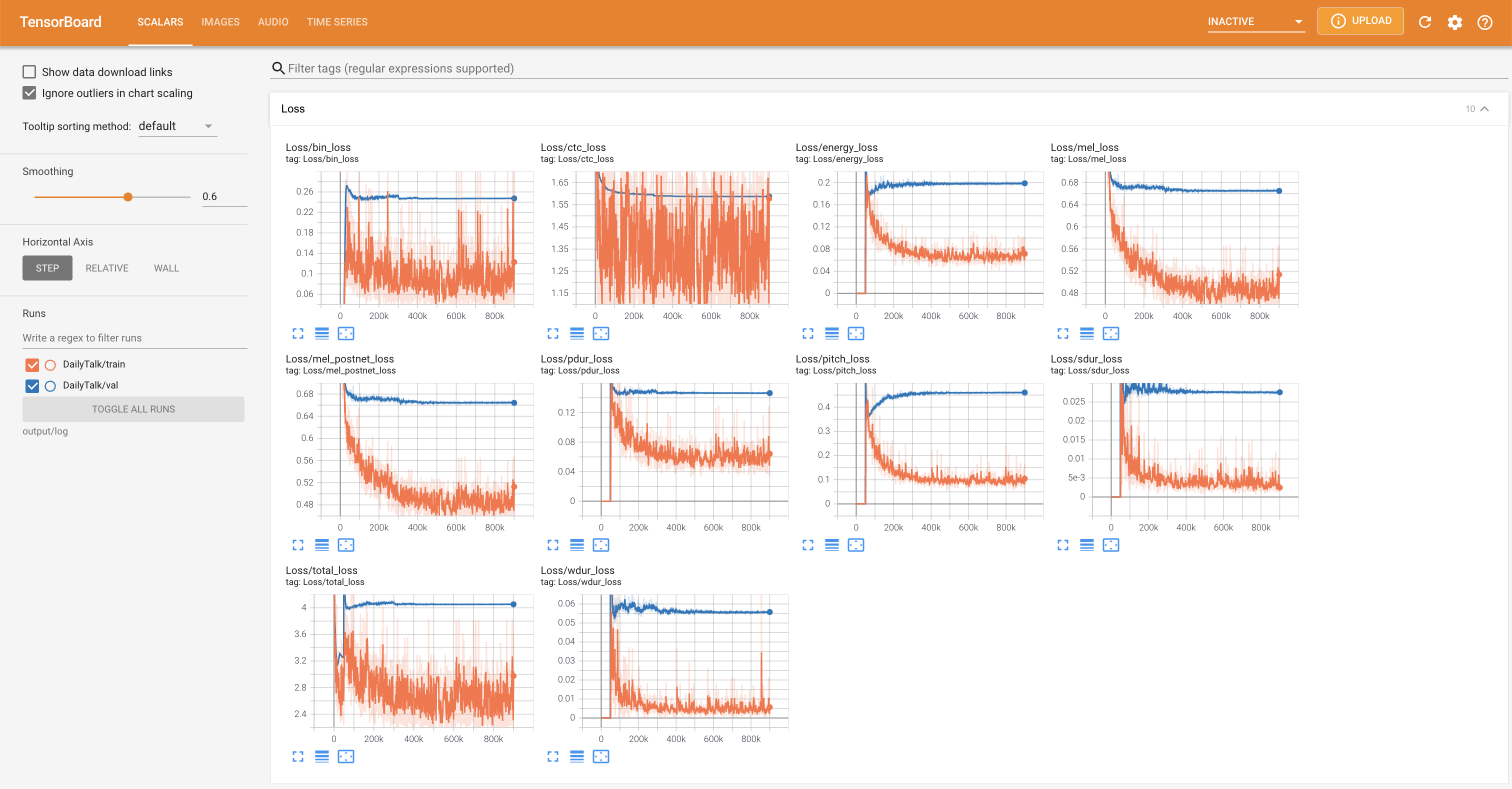

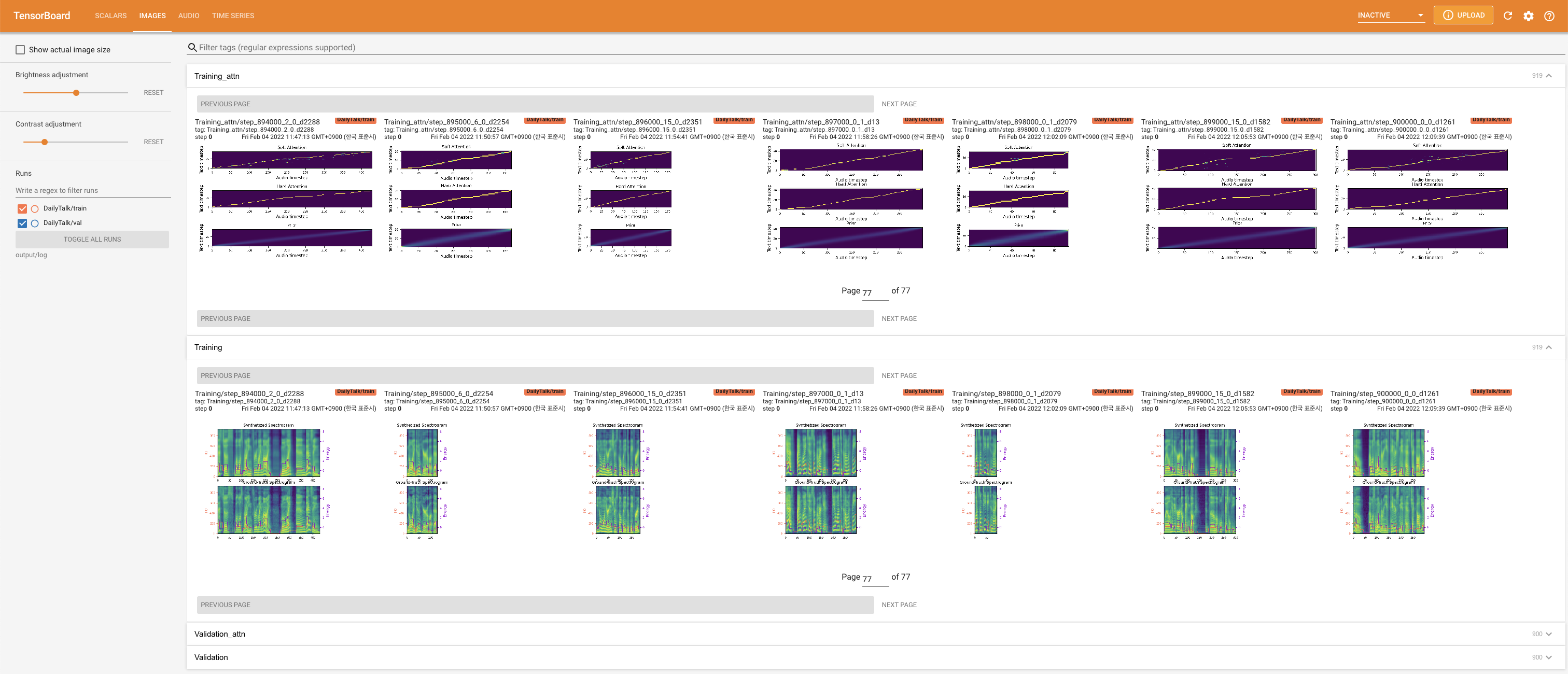

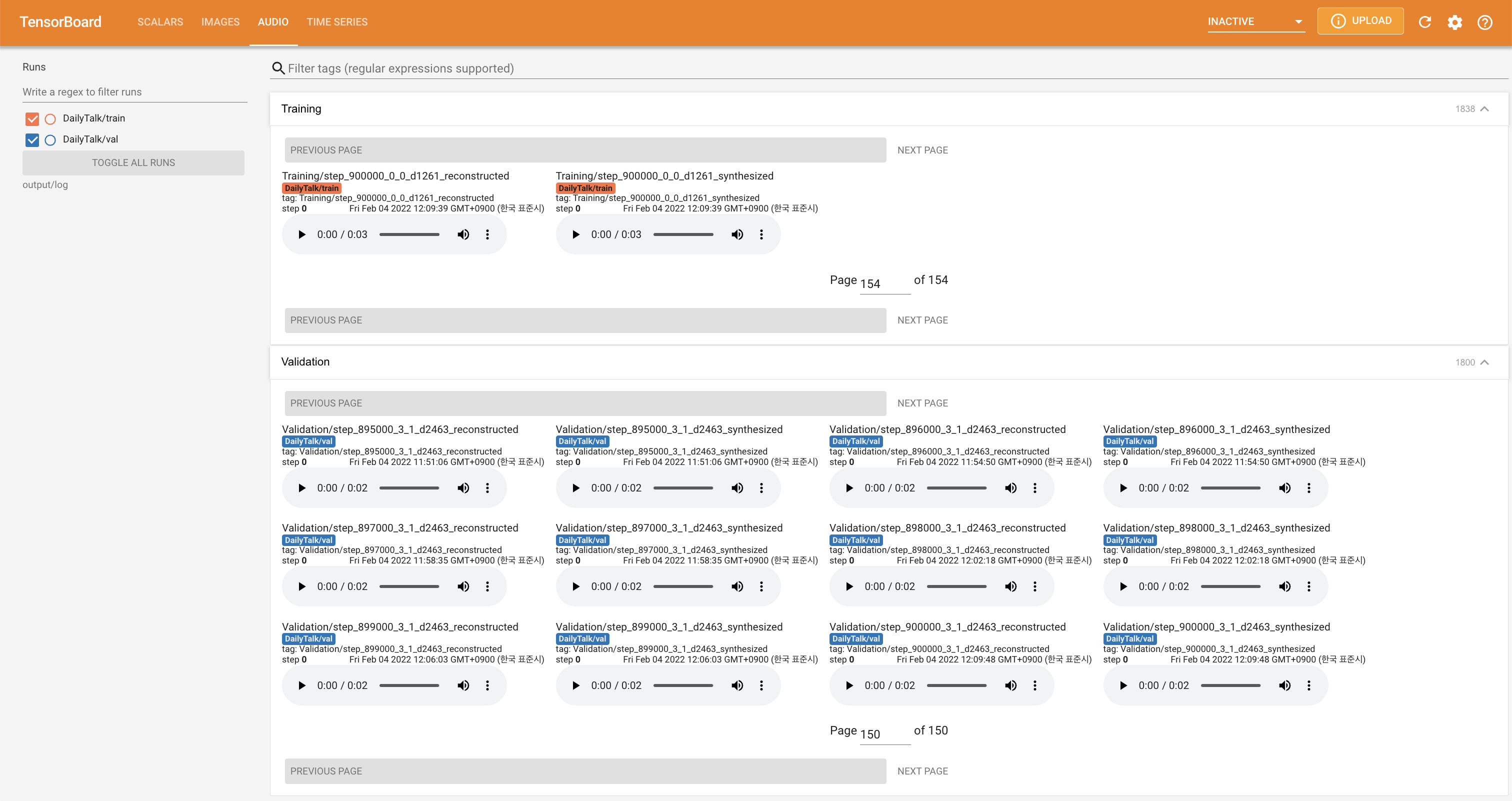

tensorboard --logdir output/log

在您的本地主機上提供張板。顯示了損耗曲線,合成的MEL光譜圖和音頻。

'none'和'DeepSpeaker'之間)進行切換。如果您想使用我們的數據集和代碼或參考我們的論文,請如下引用。

@misc{lee2022dailytalk,

title={DailyTalk: Spoken Dialogue Dataset for Conversational Text-to-Speech},

author={Keon Lee and Kyumin Park and Daeyoung Kim},

year={2022},

eprint={2207.01063},

archivePrefix={arXiv},

primaryClass={eess.AS}

}

這項工作是根據創意共享歸因 - 共享4.0國際許可證獲得許可的。