阿里巴巴達摩院近日發布了一款名為Babel的多語言大型語言模型,旨在打破全球語言障礙,使人工智能能夠理解並使用全球90%以上人口的語言進行交流。這一創新舉措標誌著AI技術在語言處理領域邁出了重要一步。

目前,許多大型語言模型主要關注英語、法語、德語等資源豐富的語言,而像印地語、孟加拉語、烏爾都語等擁有龐大用戶群體的語言卻常常被忽視。這種現像類似於全球會議中,小語種使用者往往被邊緣化的情況。

Babel的推出正是為了改變這一現狀。該模型支持全球使用人數最多的25種語言,覆蓋了超過90%的世界人口。更為重要的是,Babel還特別關注了斯瓦希里語、爪哇語、緬甸語等在開源LLM中鮮有涉獵的語種。這一舉措將為數十億使用這些語言的人們帶來更便捷、更優質的AI語言服務。

與傳統的持續預訓練方法不同,Babel採用了獨特的層擴展技術來提升模型的能力。這種方法可以理解為在模型原有的基礎上,以一種更精巧的方式增加“知識儲備”,從而在提升性能的同時,也保證了計算效率。研究團隊推出了兩款各具特色的模型:Babel-9B,專為高效的單GPU推理和微調而優化;以及Babel-83B,這款擁有830億參數的“巨擘”旨在樹立開源多語言LLM的新標杆。

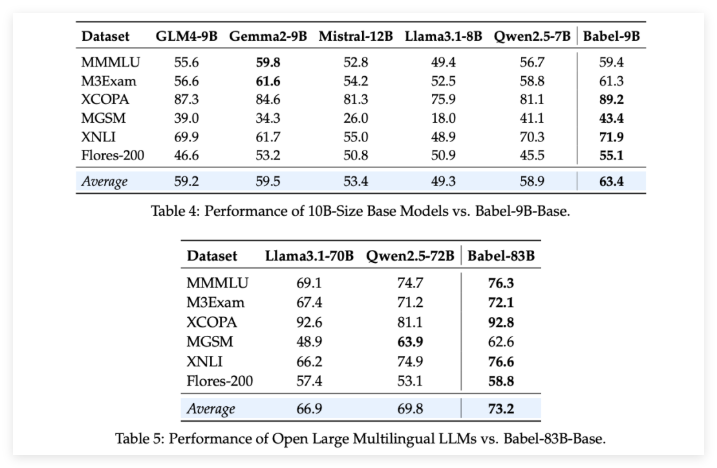

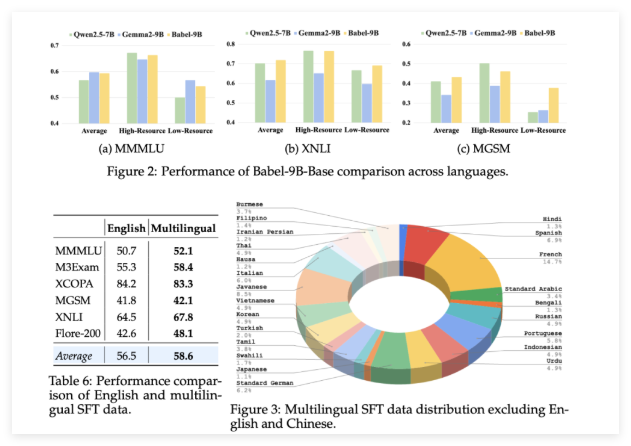

為了驗證Babel的實力,研究團隊在多個多語言任務上進行了嚴格的評估。結果令人振奮:無論是90億參數的Babel-9B,還是830億參數的Babel-83B,在多項基準測試中均超越了同等規模的其他開源模型。例如,Babel在世界知識(MMMLU,M3Exam)、推理(MGSM,XCOPA)、理解(XNLI)和翻譯(Flores-200)等任務上均表現出色。

尤其值得一提的是,Babel在處理資源匱乏的語言時,其準確率相較於以往的多語言LLM提升了5%到10%。這充分展示了Babel在提升語言覆蓋率的同時,也注重了模型在各種語言上的性能表現。

更令人驚喜的是,通過在超過一百萬個對話數據集上進行監督微調(SFT)後,Babel的聊天版本Babel-9B-Chat和Babel-83B-Chat展現出了強大的對話能力,其性能甚至可以媲美一些頂尖的商業AI模型。例如,Babel-83B-Chat在某些任務上已能與GPT-4o一較高下。這無疑為開源社區注入了新的活力,證明了開源模型在多語言能力上同樣可以取得領先地位。

項目:https://babel-llm.github.io/babel-llm/

github:https://github.com/babel-llm/babel-llm