Alibaba Damo Academy baru -baru ini merilis model bahasa multibahasa besar yang disebut Babel, yang bertujuan untuk memecahkan hambatan bahasa global dan memungkinkan kecerdasan buatan untuk memahami dan berkomunikasi menggunakan bahasa lebih dari 90% populasi dunia. Langkah inovatif ini menandai langkah penting dalam bidang pemrosesan bahasa.

Saat ini, banyak model bahasa besar fokus pada bahasa yang kaya sumber daya seperti bahasa Inggris, Prancis, dan Jerman, sementara bahasa dengan basis pengguna besar seperti Hindi, Bengali, dan Urdu sering diabaikan. Fenomena ini mirip dengan situasi di mana pengguna bahasa kecil sering terpinggirkan dalam konferensi global.

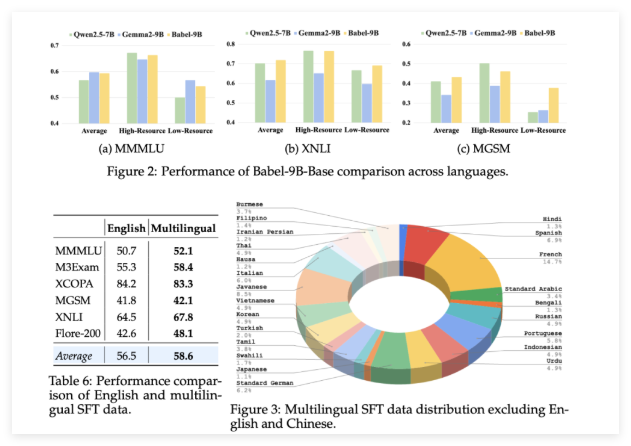

Babel diluncurkan untuk mengubah situasi ini. Model ini mendukung 25 bahasa yang paling banyak digunakan di dunia, yang mencakup lebih dari 90% populasi dunia. Lebih penting lagi, Babel juga memberikan perhatian khusus pada bahasa Swahili, Jawa, Burma, dan bahasa lain yang jarang ditemukan di open source llm. Langkah ini akan membawa layanan bahasa AI yang lebih nyaman dan lebih baik kepada miliaran orang yang menggunakan bahasa -bahasa ini.

Tidak seperti metode pra-pelatihan berkelanjutan tradisional, Babel menggunakan teknologi ekspansi lapisan yang unik untuk meningkatkan kemampuan model. Metode ini dapat dipahami sebagai meningkatkan "cadangan pengetahuan" dengan cara yang lebih canggih berdasarkan model asli, sehingga meningkatkan kinerja sambil memastikan efisiensi komputasi. Tim peneliti meluncurkan dua model khas: BABEL-9B, dioptimalkan untuk inferensi dan penyempurnaan gpu tunggal yang efisien; dan Babel-83b, 83 miliar parameter "besar" yang bertujuan untuk menetapkan tolok ukur baru untuk open source multibahasa multibahasa LLM.

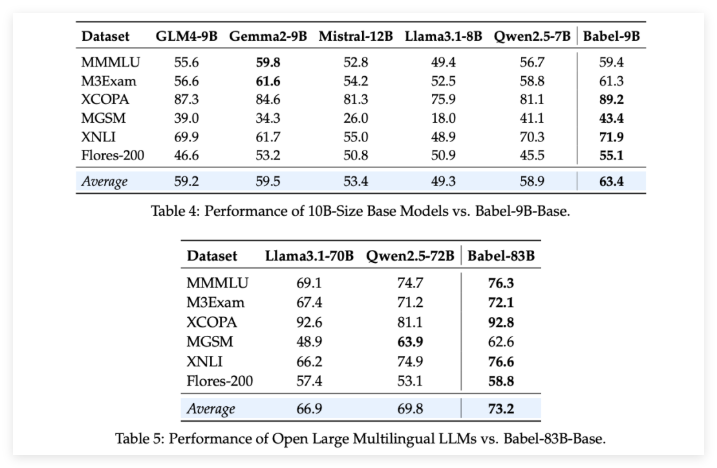

Untuk memverifikasi kekuatan Babel, tim peneliti melakukan evaluasi ketat pada beberapa tugas multibahasa. Hasilnya menarik: apakah itu 9 miliar parameter BABEL-9B atau 83 miliar-parameter BABEL-83B, ia melampaui model open source lainnya dari skala yang sama dalam berbagai tolok ukur. Sebagai contoh, Babel tampil baik dalam tugas-tugas seperti World Bellowe (MMMLU, M3exam), penalaran (MGSM, XCOPA), Pemahaman (XNLI), dan Terjemahan (Flores-200).

Perlu disebutkan bahwa ketika Babel berurusan dengan bahasa-bahasa yang luar biasa, tingkat akurasinya telah meningkat sebesar 5% menjadi 10% dibandingkan dengan LLM multibahasa sebelumnya. Ini sepenuhnya menunjukkan bahwa sementara Babel meningkatkan cakupan bahasa, ia juga memperhatikan kinerja model dalam berbagai bahasa.

Yang lebih mengejutkan adalah bahwa setelah diawasi menyempurnakan (SFT) pada lebih dari satu juta dataset percakapan, versi obrolan Babel Babel-9b-Cat dan Babel-83B-CHAT menunjukkan kemampuan percakapan yang kuat, dan kinerjanya bahkan sebanding dengan beberapa model AI komersial teratas. Misalnya, BABEL-83B-CHAT telah mampu bersaing dengan GPT-4O pada tugas-tugas tertentu. Ini tidak diragukan lagi menyuntikkan vitalitas baru ke dalam komunitas open source, membuktikan bahwa model open source juga dapat memperoleh posisi terdepan dalam kemampuan multibahasa.

Proyek: https://babel-llm.github.io/babel-llm/

Github: https: //github.com/babel-llm/babel-llm