A Alibaba Damo Academy lançou recentemente um grande modelo de linguagem multilíngue chamado Babel, com o objetivo de quebrar as barreiras globais do idioma e permitir que a inteligência artificial compreenda e se comunique usando o idioma de mais de 90% da população mundial. Esse movimento inovador marca uma etapa importante no campo do processamento da linguagem.

Atualmente, muitos modelos de idiomas grandes se concentram em idiomas ricos em recursos, como inglês, francês e alemão, enquanto idiomas com uma grande base de usuários como hindi, bengali e urdu são frequentemente negligenciados. Esse fenômeno é semelhante à situação em que os usuários de pequenos idiomas são frequentemente marginalizados em conferências globais.

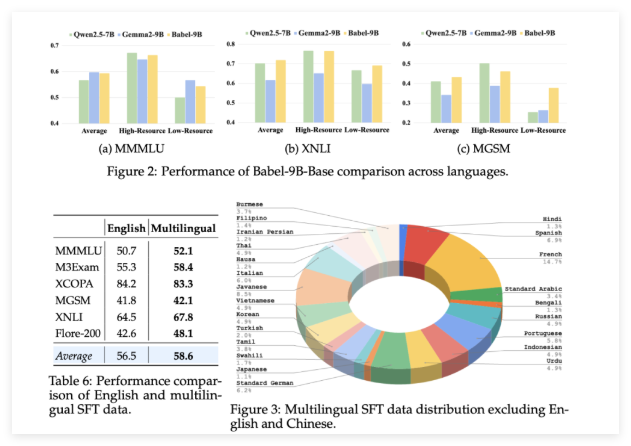

Babel foi lançado para mudar essa situação. O modelo suporta as 25 línguas mais faladas do mundo, cobrindo mais de 90% da população mundial. Mais importante, Babel também presta atenção especial a suaíli, javanesa, birmanesa e outros idiomas que raramente são encontrados no LLM de código aberto. Esse movimento trará mais serviços de idioma de IA mais convenientes e melhores para bilhões de pessoas que usam esses idiomas.

Diferentemente dos métodos tradicionais de pré-treinamento contínuo, Babel usa a tecnologia de expansão de camada exclusiva para aprimorar os recursos do modelo. Esse método pode ser entendido como aumentando a "reserva de conhecimento" de uma maneira mais sofisticada com base no modelo original, melhorando o desempenho, garantindo a eficiência da computação. A equipe de pesquisa lançou dois modelos distintos: Babel-9B, otimizado para inferência e ajuste fino eficientes da GPU; e Babel-83B, um "grande" de 83 bilhões de parâmetros, com o objetivo de estabelecer uma nova referência para LLM multilíngue de código aberto.

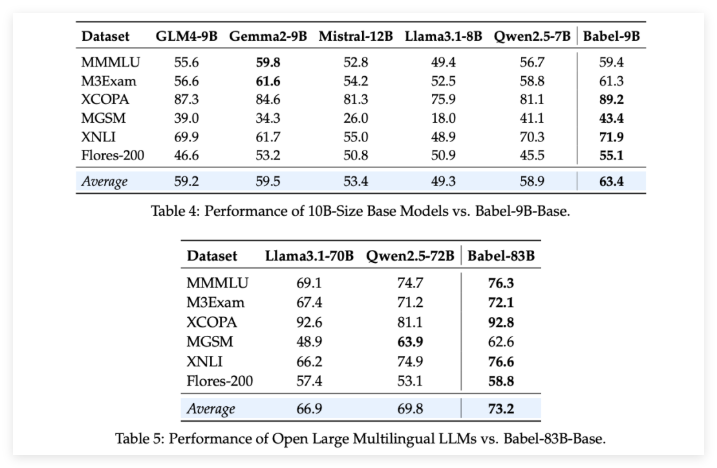

Para verificar a força de Babel, a equipe de pesquisa realizou avaliações rigorosas em várias tarefas multilíngues. Os resultados são emocionantes: seja o Babel-9b de 9 bilhões de parâmetros ou o Babel-83B de 83 bilhões de parâmetros, supera outros modelos de código aberto da mesma escala em vários benchmarks. Por exemplo, Babel teve um bom desempenho em tarefas como o World Knowledge (MMMLU, M3EXAM), o raciocínio (MGSM, XCOPA), o entendimento (XNLI) e a tradução (Flores-200).

Vale a pena mencionar particularmente que, quando Babel lida com idiomas de escolar de recursos, sua taxa de precisão aumentou de 5% a 10% em comparação com o LLM multilíngue anterior. Isso demonstra totalmente que, embora Babel melhore a cobertura da linguagem, também presta atenção ao desempenho do modelo em vários idiomas.

O que é ainda mais surpreendente é que, após o ajuste fino (SFT) supervisionado em mais de um milhão de conjuntos de dados de conversas, as versões de bate-papo de Babel Babel-9b-Chat e Babel-83b-Chat demonstram fortes capacidades de conversação, e seu desempenho é comparável a alguns modelos comerciais de IA. Por exemplo, Babel-83b-Chat conseguiu competir com o GPT-4O em determinadas tarefas. Isso, sem dúvida, injeta nova vitalidade na comunidade de código aberto, provando que o modelo de código aberto também pode obter uma posição de liderança nos recursos multilíngues.

Projeto: https://babel-llm.github.io/babel-llm/

Github: https: //github.com/babel-llm/babel-llm