阿里巴巴达摩院近日发布了一款名为Babel的多语言大型语言模型,旨在打破全球语言障碍,使人工智能能够理解并使用全球90%以上人口的语言进行交流。这一创新举措标志着AI技术在语言处理领域迈出了重要一步。

目前,许多大型语言模型主要关注英语、法语、德语等资源丰富的语言,而像印地语、孟加拉语、乌尔都语等拥有庞大用户群体的语言却常常被忽视。这种现象类似于全球会议中,小语种使用者往往被边缘化的情况。

Babel的推出正是为了改变这一现状。该模型支持全球使用人数最多的25种语言,覆盖了超过90%的世界人口。更为重要的是,Babel还特别关注了斯瓦希里语、爪哇语、缅甸语等在开源LLM中鲜有涉猎的语种。这一举措将为数十亿使用这些语言的人们带来更便捷、更优质的AI语言服务。

与传统的持续预训练方法不同,Babel采用了独特的层扩展技术来提升模型的能力。这种方法可以理解为在模型原有的基础上,以一种更精巧的方式增加“知识储备”,从而在提升性能的同时,也保证了计算效率。研究团队推出了两款各具特色的模型:Babel-9B,专为高效的单GPU推理和微调而优化;以及Babel-83B,这款拥有830亿参数的“巨擘”旨在树立开源多语言LLM的新标杆。

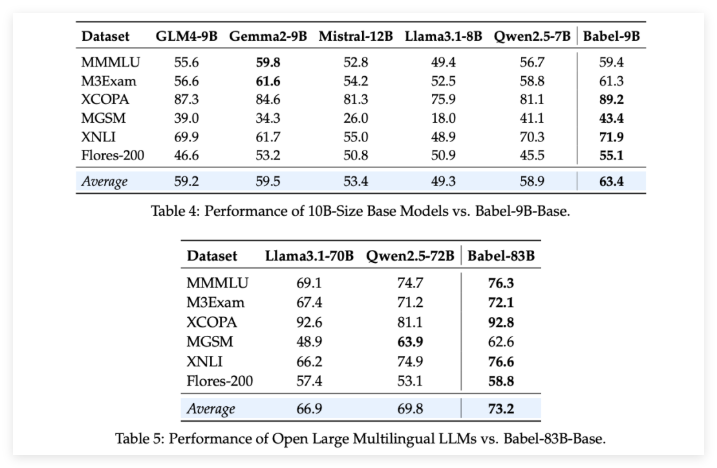

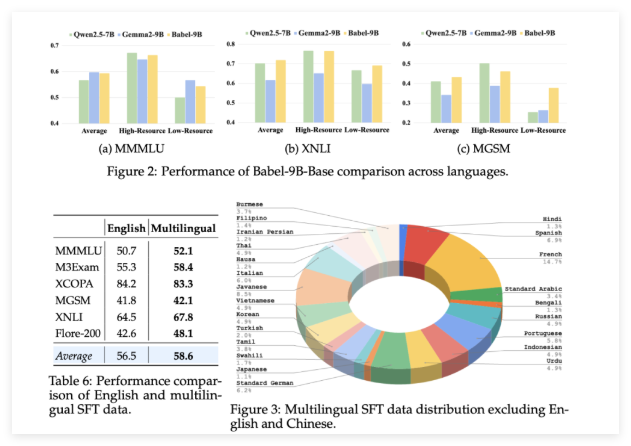

为了验证Babel的实力,研究团队在多个多语言任务上进行了严格的评估。结果令人振奋:无论是90亿参数的Babel-9B,还是830亿参数的Babel-83B,在多项基准测试中均超越了同等规模的其他开源模型。例如,Babel在世界知识(MMMLU,M3Exam)、推理(MGSM,XCOPA)、理解(XNLI)和翻译(Flores-200)等任务上均表现出色。

尤其值得一提的是,Babel在处理资源匮乏的语言时,其准确率相较于以往的多语言LLM提升了5%到10%。这充分展示了Babel在提升语言覆盖率的同时,也注重了模型在各种语言上的性能表现。

更令人惊喜的是,通过在超过一百万个对话数据集上进行监督微调(SFT)后,Babel的聊天版本Babel-9B-Chat和Babel-83B-Chat展现出了强大的对话能力,其性能甚至可以媲美一些顶尖的商业AI模型。例如,Babel-83B-Chat在某些任务上已能与GPT-4o一较高下。这无疑为开源社区注入了新的活力,证明了开源模型在多语言能力上同样可以取得领先地位。

项目:https://babel-llm.github.io/babel-llm/

github:https://github.com/babel-llm/babel-llm