Alibaba Damo Academyは最近、Babelと呼ばれる大規模な多言語モデルをリリースしました。これは、世界的な言語の障壁を破り、人工知能が世界人口の90%以上の言語を使用して理解して通信できるようにすることを目指しています。この革新的な動きは、言語処理の分野における重要なステップです。

現在、多くの大規模な言語モデルは、英語、フランス語、ドイツ語などのリソースが豊富な言語に焦点を当てていますが、ヒンディー語、ベンガル語、ウルドゥー語などの大規模なユーザーベースを持つ言語は見落とされがちです。この現象は、小言語ユーザーがグローバル会議でしばしば疎外される状況に似ています。

バベルはこの状況を変えるために開始されました。このモデルは、世界で最も話されている25の言語をサポートしており、世界の人口の90%以上をカバーしています。さらに重要なことに、バベルはまた、スワヒリ語、ジャワ、ビルマ、その他の言語には、オープンソースLLMにめったに見られない言語に特別な注意を払っています。この動きは、これらの言語を使用する何十億人もの人々により、より便利でより良いAI言語サービスをもたらします。

従来の連続前のトレーニング方法とは異なり、Babelは一意のレイヤー拡張技術を使用してモデルの機能を強化します。この方法は、元のモデルに基づいてより洗練された方法で「知識保護区」を増やすことで、コンピューティングの効率を確保しながらパフォーマンスを向上させると理解できます。研究チームは、効率的なシングルGPU推論と微調整のために最適化されたBabel-9Bの2つの特徴的なモデルを開始しました。 Babel-83bは、オープンソース多言語LLMの新しいベンチマークを設定することを目的とした830億パラメーター「Big」です。

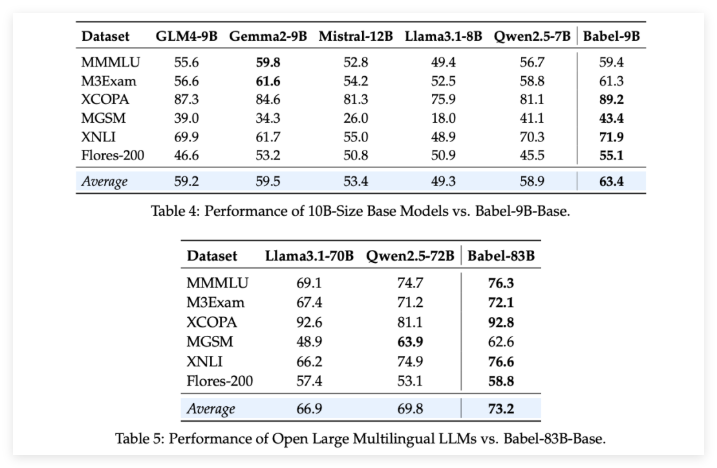

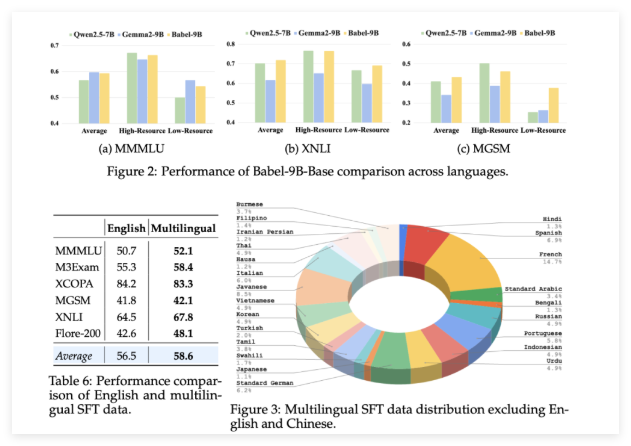

Babelの強みを検証するために、研究チームは複数の多言語タスクについて厳格な評価を実施しました。結果はエキサイティングです。それが90億パラメーターのBabel-9Bであろうと830億パラメーターのBabel-83Bであろうと、複数のベンチマークで同じスケールの他のオープンソースモデルを上回ります。たとえば、バベルは、世界知識(MMMLU、M3Exam)、推論(MGSM、XCOPA)、理解(XNLI)、翻訳(Flores-200)などのタスクでうまく機能しました。

Babelがリソーススカース言語を扱う場合、その精度率は以前の多言語LLMと比較して5%増の10%増加したことに特に言及する価値があります。これは、バベルが言語のカバレッジを改善する一方で、さまざまな言語でのモデルのパフォーマンスにも注意を払うことを完全に示しています。

さらに驚くべきことは、100万を超える会話データセットで監視された微調整(SFT)の後、BabelのチャットバージョンBabel-9B-chatとBabel-83b-chatが強力な会話能力を示しており、そのパフォーマンスはいくつかのトップの商用AIモデルに匹敵することです。たとえば、Babel-83b-chatは、特定のタスクでGPT-4oと競合することができました。これは間違いなくオープンソースコミュニティに新しい活力を注入し、オープンソースモデルも多言語機能において主要な位置を獲得できることを証明しています。

プロジェクト:https://babel-llm.github.io/babel-llm/

github:https://github.com/babel-llm/babel-llm