Академия Alibaba Damo недавно выпустила большую многоязычную языковую модель под названием Babel, стремясь преодолеть глобальные языковые барьеры и позволить искусственному интеллекту понять и общаться с использованием языка более чем 90% населения мира. Этот инновационный шаг знаменует собой важный шаг в области языковой обработки.

В настоящее время многие крупные языковые модели посвящены богатым ресурсам, таким как английский, французский и немецкий, в то время как языки с большой пользовательской базой, такими как хинди, бенгальский и урду, часто упускаются из виду. Это явление похоже на ситуацию, в которой мелкие пользователи языка часто маргинализируются на глобальных конференциях.

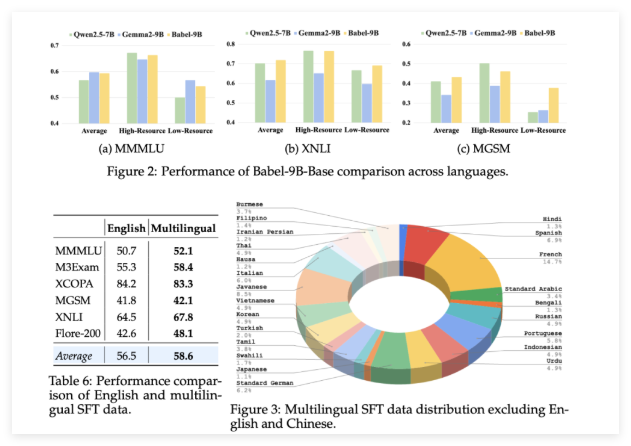

Вавилон был запущен, чтобы изменить эту ситуацию. Модель поддерживает 25 самых разговорных языков в мире, охватывающих более 90% населения мира. Что еще более важно, Бабель также уделяет особое внимание суахили, яванскому, бирманскому и другим языкам, которые редко встречаются в LLM с открытым исходным кодом. Этот шаг принесет более удобные и лучшие языковые услуги AI в миллиарды людей, которые используют эти языки.

В отличие от традиционных методов непрерывного предварительного обучения, Babel использует уникальную технологию расширения слоев для расширения возможностей модели. Этот метод можно понимать как увеличение «резерва знаний» более сложным способом на основе исходной модели, тем самым повышая производительность, обеспечивая при этом эффективность вычислений. Исследовательская группа запустила две отличительные модели: Babel-9B, оптимизированные для эффективного вывода с одним GPU и точной настройкой; и Babel-83B, 83 миллиарда параметра «Big», нацеленный на установление нового эталона для многоязычного LLM с открытым исходным кодом.

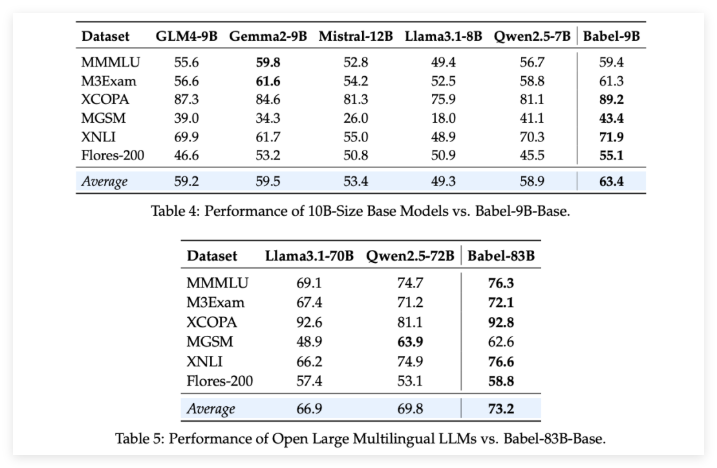

Чтобы проверить силу Бабеля, исследовательская группа провела строгие оценки нескольких многоязычных задач. Результаты являются захватывающими: будь то 9 миллиардов параметра Babel-9B или 83 миллиарда параметра Babel-83B, он превосходит другие модели с открытым исходным кодом в одном и том же масштабе в нескольких тестах. Например, Babel хорошо выполнял такие задачи, как World Knowleding (MMMLU, M3EXAM), рассуждения (MGSM, XCOPA), понимание (XNLI) и перевод (Flores-200).

Особенно стоит упомянуть, что, когда Babel занимается языками с большим количеством ресурсов, его точность увеличилась на 5-10% по сравнению с предыдущим многоязычным LLM. Это полностью демонстрирует, что в то время как Babel улучшает охват языка, он также обращает внимание на производительность модели на различных языках.

Что еще более удивительно, так это то, что после контролируемой тонкой настройки (SFT) на более чем миллионе наборов данных беседы версии Babel's Babel-9B-Chat и Babel-83B-чат демонстрируют сильные разговорные возможности, и их производительность даже сопоставимы с некоторыми лучшими коммерческими моделями ИИ. Например, Babel-83B-Chat смог конкурировать с GPT-4O по определенным задачам. Это, несомненно, внедряет новую жизнеспособность в сообщество с открытым исходным кодом, доказывая, что модель с открытым исходным кодом также может получить лидирующую позицию в многоязычных возможностях.

Проект: https://babel-llm.github.io/babel-llm/

github: https: //github.com/babel-llm/babel-llm