Alibaba Damo Academy는 최근 Babel이라는 대규모 다국어 언어 모델을 발표하여 전 세계 언어 장벽을 깨고 인공 지능이 세계 인구의 90% 이상의 언어를 사용하여 이해하고 의사 소통 할 수 있도록했습니다. 이 혁신적인 움직임은 언어 처리 분야에서 중요한 단계입니다.

현재 많은 대형 언어 모델은 영어, 프랑스어 및 독일어와 같은 자원이 풍부한 언어에 중점을두고 있으며 힌디어, 벵골어 및 우르두어와 같은 대규모 사용자 기반이있는 언어는 종종 간과됩니다. 이 현상은 소규모 언어 사용자가 종종 글로벌 회의에서 소외되는 상황과 유사합니다.

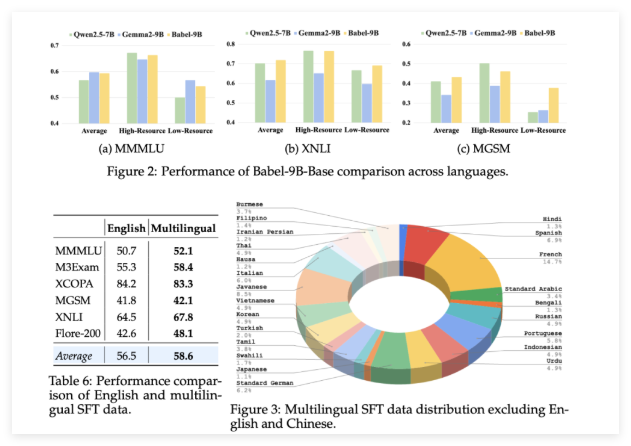

바벨은이 상황을 바꾸기 위해 시작되었습니다. 이 모델은 세계에서 가장 많이 사용되는 25 개 언어를 지원하며 세계 인구의 90% 이상을 차지합니다. 더 중요한 것은 Babel은 Swahili, Javanese, Burmese 및 Open Source LLM에서 거의 발견되지 않는 다른 언어에 특별한 관심을 기울이는 것입니다. 이러한 움직임은 이러한 언어를 사용하는 수십억 명의 사람들에게보다 편리하고 더 나은 AI 언어 서비스를 제공 할 것입니다.

기존의 연속 사전 훈련 방법과 달리 Babel은 고유 한 계층 확장 기술을 사용하여 모델의 기능을 향상시킵니다. 이 방법은 원래 모델을 기반으로보다 정교한 방식으로 "지식 보호 구역"을 증가시켜 성능을 향상시키면서 컴퓨팅 효율성을 보장 할 수 있습니다. 연구팀은 효율적인 단일 GPU 추론 및 미세 조정을 위해 최적화 된 Babel-9B의 두 가지 독특한 모델을 시작했습니다. 그리고 830 억 개의 패러마 미터 "Big"인 Babel-83B는 오픈 소스 다국어 LLM을위한 새로운 벤치 마크를 설정하는 것을 목표로했습니다.

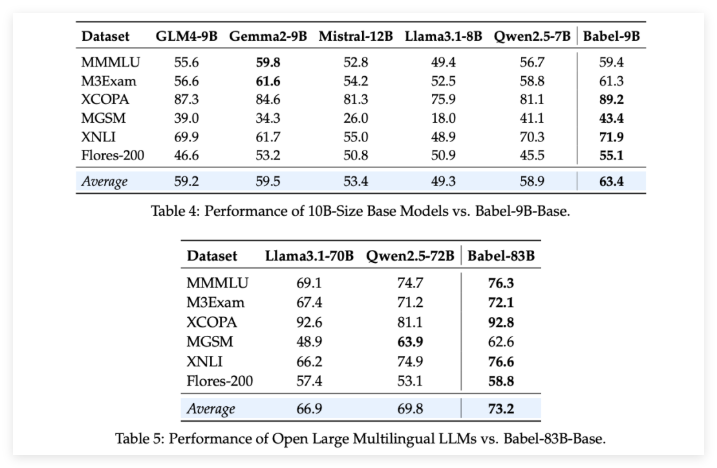

Babel의 강점을 확인하기 위해 연구팀은 여러 다국어 작업에 대한 엄격한 평가를 수행했습니다. 그 결과는 흥미 롭습니다. 90 억 패러 미터 BABEL-9B이든 830 억 패러 미터 Babel-83B이든, 여러 벤치 마크에서 동일한 규모의 다른 오픈 소스 모델을 능가합니다. 예를 들어, Babel은 World Knowledge (MMMLU, M3Exam), 추론 (MGSM, XCOPA), 이해 (XNLI) 및 번역 (FLORES-200)과 같은 작업에서 잘 수행했습니다.

Babel이 리소스-스캔 언어를 다룰 때 이전의 다국어 LLM에 비해 정확도율이 5%에서 10% 증가했음을 언급 할 가치가 있습니다. 이것은 Babel이 언어 적용 범위를 향상시키는 반면, 다양한 언어로 모델의 성능에주의를 기울이는 것을 완전히 보여줍니다.

더 놀라운 것은 백만 개가 넘는 대화 데이터 세트에서 미세 조정 (SFT)을 감독 한 후 Babel의 채팅 버전 Babel-9B-Chat 및 Babel-83B-Chat이 강력한 대화 기능을 보여 주며 성능은 일부 상업용 AI 모델과 비교할 수 있다는 것입니다. 예를 들어, Babel-83B-Chat은 특정 작업에서 GPT-4O와 경쟁 할 수있었습니다. 이것은 의심 할 여지없이 오픈 소스 커뮤니티에 새로운 활력을 주입하여 오픈 소스 모델이 다국어 기능에서 주요 위치를 차지할 수 있음을 증명합니다.

프로젝트 : https://babel-llm.github.io/babel-llm/

github : https : //github.com/babel-llm/babel-llm