Alibaba Damo Academy lanzó recientemente un gran modelo de lenguaje multilingüe llamado Babel, con el objetivo de romper las barreras del lenguaje global y permitir que la inteligencia artificial comprenda y se comunique utilizando el lenguaje de más del 90% de la población mundial. Este movimiento innovador marca un paso importante en el campo del procesamiento del lenguaje.

En la actualidad, muchos modelos de idiomas grandes se centran en idiomas ricos en recursos como inglés, francés y alemán, mientras que los idiomas con una gran base de usuarios como hindi, bengalí y urdu a menudo se pasan por alto. Este fenómeno es similar a la situación en la que los usuarios de lenguaje pequeño a menudo son marginados en conferencias globales.

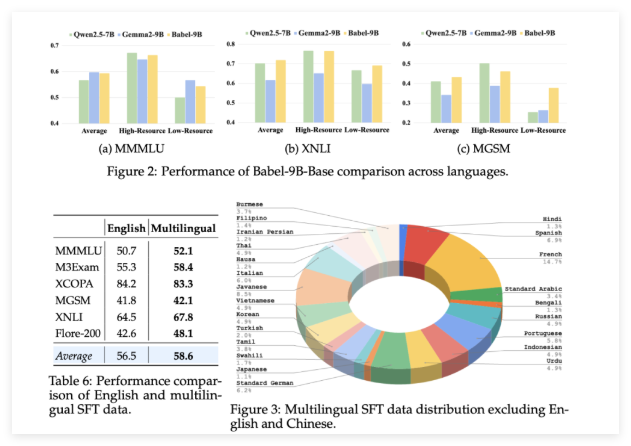

Babel fue lanzado para cambiar esta situación. El modelo apoya los 25 idiomas más hablados del mundo, que cubre más del 90% de la población mundial. Más importante aún, Babel también presta especial atención a Swahili, Javanese, Birmanes y otros idiomas que rara vez se encuentran en LLM de código abierto. Este movimiento traerá servicios de idiomas AI más convenientes y mejores a miles de millones de personas que usan estos idiomas.

A diferencia de los métodos continuos de pre-entrenamiento tradicionales, Babel utiliza una tecnología de expansión de capa única para mejorar las capacidades del modelo. Este método puede entenderse como una "reserva de conocimiento" creciente de una manera más sofisticada basada en el modelo original, mejorando así el rendimiento al tiempo que garantiza la eficiencia informática. El equipo de investigación lanzó dos modelos distintivos: Babel-9B, optimizado para una eficiente inferencia de GPU y ajuste fino; y Babel-83b, un "grande" de 83 mil millones de parámetros destinados a establecer un nuevo punto de referencia para LLM multilingüe de código abierto.

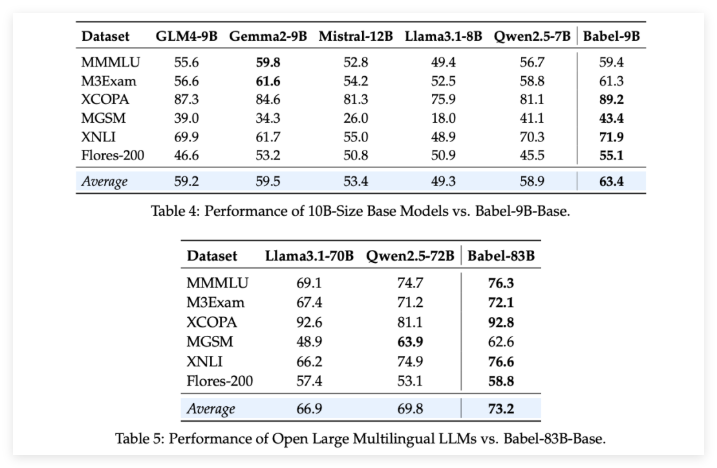

Para verificar la fuerza de Babel, el equipo de investigación realizó evaluaciones rigurosas en múltiples tareas multilingües. Los resultados son emocionantes: ya sea el Babel-9B de 9 mil millones de parámetros o el Babel-83b de 83 mil millones de parámetros, supera otros modelos de código abierto de la misma escala en múltiples puntos de referencia. Por ejemplo, Babel se desempeñó bien en tareas como el conocimiento mundial (MMMLU, M3EXAM), el razonamiento (MGSM, XCOPA), la comprensión (XNLI) y la traducción (Flores-200).

Vale la pena mencionar que cuando Babel trata con idiomas de escasez de recursos, su tasa de precisión ha aumentado en un 5% a 10% en comparación con la LLM multilingüe anterior. Esto demuestra completamente que, si bien Babel mejora la cobertura del idioma, también presta atención al rendimiento del modelo en varios idiomas.

Lo que es aún más sorprendente es que después de un ajuste superior (SFT) supervisado en más de un millón de conjuntos de datos de conversación, las versiones de chat de Babel Babel-9b-chat y Babel-83b-chat demuestran fuertes capacidades de conversación, y su rendimiento es incluso comparable a algunos de los principales modelos de IA comerciales. Por ejemplo, Babel-83b-Chat ha podido competir con GPT-4O en ciertas tareas. Esto indudablemente inyecta una nueva vitalidad en la comunidad de código abierto, lo que demuestra que el modelo de código abierto también puede ganar una posición de liderazgo en las capacidades multilingües.

Proyecto: https://babel-llm.github.io/babel-llm/

github: https: //github.com/babel-llm/babel-llm