Alibaba Damo Academy a récemment publié un grand modèle de langue multilingue appelée Babel, visant à briser les barrières linguistiques mondiales et à permettre à l'intelligence artificielle de comprendre et de communiquer en utilisant la langue de plus de 90% de la population mondiale. Cette décision innovante marque une étape importante dans le domaine du traitement des langues.

À l'heure actuelle, de nombreux modèles de grande langue se concentrent sur des langues riches en ressources telles que l'anglais, le français et l'allemand, tandis que les langues avec une grande base d'utilisateurs tels que l'hindi, le bengali et l'ourdou sont souvent négligées. Ce phénomène est similaire à la situation dans laquelle les petits utilisateurs de langues sont souvent marginalisés dans les conférences mondiales.

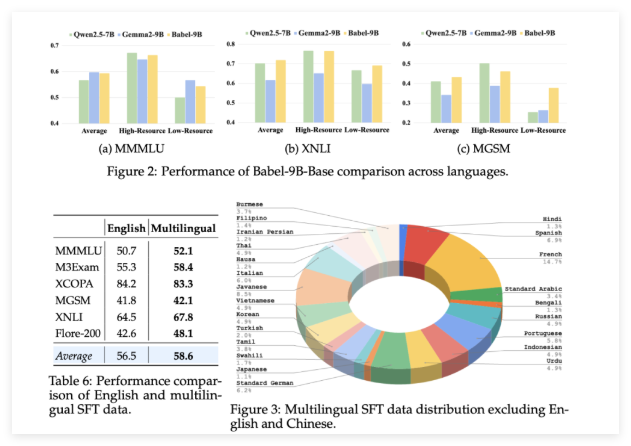

Babel a été lancé pour changer cette situation. Le modèle soutient les 25 langues les plus parlées du monde, couvrant plus de 90% de la population mondiale. Plus important encore, Babel accorde également une attention particulière au swahili, javanais, birmane et d'autres langues qui se trouvent rarement dans l'open source LLM. Cette décision apportera des services linguistiques plus pratiques et meilleurs à des milliards de personnes qui utilisent ces langues.

Contrairement aux méthodes de pré-formation continue traditionnelles, Babel utilise une technologie d'expansion de couche unique pour améliorer les capacités du modèle. Cette méthode peut être comprise comme une «réserve de connaissances» croissante d'une manière plus sophistiquée basée sur le modèle d'origine, améliorant ainsi les performances tout en garantissant l'efficacité informatique. L'équipe de recherche a lancé deux modèles distinctifs: Babel-9b, optimisé pour une inférence unique à GPU et un réglage fin; et Babel-83b, un "grand paramètre" de 83 milliards de paramètres visant à définir une nouvelle référence pour l'Open Source multilingue LLM.

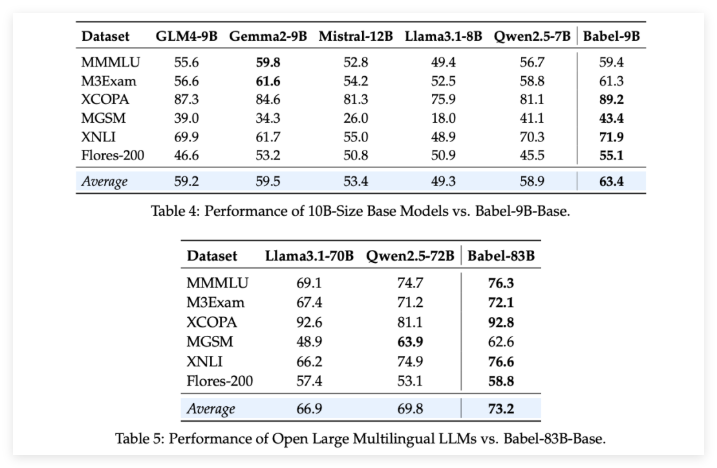

Pour vérifier la force de Babel, l'équipe de recherche a effectué des évaluations rigoureuses sur plusieurs tâches multilingues. Les résultats sont passionnants: qu'il s'agisse du BABEL-9B de 9 milliards de paramètres ou du paramètre de 83 milliards BABEL-83B, il dépasse d'autres modèles open source de la même échelle dans plusieurs repères. Par exemple, Babel a bien performé dans les tâches telles que les connaissances mondiales (MMMLU, M3Exam), le raisonnement (MGSM, XCOPA), la compréhension (XNLI) et la traduction (Flores-200).

Il convient de mentionner particulièrement que lorsque Babel s'occupe des langues de scarce des ressources, son taux de précision a augmenté de 5% à 10% par rapport à la LLM multilingue précédente. Cela démontre entièrement que si Babel améliore la couverture du langage, il fait également attention aux performances du modèle dans diverses langues.

Ce qui est encore plus surprenant, c'est qu'après un réglage fin supervisé (SFT) sur plus d'un million de jeux de données de conversation, les versions de chat de Babel Babel-9b-chat et Babel-83b-chat démontrent de fortes capacités conversationnelles, et leurs performances sont même comparables à certains meilleurs modèles d'IA commerciaux. Par exemple, Babel-83B-chat a pu rivaliser avec GPT-4O sur certaines tâches. Cela injecte sans aucun doute une nouvelle vitalité dans la communauté open source, prouvant que le modèle open source peut également acquérir une position de leader en capacités multilingues.

Projet: https://babel-llm.github.io/babel-llm/

github: https: //github.com/babel-llm/babel-llm