Die Alibaba Damo Academy hat kürzlich ein großes mehrsprachiges Sprachmodell namens Babel veröffentlicht, das darauf abzielt, die globalen Sprachbarrieren zu brechen und künstliche Intelligenz zu ermöglichen, mithilfe der Sprache von mehr als 90% der Weltbevölkerung zu verstehen und zu kommunizieren. Dieser innovative Schritt markiert einen wichtigen Schritt im Bereich der Sprachverarbeitung.

Gegenwärtig konzentrieren sich viele große Sprachmodelle auf ressourcenreiche Sprachen wie Englisch, Französisch und Deutsch, während Sprachen mit einer großen Benutzerbasis wie Hindi, Bengali und Urdu häufig übersehen werden. Dieses Phänomen ähnelt der Situation, in der Benutzer kleiner Sprache in globalen Konferenzen häufig marginalisiert werden.

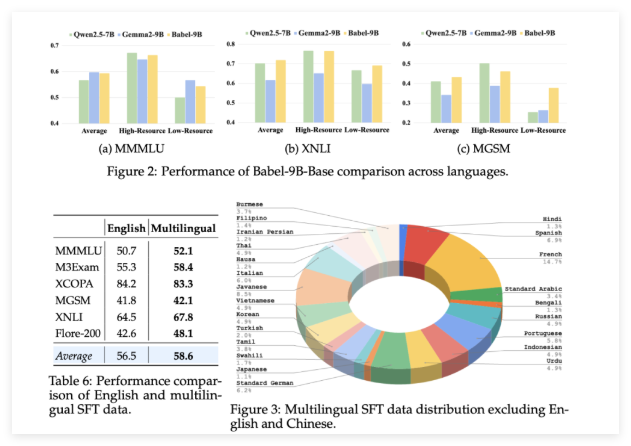

Babel wurde ins Leben gerufen, um diese Situation zu ändern. Das Modell unterstützt die 25 gesprochenen Sprachen der Welt und deckt mehr als 90% der Weltbevölkerung ab. Noch wichtiger ist, dass Babel auch Swahili, Javaner, Burmesisch und anderen Sprachen, die in Open Source LLM selten zu finden sind, besondere Aufmerksamkeit schenkt. Dieser Schritt wird Milliarden von Menschen, die diese Sprachen nutzen, bequemere und bessere KI -Sprachdienste mit sich bringen.

Im Gegensatz zu herkömmlichen kontinuierlichen Methoden vor dem Training verwendet Babel die einzigartige Schicht-Expansionstechnologie, um die Fähigkeiten des Modells zu verbessern. Diese Methode kann als zunehmender "Wissensreserve" auf basierend auf dem ursprünglichen Modell verstärkter verstanden werden, wodurch die Leistung verbessert wird und gleichzeitig die Recheneffizienz gewährleistet. Das Forschungsteam startete zwei unterschiedliche Modelle: Babel-9b, optimiert für eine effiziente Single-GPU-Inferenz und Feinabstimmung; und Babel-83b, ein 83-Milliarden-Parameter "Big", der darauf abzielt, einen neuen Benchmark für mehrsprachige Open-Source-LLM zu setzen.

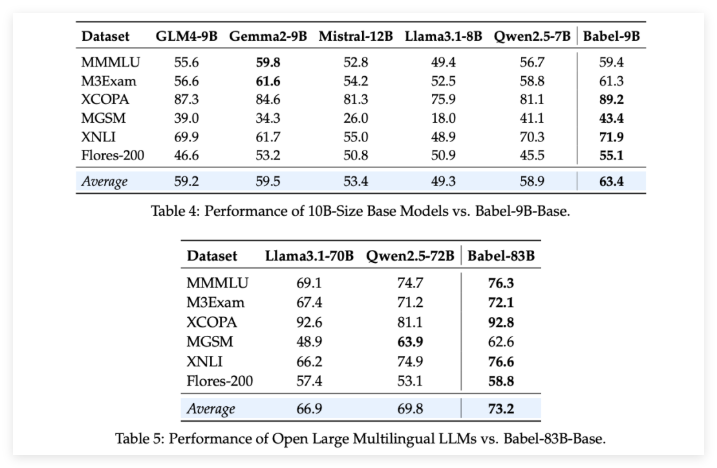

Um Babels Stärke zu überprüfen, führte das Forschungsteam strenge Bewertungen an mehreren mehrsprachigen Aufgaben durch. Die Ergebnisse sind aufregend: Egal, ob es sich um den 9-Milliarden-Parameter-Babel-9B oder der 83-Milliarden-Parameter-Babel-83B handelt, und übertrifft andere Open-Source-Modelle derselben Maßstab in mehreren Benchmarks. Zum Beispiel hat Babel bei Aufgaben wie World Knowledge (MMMLU, M3Exam), Argumentation (MGSM, XCOPA), Verständnis (XNLI) und Übersetzung (Flores-200) gut abgebildet.

Es ist besonders erwähnenswert, dass Babel, wenn sich Babel mit Ressourcen-Scarce-Sprachen befasst, seine Genauigkeitsrate im Vergleich zu früheren mehrsprachigen LLM um 5% auf 10% gestiegen ist. Dies zeigt vollständig, dass Babel zwar die Sprachabdeckung verbessert, es jedoch auch auf die Leistung des Modells in verschiedenen Sprachen achtet.

Noch überraschender ist, dass Babel-9B-CHAT und Babel-83B-Chat nach beaufsichtigten Feinabstimmungen (SFT) in mehr als einer Million Gesprächsdatensätzen starke Gesprächsfunktionen demonstrieren und ihre Leistung sogar mit einigen kommerziellen AI-Modellen vergleichbar ist. Zum Beispiel konnte Babel-83b-Chat mit GPT-4O bei bestimmten Aufgaben konkurrieren. Dies verleiht der Open -Source -Community zweifellos neue Vitalität und beweist, dass das Open -Source -Modell auch eine führende Position in mehrsprachigen Funktionen gewinnen kann.

Projekt: https://babel-lm.github.io/babel-llm/

GitHub: https: //github.com/babel-llm/babel-llm