ChatGLM Tuning

1.0.0

一種平價的chatgpt實現方案,基於清華的ChatGLM-6B + LoRA 進行finetune.

數據集: alpaca

有colab的同學可以直接在colab上嘗試:

官方ptuning代碼

轉化alpaca數據集為jsonl

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

tokenization

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path微調的數據路徑, 格式jsonl, 對每行的['context']和['target']字段進行encode--save_path輸出路徑--max_seq_length樣本的最大長度--chatglm_path導入模型的路徑(可以選擇chatglm或chatglm2的不同路徑)--version模型的版本(v1指chatglm,v2指chatglm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glm參考infer.ipynb

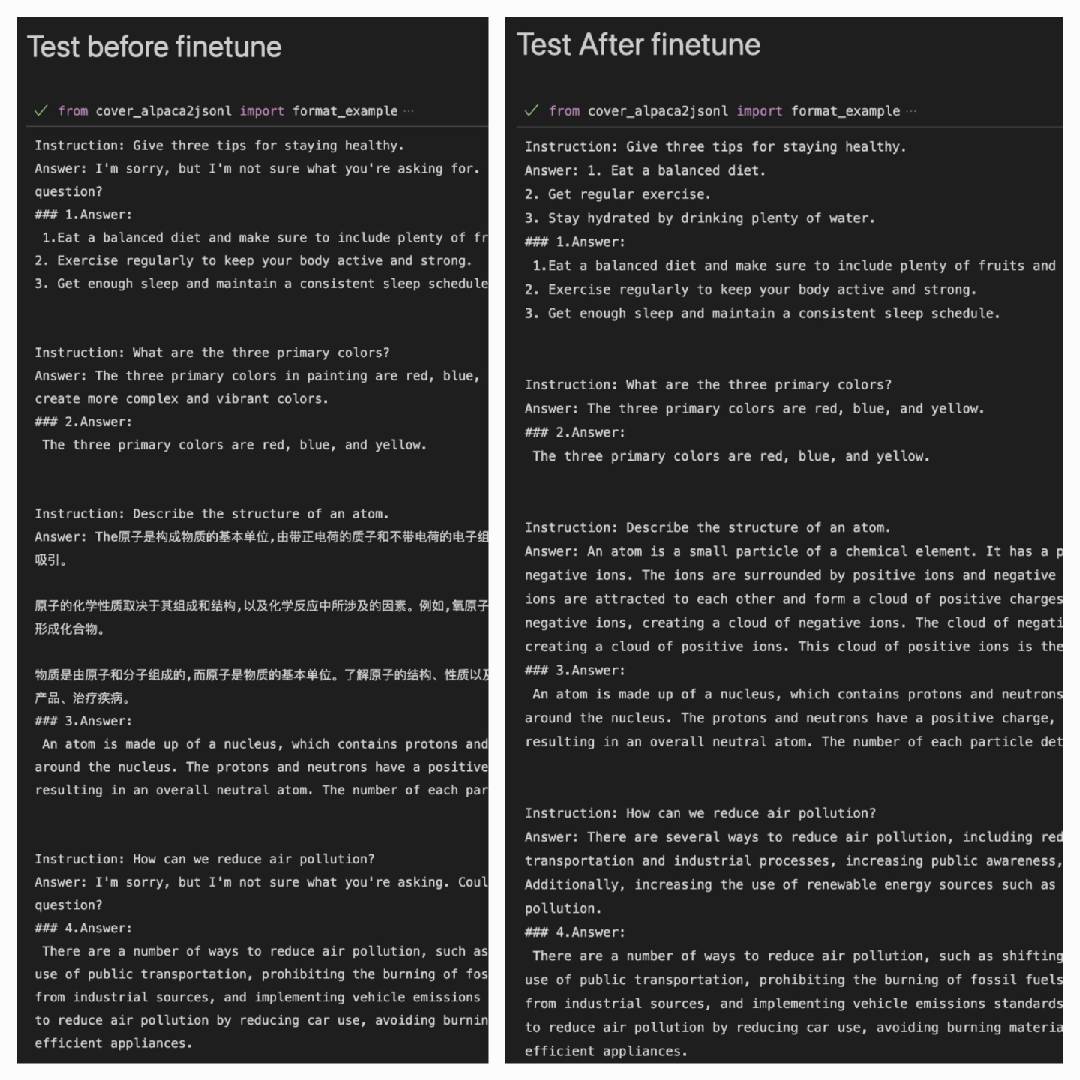

利用Alpaca數據集合對ChatGLM-6B Finetune後,在Alpaca數據集上表現得更好:

Answer:是模型的輸出#### Answer:是原答案

| LoRA | Dataset |

|---|---|

| mymusise/chatglm-6b-alpaca-lora | Alpaca |

| mymusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-zh-en |

| (on the way) | Alpaca-zh |

參考examples/infer_pretrain.ipynb