ChatGLM Tuning

1.0.0

Solusi implementasi chatgpt yang terjangkau, Finetune berdasarkan chatglm-6b + lora Tsinghua.

Dataset: Alpaca

Siswa dengan Colab dapat mencobanya langsung di Colab:

Kode Ptuning Resmi

Konversi dataset alpaca ke jsonl

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

Tokenisasi

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path jalur data yang disesuaikan, format jsonl, encode bidang ['konteks'] dan ['target'] dari setiap baris--save_path--max_seq_length Panjang maksimum--chatglm_path untuk mengimpor jalur model (Anda dapat memilih jalur chatglm atau chatglm2 yang berbeda)--version Model Versi (V1 mengacu pada chatglm, V2 mengacu pada chatglm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmReferensi infer.ipynb

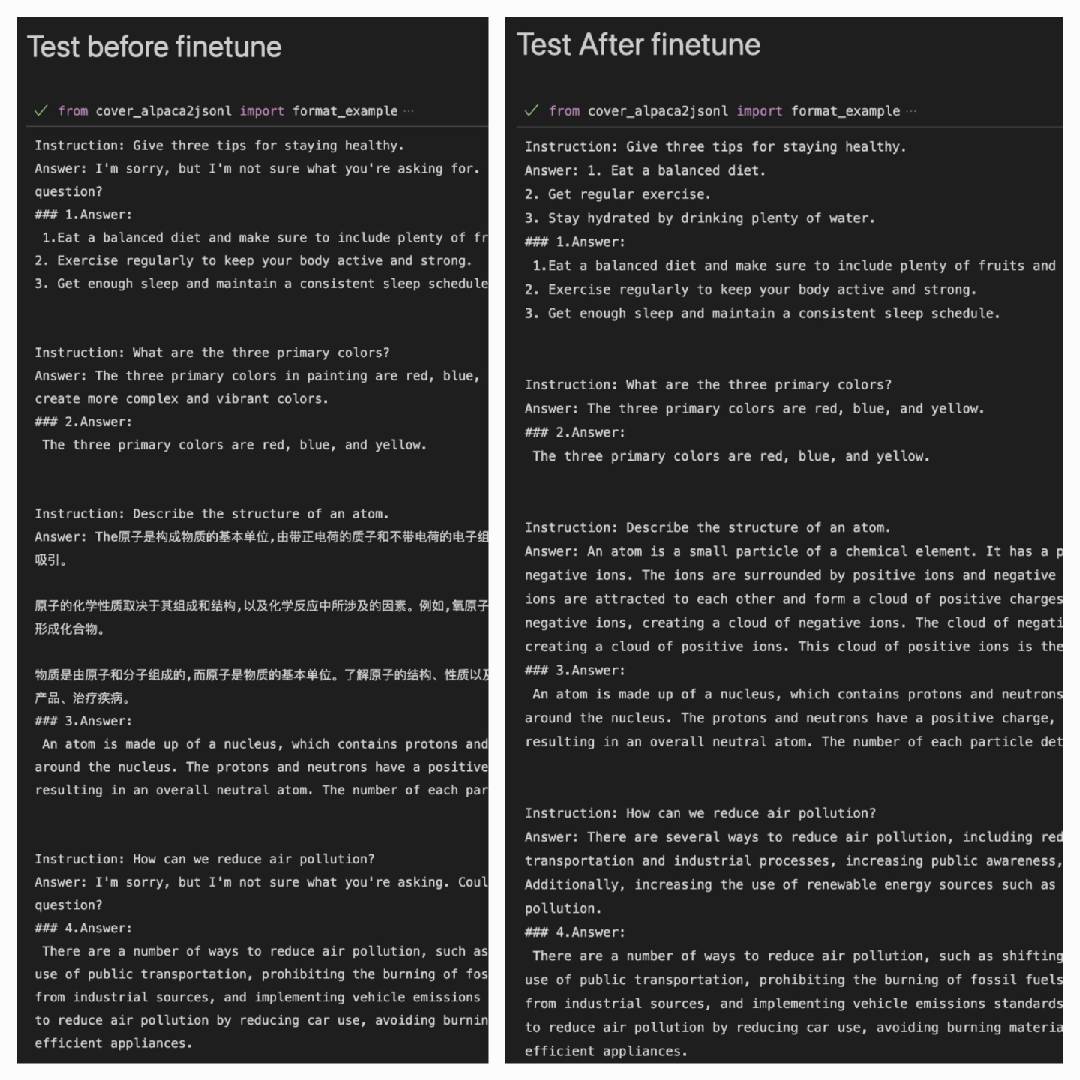

Setelah menggunakan dataset ALPACA untuk melakukan lebih baik pada dataset ALPACA:

Answer: Ini adalah output dari model#### Answer: Ini jawaban aslinya

| Lora | Dataset |

|---|---|

| myMusise/chatglm-6b-alpaca-lora | Alpaca |

| myMusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-zh-en |

| (dalam perjalanan) | Alpaca-Zh |

Lihat Contoh/infer_prain.ipynb