ChatGLM Tuning

1.0.0

Una solución de implementación de CHATGPT asequible, Finetune basada en el chatglm-6b + lora de Tsinghua.

Conjunto de datos: alpaca

Los estudiantes con Colab pueden probarlo directamente en Colab:

Código oficial de Ptuning

Convertir el conjunto de datos de Alpaca a JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

tokenización

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path ruta de datos ajustada, formato jsonl, codifica los campos ['context'] y ['objetivo'] de cada fila--save_path ruta de salida--max_seq_length muestra longitud máxima--chatglm_path para importar la ruta del modelo (puede elegir diferentes rutas de chatglm o chatglm2)--version del modelo de Version (V1 se refiere a ChatGlm, V2 se refiere a ChatGlm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmReferencia infer.ipynb

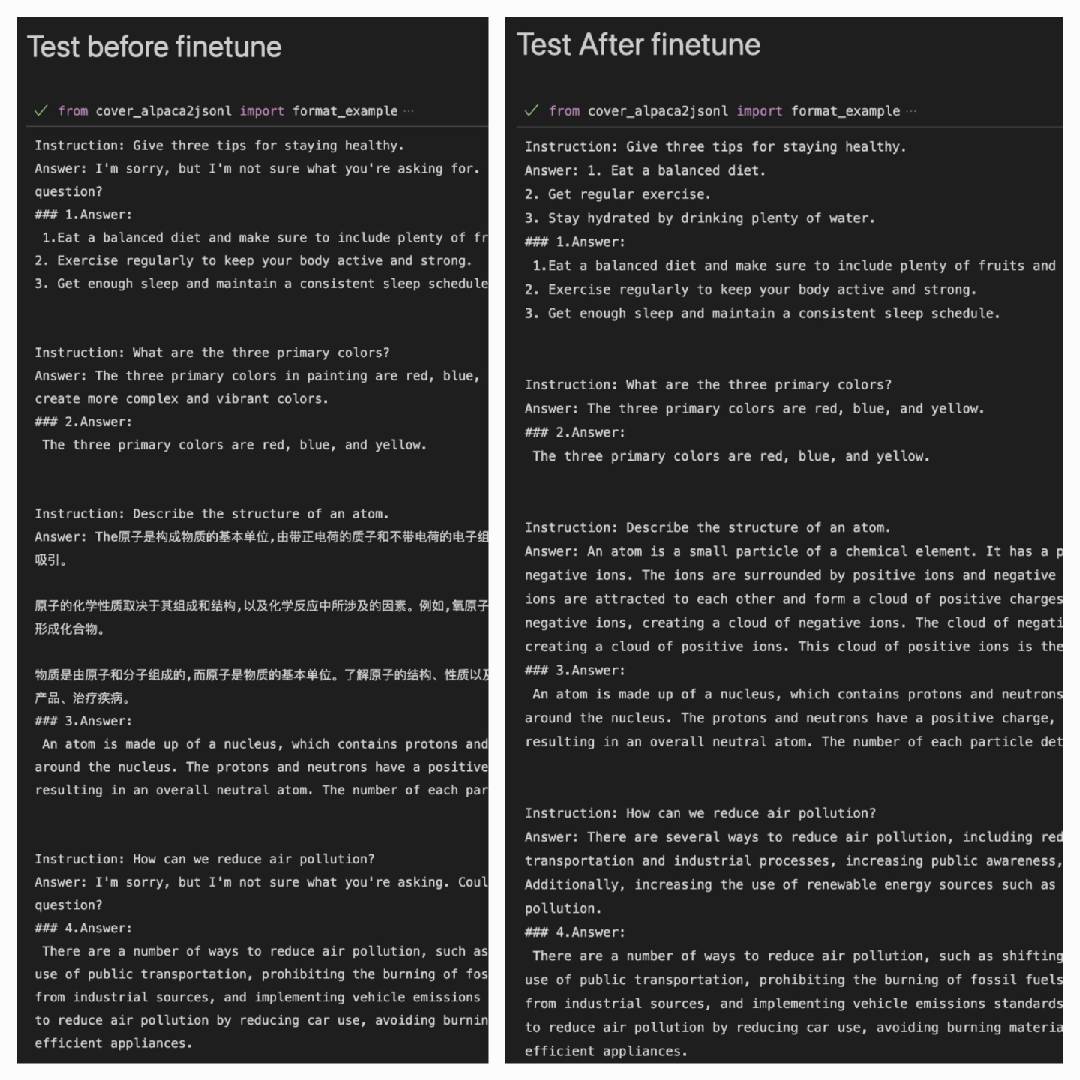

Después de usar el conjunto de datos Alpaca para funcionar mejor en el conjunto de datos Alpaca:

Answer: es la salida del modelo#### Answer: es la respuesta original

| Lora | Conjunto de datos |

|---|---|

| mymusise/chatglm-6b-alpaca-lora | Alpaca |

| mymusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-zh-en |

| (en el camino) | Alpaca-zh |

Consulte Ejemplos/infer_prain.ipynb