ChatGLM Tuning

1.0.0

저렴한 Chatgpt 구현 솔루션, Tsinghua의 ChatGLM-6B + LORA를 기반으로 한 Finetune.

데이터 세트 : 알파카

Colab을 가진 학생들은 Colab에서 직접 시도 할 수 있습니다.

공식 ptuning 코드

Alpaca 데이터 세트를 JSONL로 변환하십시오

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

토큰 화

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path 미세 조정 된 데이터 경로, 형식 JSONL, [ 'context'] 및 [ 'target'] 각 행의 필드를 인코딩합니다.--save_path 출력 경로--max_seq_length 샘플 최대 길이--chatglm_path 모델의 경로를 가져 오기 위해 (chatglm 또는 chatglm2의 다른 경로를 선택할 수 있습니다)--version 모델 버전 (v1은 Chatglm, v2는 chatglm2를 나타냅니다)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glm참조 lent.ipynb

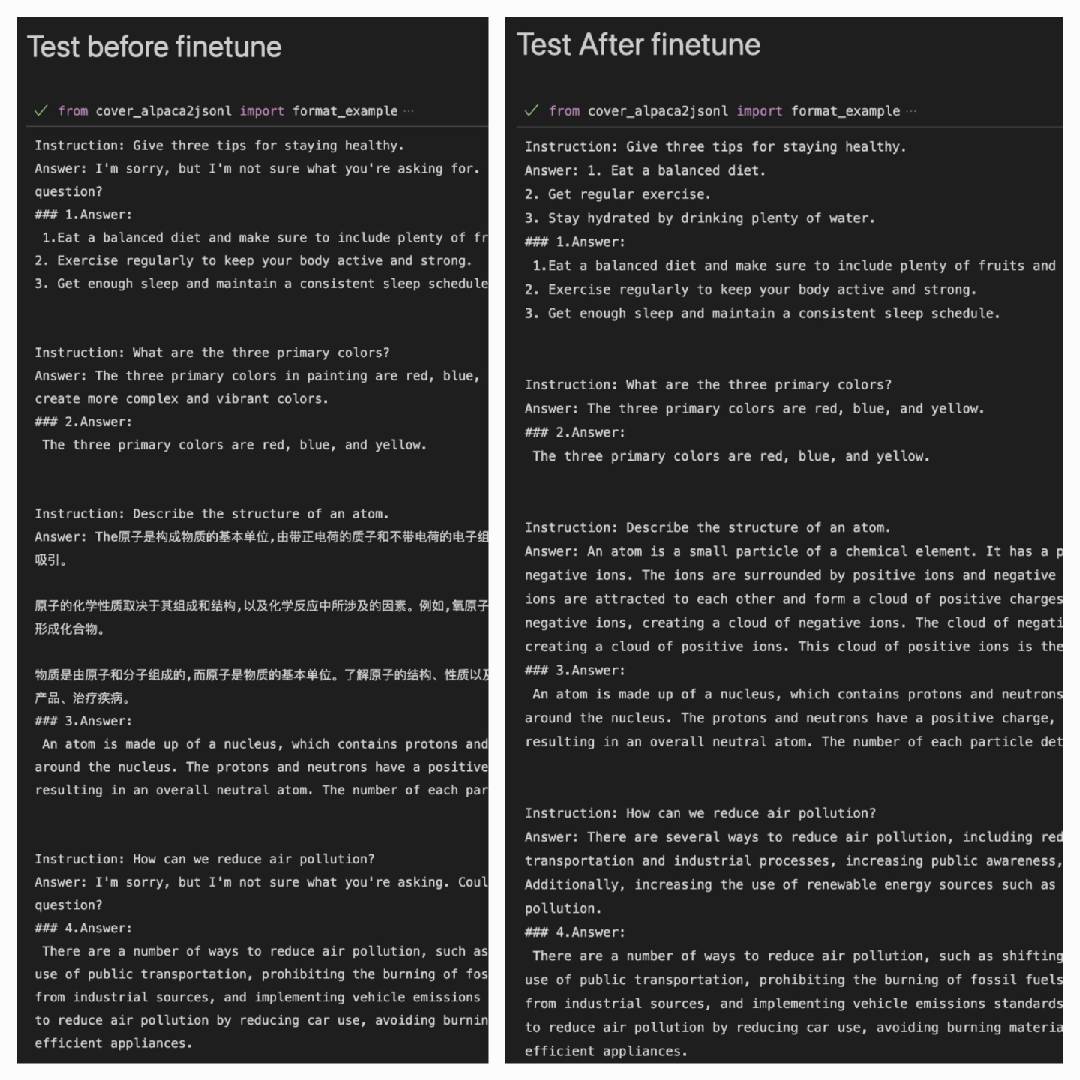

Alpaca 데이터 세트를 사용하여 Alpaca 데이터 세트에서 더 잘 수행 한 후 :

Answer: 모델의 출력입니다#### Answer: 원래 답변입니다

| 로라 | 데이터 세트 |

|---|---|

| MyMusise/ChatGLM-6B-Alpaca-lora | 알파카 |

| MyMusise/ChatGLM-6B-Alpaca-Zh-en-lora | 알파카 -zh-en |

| (도중) | 알파카 -zh |

examples/ulent_pretrain.ipynb를 참조하십시오