ChatGLM Tuning

1.0.0

Une solution de mise en œuvre de ChatGPT abordable, Finetune basée sur le chatGLM-6B + Lora de Tsinghua.

Ensemble de données: alpaga

Les étudiants avec Colab peuvent l'essayer directement sur Colab:

Code de ptuning officiel

Convertir le jeu de données alpaca en JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

tokenisation

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path Chemin de données affinés, format JSONL, encodez les champs [«contextes»] et [«Target»] de chaque ligne--save_path Sortie Chemin--max_seq_length échantillon maximum longueur--chatglm_path pour importer le chemin du modèle (vous pouvez choisir différents chemins de chatglm ou chatglm2)--version (V1 fait référence à chatGLM, V2 fait référence à chatGlm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmInférieur de référence.Ipynb

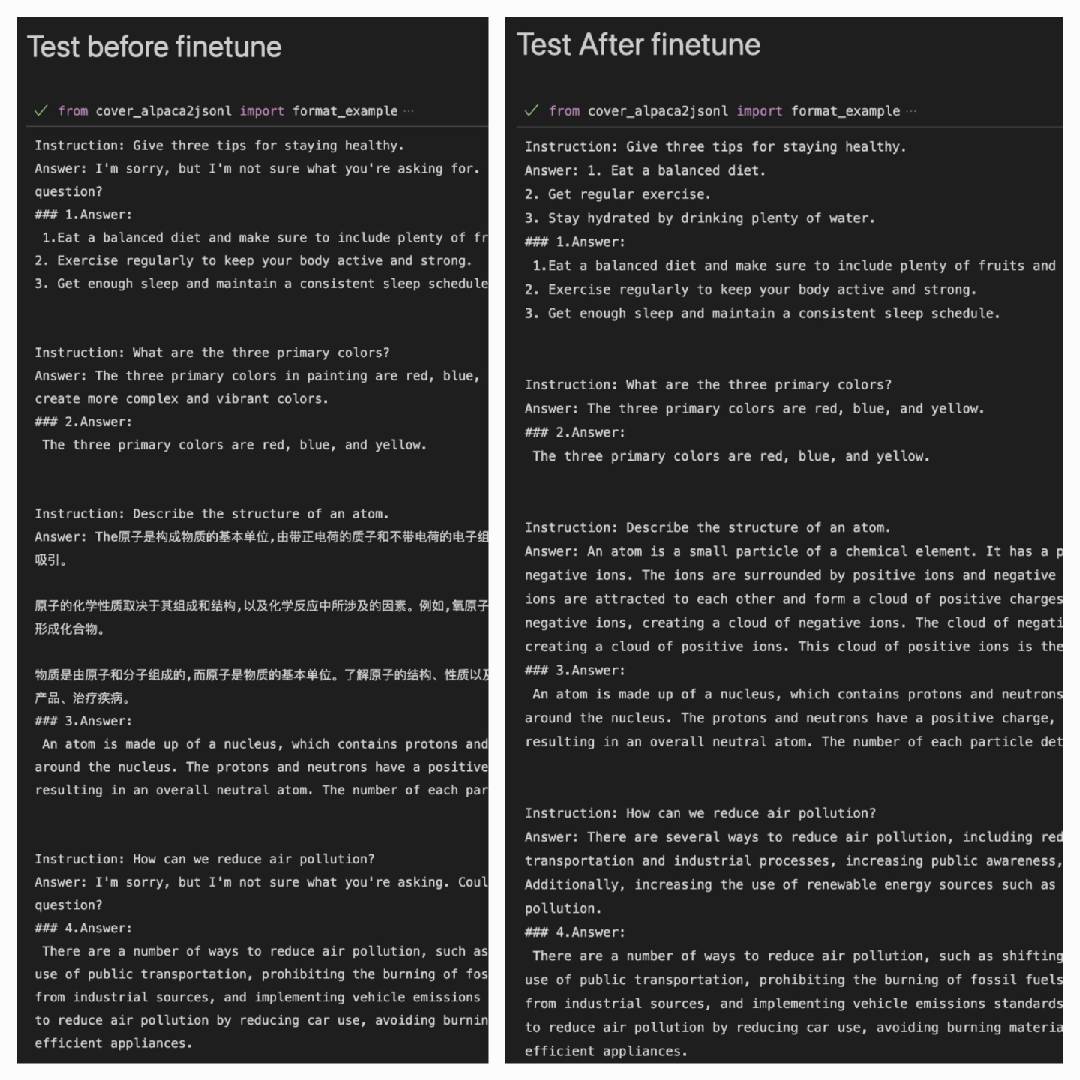

Après avoir utilisé l'ensemble de données Alpaca pour mieux fonctionner sur l'ensemble de données Alpaca:

Answer: C'est la sortie du modèle#### Answer: c'est la réponse originale

| Lora | Ensemble de données |

|---|---|

| myMusise / chatGlm-6b-alpaca-lora | Alpaga |

| myMusise / chatGlm-6b-alpaca-zh-en-lora | Alpaca-zh-en |

| (en route) | Alpaca-zh |

Reportez-vous à des exemples / inférieur_pretrain.ipynb