ChatGLM Tuning

1.0.0

โซลูชันการใช้งาน CHATGPT ราคาไม่แพง Finetune ตาม Chatglm-6b + Lora ของ Tsinghua

ชุดข้อมูล: Alpaca

นักเรียนที่มี colab สามารถลองได้โดยตรงบน colab:

รหัส ptuning อย่างเป็นทางการ

แปลงชุดข้อมูล ALPACA เป็น JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

การทำให้โทเค็น

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path เส้นทางข้อมูลที่ปรับแต่งได้รูปแบบ JSONL เข้ารหัสฟิลด์ ['บริบท'] และ ['เป้าหมาย'] ของแต่ละแถว--save_path--max_seq_length ความยาวตัวอย่างสูงสุดตัวอย่างสูงสุด--chatglm_path เพื่อนำเข้าเส้นทางของรุ่น (คุณสามารถเลือกเส้นทางที่แตกต่างกันของ chatglm หรือ chatglm2)--version เวอร์ชันเวอร์ชัน (V1 หมายถึง chatglm, v2 หมายถึง chatglm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmข้อมูลอ้างอิง IPYNB

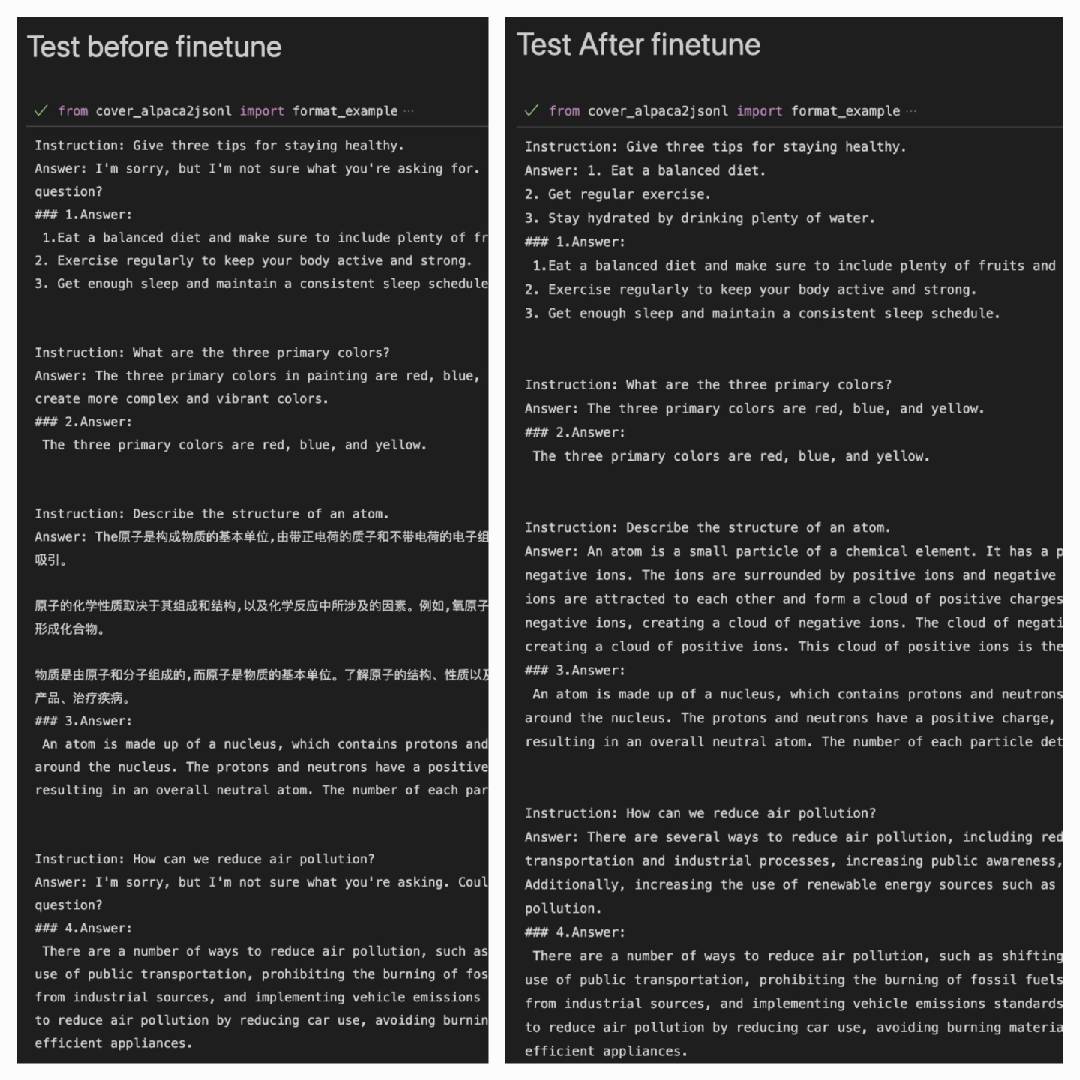

หลังจากใช้ชุดข้อมูล ALPACA เพื่อทำงานได้ดีขึ้นในชุดข้อมูล ALPACA:

Answer: มันคือผลลัพธ์ของโมเดล#### Answer: เป็นคำตอบเดิม

| Lora | ชุดข้อมูล |

|---|---|

| Mymusise/chatglm-6b-alpaca-lora | อัลปากา |

| Mymusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-Zh-en |

| (ระหว่างทาง) | Alpaca-ZH |

อ้างถึงตัวอย่าง/infer_pretrain.ipynb