ChatGLM Tuning

1.0.0

Eine erschwingliche ChatGPT-Implementierungslösung, Finetune basierend auf Tsinghuas Chatglm-6b + Lora.

Datensatz: Alpaka

Schüler mit Colab können es direkt auf Colab versuchen:

Offizieller Ptuning -Code

Konvertieren Sie den Alpaka -Datensatz in JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

Tokenisierung

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path Feine Datenpfad, Format JSONL, codieren die Felder ['Kontext'] und ['Ziel'] jeder Zeile--save_path Ausgabeweg--max_seq_length maximal maximal Länge--chatglm_path , um den Pfad des Modells zu importieren (Sie können verschiedene Pfade von Chatglm oder Chatglm2 auswählen)--version (V1 bezieht sich auf Chatglm, V2 bezieht sich auf Chatglm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmReferenz infer.ipynb

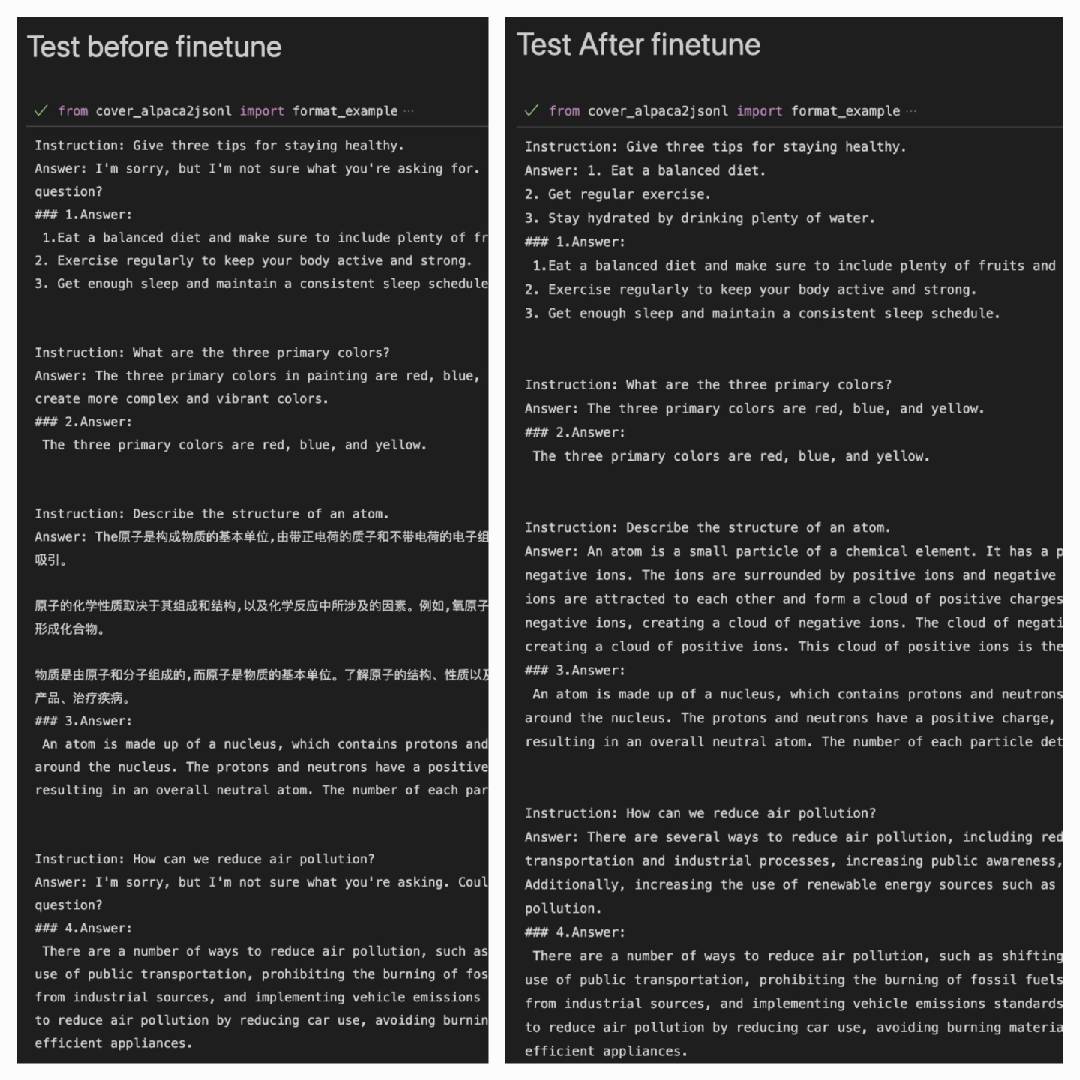

Nachdem der Alpaca -Datensatz verwendet wurde, um im Alpaca -Datensatz besser abzubauen:

Answer: Es ist die Ausgabe des Modells#### Answer: Es ist die ursprüngliche Antwort

| Lora | Datensatz |

|---|---|

| mymusise/chatglm-6b-alpaca-lora | Alpaka |

| mymusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-Zh-en |

| (unterwegs) | Alpaca-Zh |

Siehe Beispiele/Infer_Pretrain.ipynb