ChatGLM Tuning

1.0.0

手頃な価格のChatGPT実装ソリューション、TsinghuaのChatglm-6b + Loraに基づくFinetune。

データセット:アルパカ

colabを持っている学生は、colabで直接試すことができます:

公式のPtuningコード

アルパカデータセットをJSONLに変換します

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

トークン化

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path微調整されたデータパス、フォーマットjsonl、各行の['context']および['ターゲット']フィールドをエンコードします--save_path出力パス--max_seq_lengthサンプルの最大長--chatglm_pathモデルのパスをインポートする(chatglmまたはchatglm2の異なるパスを選択できます)--versionモデルバージョン(V1はchatglmを指し、v2はchatglm2を指します)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glm参照dext.ipynb

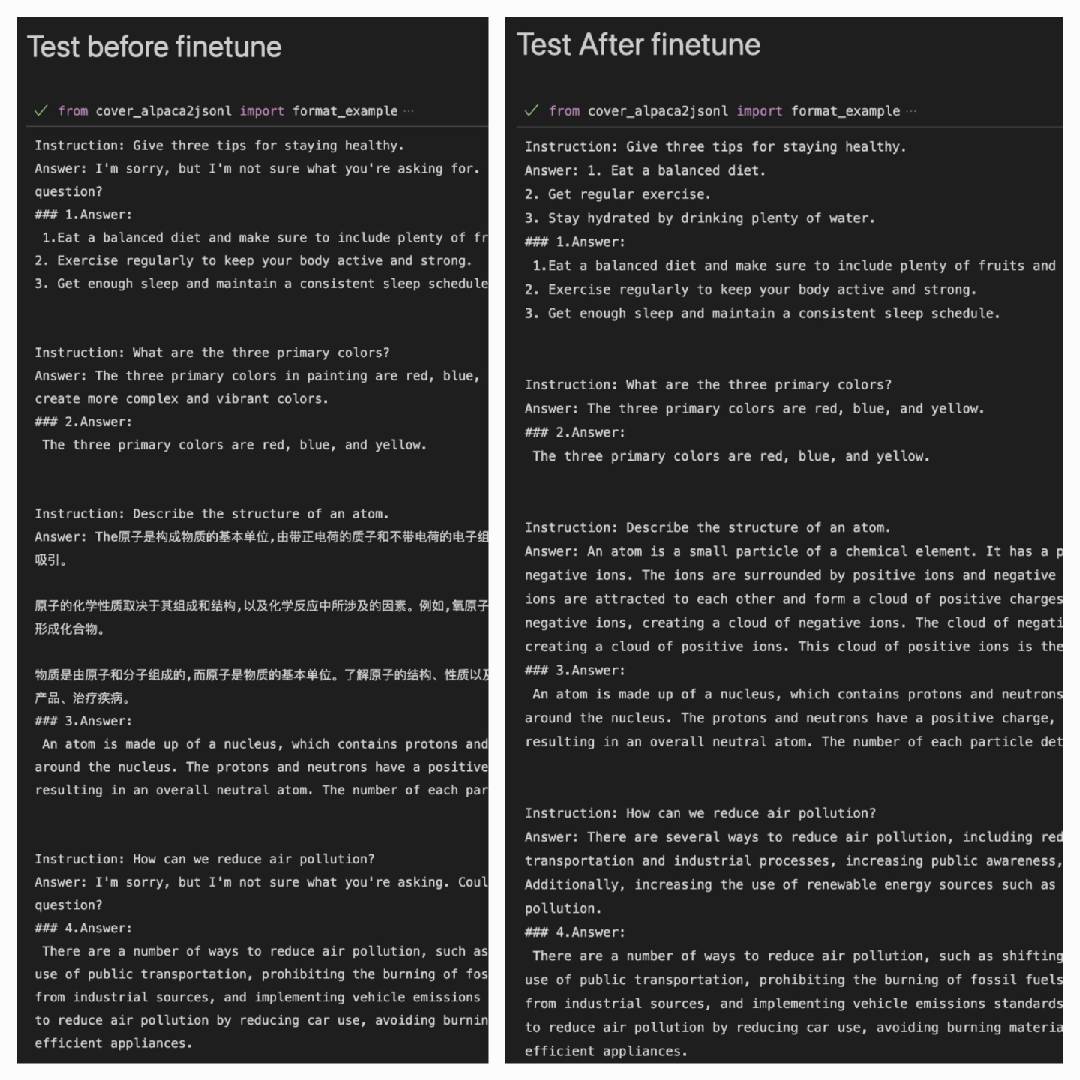

ALPACAデータセットを使用してAlpacaデータセットでより良いパフォーマンスを発揮した後:

Answer:モデルの出力です#### Answer:それは元の答えです

| ロラ | データセット |

|---|---|

| mymusise/chatglm-6b-alpaca-lora | アルパカ |

| mymusise/chatglm-6b-alpaca-zh-en-lora | Alpaca-Zh-en |

| (途中で) | Alpaca-Zh |

Examples/dems_pretrain.ipynbを参照してください