ChatGLM Tuning

1.0.0

Доступное решение для реализации CHATGPT, Finetune, основанное на чате Tsinghua от Chatglm-6b + Lora.

Набор данных: альпака

Студенты с Colab могут попробовать это прямо на Colab:

Официальный код Ptuning

Преобразовать набор данных Alpaca в JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

токенизация

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path Тонко настроенный путь данных, формат jsonl, кодируйте поля ['' context '] и [Target'] каждой строки--save_path PATH--max_seq_length--chatglm_path , чтобы импортировать путь модели (вы можете выбрать разные пути чатглм или чатглм2)--version модели версии (V1 относится к Chatglm, V2 относится к ChatGlm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmСсылка SOPER.IPYNB

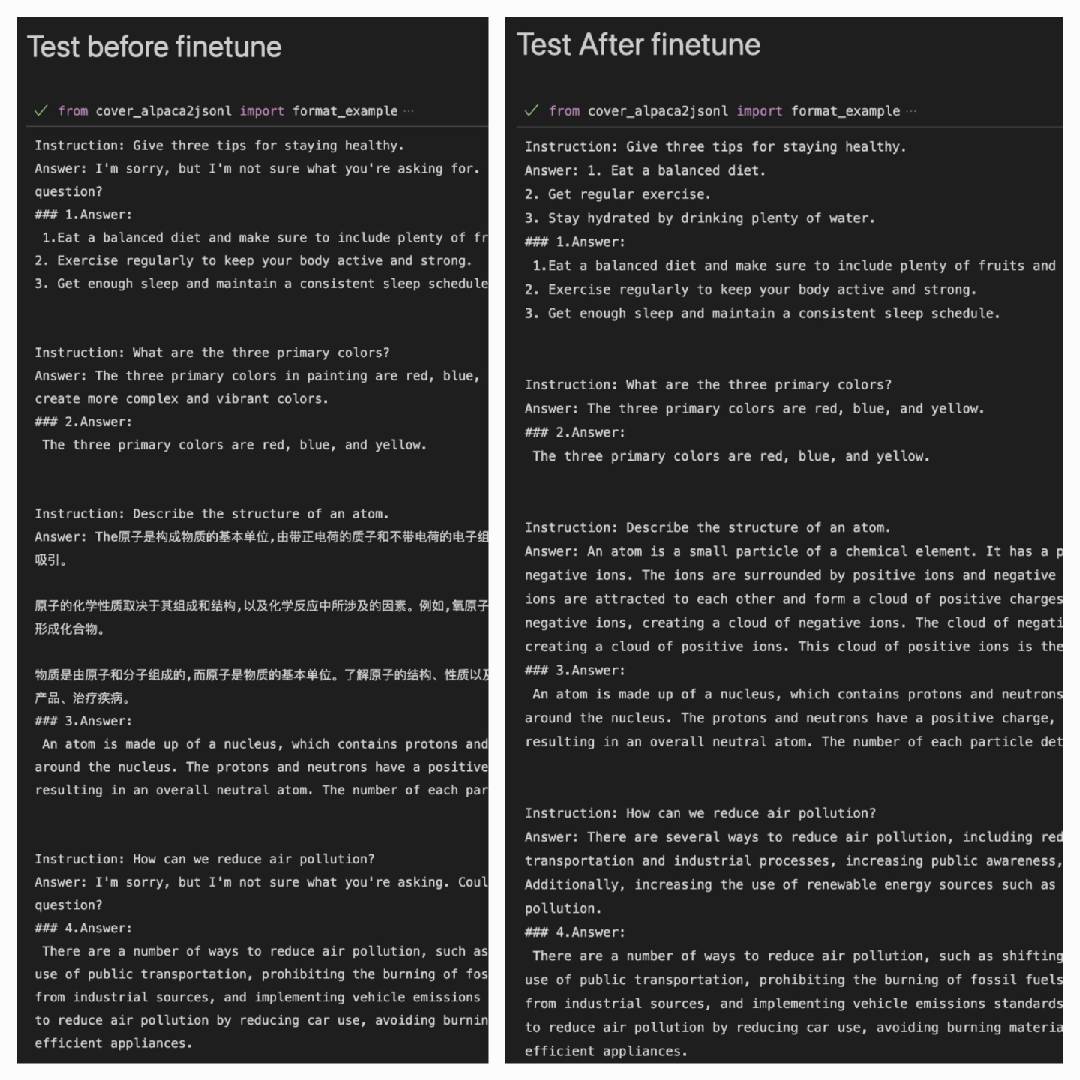

После использования набора данных Alpaca для лучшего работа в наборе данных Alpaca:

Answer: это выход модели#### Answer: это исходный ответ

| Лора | Набор данных |

|---|---|

| Mymusise/Chatglm-6b-Alpaca-Lora | Альпака |

| Mymusise/Chatglm-6b-Alpaca-Zh-en-Lora | Альпака-Zh-en |

| (в пути) | Альпака-ZH |

См. Примеры/infer_pretrain.ipynb