ChatGLM Tuning

1.0.0

حل تنفيذ ChatGPT بأسعار معقولة ، Finetune يعتمد على Tsinghua's ChatGlm-6B + Lora.

مجموعة البيانات: الألبكة

يمكن للطلاب الذين يعانون من كولاب تجربته مباشرة على كولاب:

رمز ptuning الرسمي

تحويل مجموعة بيانات الألبكة إلى JSONL

python cover_alpaca2jsonl.py

--data_path data/alpaca_data.json

--save_path data/alpaca_data.jsonl

الرمز المميز

python tokenize_dataset_rows.py

--jsonl_path data/alpaca_data.jsonl

--save_path data/alpaca

--max_seq_length 200

--skip_overlength False

--chatglm_path model_path/chatglm

--version v1

--jsonl_path مسار البيانات المضبط الدقيق ، تنسيق JSONL ، وترميز الحقول ['context'] و ['Target'] لكل صف--save_path--max_seq_length عينة الحد الأقصى الطول--chatglm_path لاستيراد مسار النموذج (يمكنك اختيار مسارات مختلفة من ChatGlm أو ChatGlm2)--version نموذج version (يشير V1 إلى ChatGlm ، يشير V2 إلى ChatGlm2)python finetune.py

--dataset_path data/alpaca

--lora_rank 8

--per_device_train_batch_size 6

--gradient_accumulation_steps 1

--max_steps 52000

--save_steps 1000

--save_total_limit 2

--learning_rate 1e-4

--fp16

--remove_unused_columns false

--logging_steps 50

--output_dir output

--chatglm_path model_path/chat_glmمرجع استنتاج

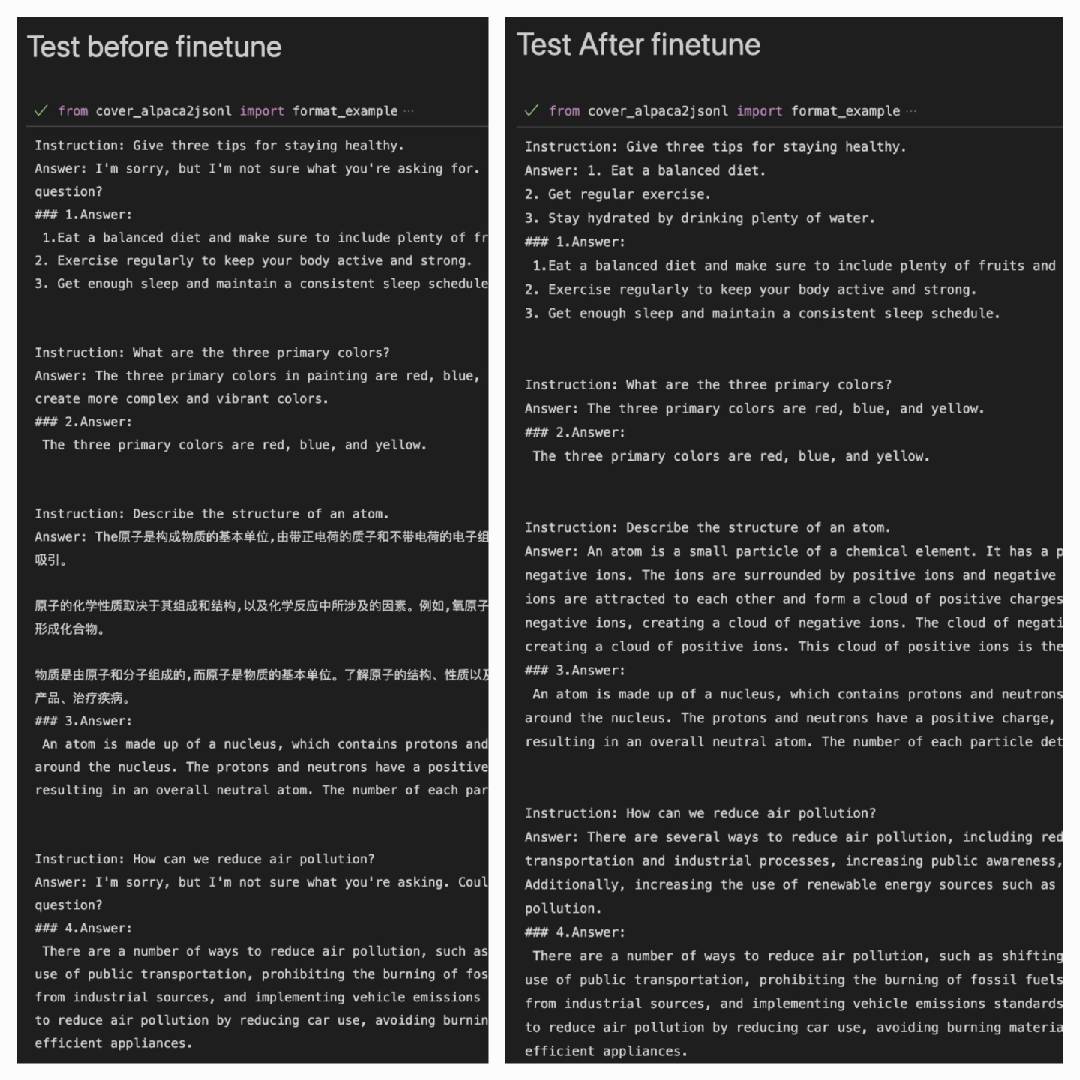

بعد استخدام مجموعة بيانات الألبكة لأداء أفضل على مجموعة بيانات الألبكة:

Answer: إنه إخراج النموذج#### Answer: إنها الإجابة الأصلية

| لورا | مجموعة البيانات |

|---|---|

| mymusise/chatglm-6b-alpaca-lora | الألبكة |

| mymusise/chatglm-6b-alpaca-zh-en-lora | الألبكة زين |

| (في الطريق) | الألبكة زي |

ارجع إلى أمثلة/inderf_pretrain.ipynb