COPEN

1.0.0

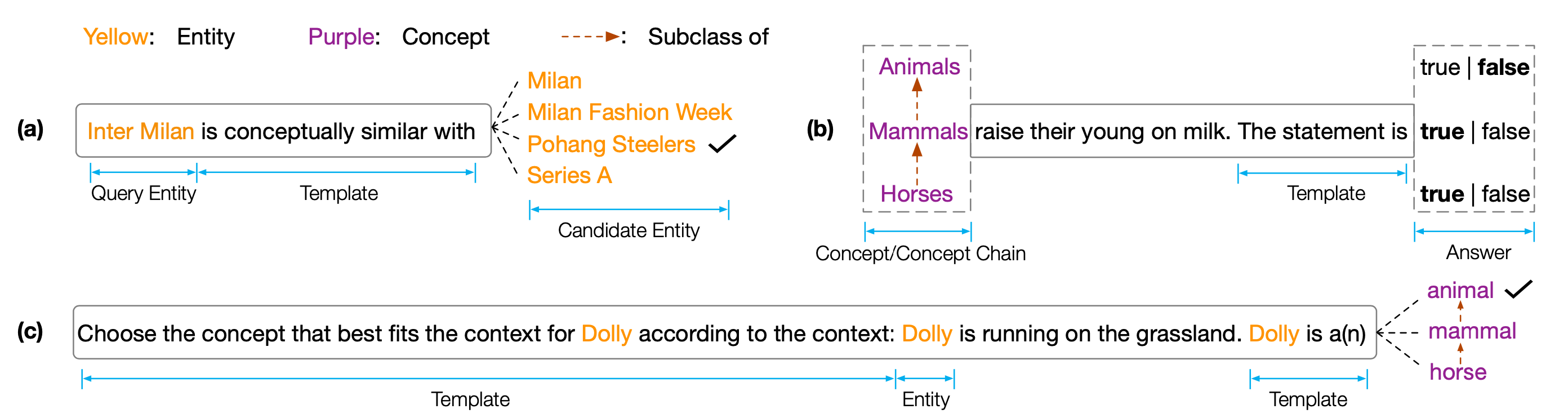

EMNLP 2022论文的数据集和代码“哥伦:探测预训练的语言模型中的概念知识”。 Copen是一种概念知识门槛基准,旨在分析预训练的语言模型(PLM)的概念理解能力。具体而言,哥伦族由三个任务组成:

对不同尺寸和类型的PLM类型的广泛实验表明,现有的PLM系统地缺乏概念知识,并且遭受了各种虚假相关性。我们认为,这是实现PLM中类似人类认知的关键瓶颈。需要更多的概念意识的目标或架构来开发概念知识渊博的PLM。

要获得测试结果,您需要将结果提交给Codalab。

代码存储库基于Pytorch和Transformers 。请使用以下命令安装所有必要的依赖性。 pip install -r requirements.txt

将副基准放置在Tsinghua Cloud上,请使用以下命令下载数据集并将其放置在预言路径中。

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42如果我们的代码或基准对您有所帮助,请引用我们:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}