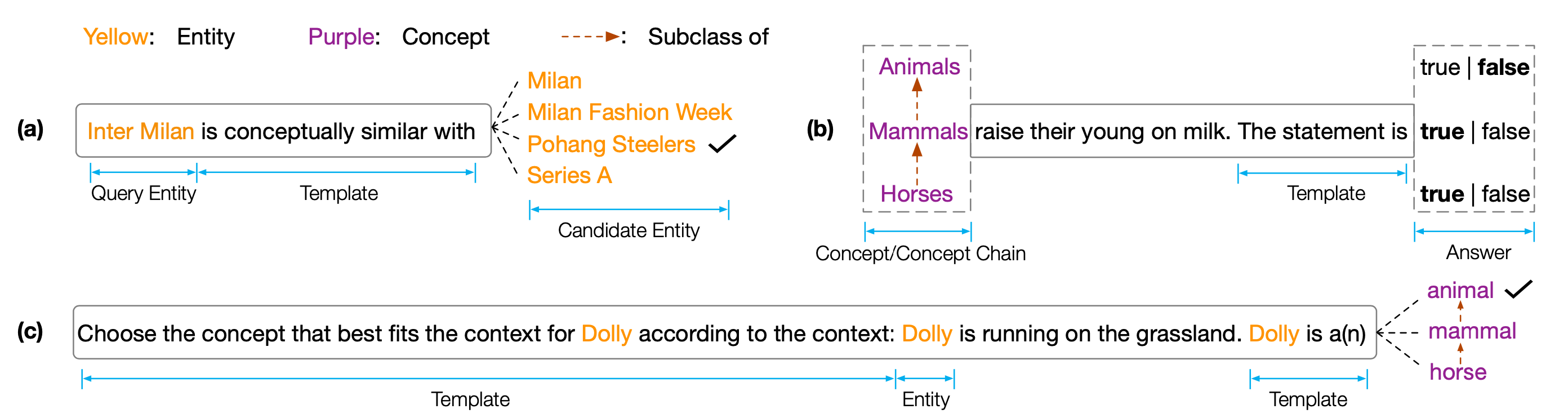

Conjunto de dados e código para o artigo do EMNLP 2022 '' Copen: sondando conhecimento conceitual em modelos de idiomas pré-treinados ''. O Copen é um conhecimento conceitual que está por referência que visa analisar as capacidades conceituais de compreensão dos modelos de linguagem pré-treinados (PLMs). Especificamente, o COPEN consiste em três tarefas:

Experiências extensas em diferentes tamanhos e tipos de PLMs mostram que os PLMs existentes não têm sistematicamente conhecimento conceitual e sofrem de várias correlações espúrias. Acreditamos que este é um gargalo crítico para realizar a cognição humana no PLMS. São necessários mais objetivos ou arquiteturas com reconhecimento de conceito para desenvolver PLMs conceituais com conhecimento.

Para obter os resultados dos testes, você precisa enviar seus resultados ao Codalab.

O repositório de código é baseado em Pytorch e Transformers . Use o seguinte comando para instalar todos os dependentes necessários. pip install -r requirements.txt

A referência Copen é colocada no Tsinghua Cloud, use o seguinte comando para baixar os conjuntos de dados e colocá -los no caminho da proporção.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42Se nossos códigos ou referência o ajudarem, cite -nos:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}