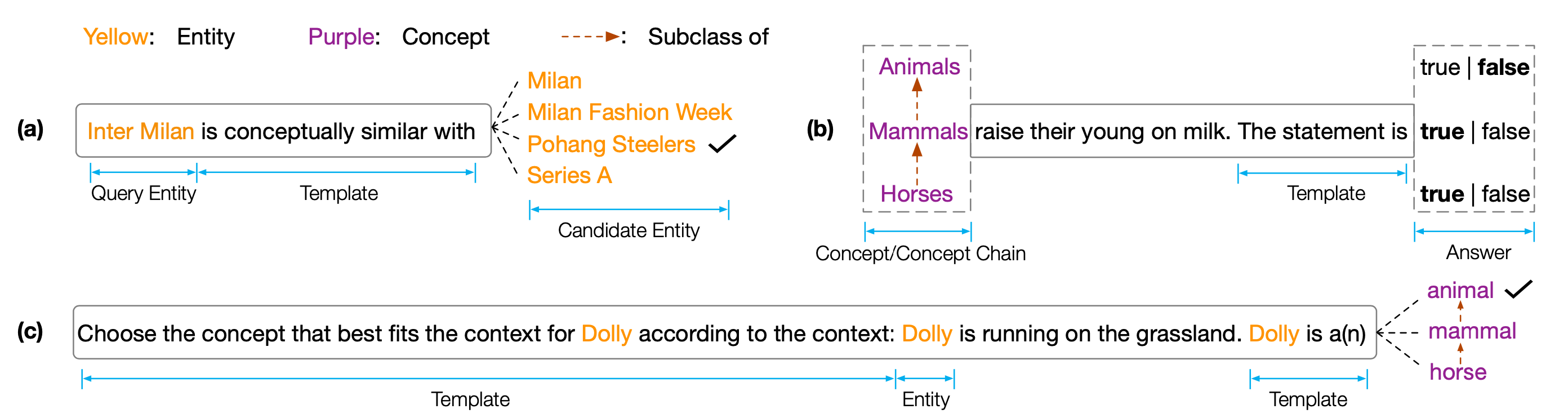

Набор данных и код для EMNLP 2022 Paper '' Copen: Зондование концептуальных знаний в предварительно обученных языковых моделях '. Копен-это концептуальный эталон знаний, который направлен на анализ концептуальных возможностей понимания моделей с предварительно обученными языками (PLMS). В частности, Копен состоит из трех задач:

Обширные эксперименты по разным размерам и типам ПЛМ показывают, что существующие ПЛМС систематически не имеют концептуальных знаний и страдают от различных ложных корреляций. Мы считаем, что это критическое узкое место для реализации человеческого познания в PLMS. Для разработки концептуальных знающих PLMS необходимы более целей или архитектуры.

Чтобы получить результаты теста, вам необходимо представить свои результаты в Codalab.

Репозиторий кода основан на Pytorch и Transformers . Пожалуйста, используйте следующую команду для установки всех необходимых зависимости. pip install -r requirements.txt

Copen Clarkmark размещен в Tsinghua Cloud, пожалуйста, используйте следующую команду для загрузки наборов данных и поместите их в путь пропорции.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42Если наши коды или эталоны помогут вам, пожалуйста, цитируйте нас:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}