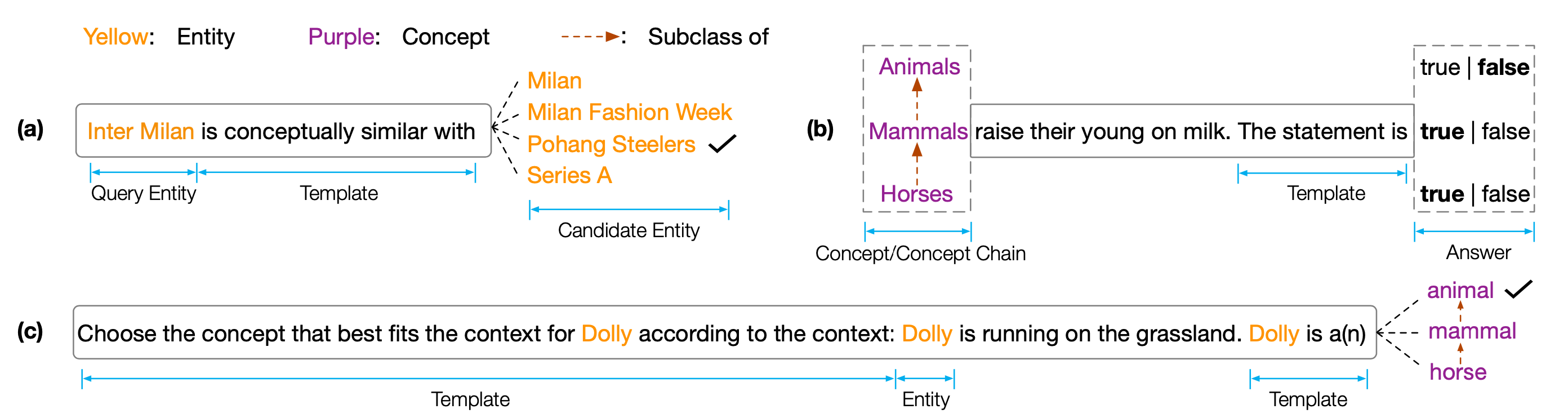

ชุดข้อมูลและรหัสสำหรับ EMNLP 2022 PAPER '' COPEN: การตรวจสอบความรู้เชิงแนวคิดในรูปแบบภาษาที่ผ่านการฝึกอบรมมาก่อน '' Copen เป็นเกณฑ์มาตรฐานความรู้เชิงความรู้ซึ่งมีจุดมุ่งหมายเพื่อวิเคราะห์ความสามารถในการทำความเข้าใจแนวคิดของแบบจำลองภาษาที่ผ่านการฝึกอบรมมาก่อน (PLMS) โดยเฉพาะอย่างยิ่งโคเปนประกอบด้วยสามงาน:

การทดลองอย่างกว้างขวางเกี่ยวกับขนาดและประเภทของ PLMs ที่แตกต่างกันแสดงให้เห็นว่า PLM ที่มีอยู่นั้นขาดความรู้เชิงแนวคิดอย่างเป็นระบบและต้องทนทุกข์ทรมานจากความสัมพันธ์ปลอมต่างๆ เราเชื่อว่านี่เป็นคอขวดที่สำคัญสำหรับการตระหนักถึงความรู้ความเข้าใจเหมือนมนุษย์ใน PLMS จำเป็นต้องมีวัตถุประสงค์หรือสถาปัตยกรรมที่ตระหนักถึงแนวคิดเพิ่มเติมเพื่อพัฒนา PLM ที่มีความรู้เชิงแนวคิด

ในการรับผลการทดสอบคุณต้องส่งผลลัพธ์ของคุณไปยัง Codalab

ที่เก็บรหัสขึ้นอยู่กับ Pytorch และ Transformers โปรดใช้คำสั่งต่อไปนี้เพื่อติดตั้งสิ่งที่จำเป็นทั้งหมด pip install -r requirements.txt

เกณฑ์มาตรฐานของ Copen ถูกวางไว้บนคลาวด์ Tsinghua โปรดใช้คำสั่งต่อไปนี้เพื่อดาวน์โหลดชุดข้อมูลและวางไว้ในเส้นทางของผู้สนับสนุน

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42หากรหัสหรือมาตรฐานของเราช่วยคุณโปรดอ้างอิงเรา:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}