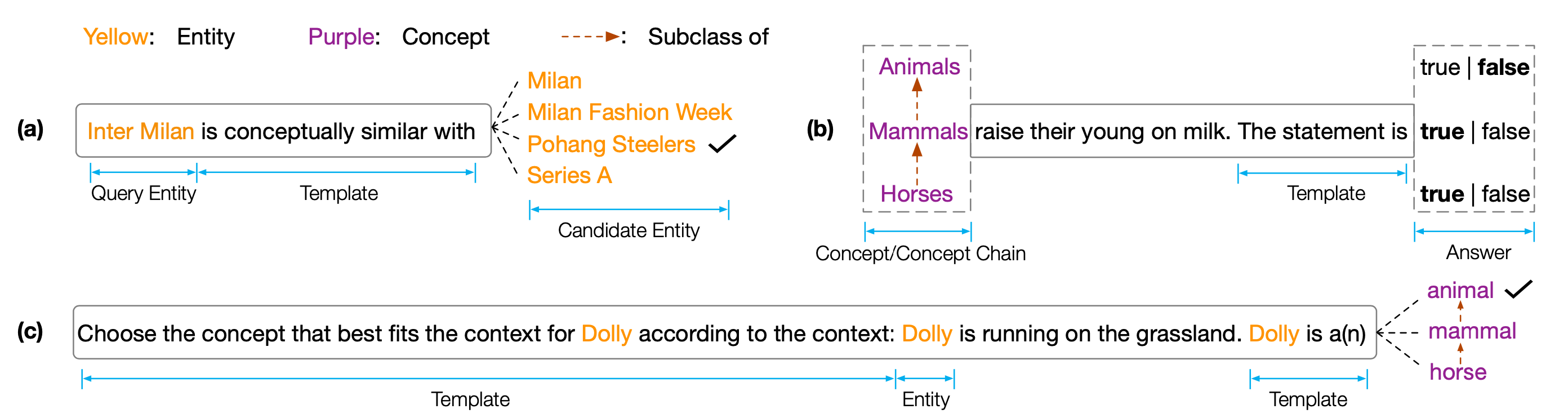

Dataset dan Kode untuk EMNLP 2022 Paper '' Copen: Probing Conceptual Lewnelle dalam Model Bahasa Pra-Terlatih ''. Copen adalah tolok ukur porobing pengetahuan konseptual yang bertujuan untuk menganalisis kemampuan pemahaman konseptual model bahasa pra-terlatih (PLM). Secara khusus, Copen terdiri dari tiga tugas:

Eksperimen ekstensif pada berbagai ukuran dan jenis PLM menunjukkan bahwa PLM yang ada secara sistematis tidak memiliki pengetahuan konseptual dan menderita berbagai korelasi palsu. Kami percaya ini adalah hambatan kritis untuk mewujudkan kognisi seperti manusia di PLM. Tujuan atau arsitektur yang lebih sadar konsep diperlukan untuk mengembangkan PLM yang berpengetahuan konseptual.

Untuk mendapatkan hasil tes, Anda perlu mengirimkan hasil Anda ke Codalab.

Repositori kode didasarkan pada Pytorch dan Transformers . Harap gunakan perintah berikut untuk menginstal semua dependen yang diperlukan. pip install -r requirements.txt

Benchmark Copen ditempatkan di Tsinghua Cloud, silakan gunakan perintah berikut untuk mengunduh set data dan menempatkannya di jalur propor.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42Jika kode atau benchmark kami membantu Anda, silakan kutip kami:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}