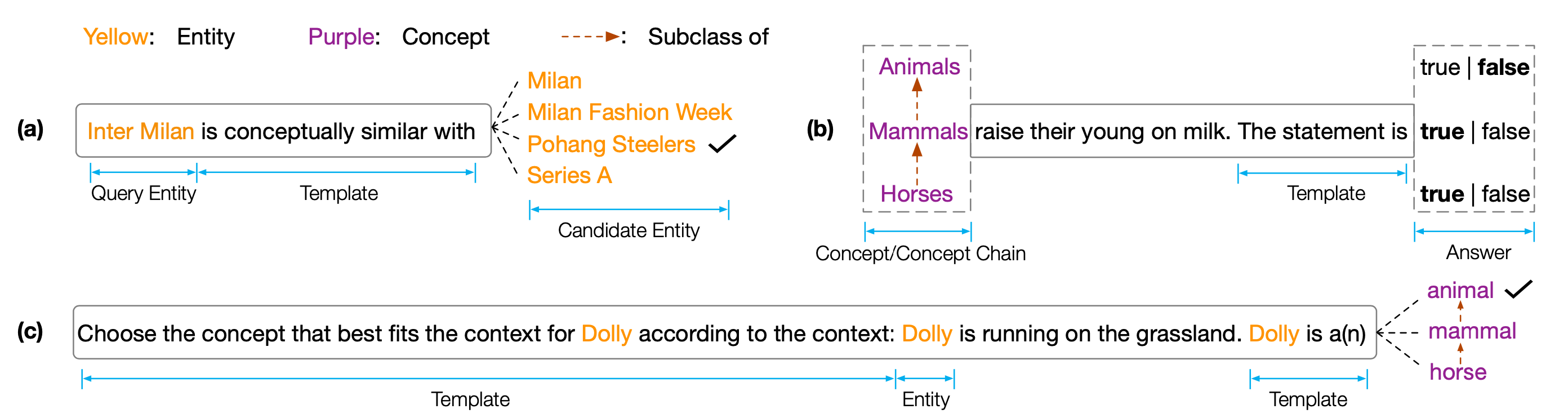

مجموعة البيانات والرمز لورقة EMNLP 2022 "Copen": التحقيق في المعرفة المفاهيمية في نماذج اللغة المسبقة ". Copen هو معيار المعرفة المفاهيمية المعيار الذي يهدف إلى تحليل قدرات الفهم المفاهيمي لنماذج اللغة التي تم تدريبها مسبقًا (PLMS). على وجه التحديد ، يتكون كوبن من ثلاث مهام:

تُظهر تجارب مكثفة على أحجام وأنواع مختلفة من PLMs أن PLMs الحالية تفتقر بشكل منهجي إلى المعرفة المفاهيمية وتعاني من ارتباطات زائفة مختلفة. نعتقد أن هذا عنق الزجاجة الحرجة لتحقيق الإدراك الذي يشبه الإنسان في PLMs. هناك حاجة إلى مزيد من الأهداف أو البنى المدرجة في المفاهيم لتطوير PLMs المفاهيمية المعروفة.

للحصول على نتائج الاختبار ، تحتاج إلى إرسال نتائجك إلى Codalab.

يعتمد مستودع الكود على Pytorch و Transformers . يرجى استخدام الأمر التالي لتثبيت جميع التبعية اللازمة. pip install -r requirements.txt

يتم وضع معيار Copen على Tsinghua Cloud ، يرجى استخدام الأمر التالي لتنزيل مجموعات البيانات ووضعها في مسار propor.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42إذا كانت رموزنا أو القياس الخاص بنا تساعدك ، فيرجى الاستشهاد بنا:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}