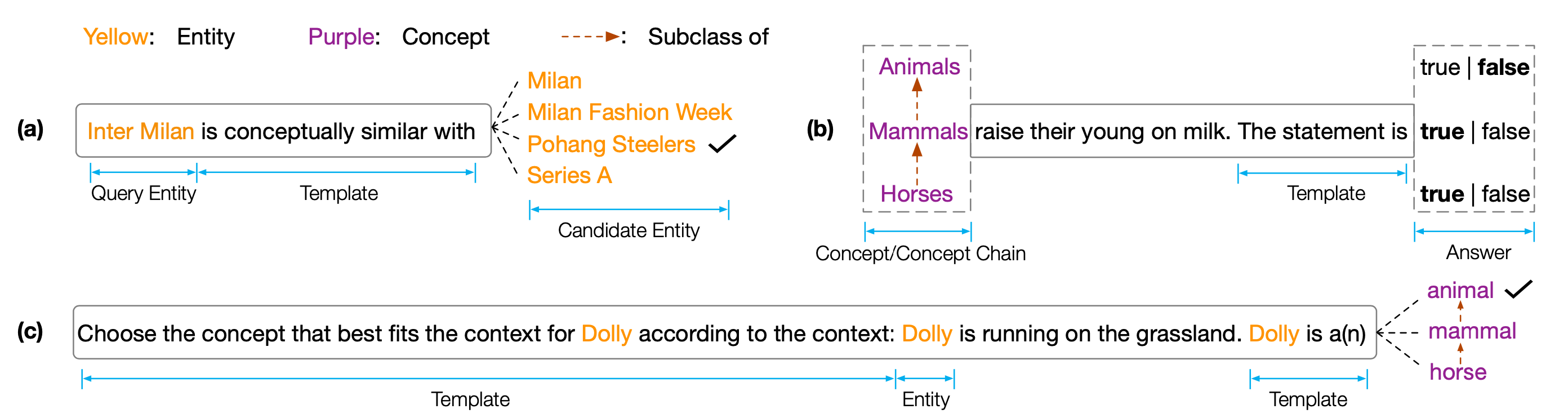

Ensemble de données et code pour le papier EMNLP 2022 '' COPEN: sonder les connaissances conceptuelles dans les modèles de langue pré-formés ''. Copen est une référence en porobing de connaissance conceptuelle qui vise à analyser les capacités de compréhension conceptuelle des modèles de langage pré-formés (PLMS). Plus précisément, Copen se compose de trois tâches:

Des expériences approfondies sur différentes tailles et types de PLMS montrent que les PLM existants manquent systématiquement des connaissances conceptuelles et souffrent de diverses corrélations parasites. Nous pensons qu'il s'agit d'un goulot d'étranglement critique pour réaliser la cognition humaine dans les PLM. Des objectifs ou des architectures plus conscients du concept sont nécessaires pour développer des PLM conceptuels bien informés.

Pour obtenir les résultats des tests, vous devez soumettre vos résultats à Codalab.

Le référentiel de code est basé sur Pytorch et Transformers . Veuillez utiliser la commande suivante pour installer toutes les dépendances nécessaires. pip install -r requirements.txt

La référence Copen est placée sur Tsinghua Cloud, veuillez utiliser la commande suivante pour télécharger les ensembles de données et les placer dans le chemin de la propor.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42Si nos codes ou nos référence vous aident, veuillez nous citer:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}