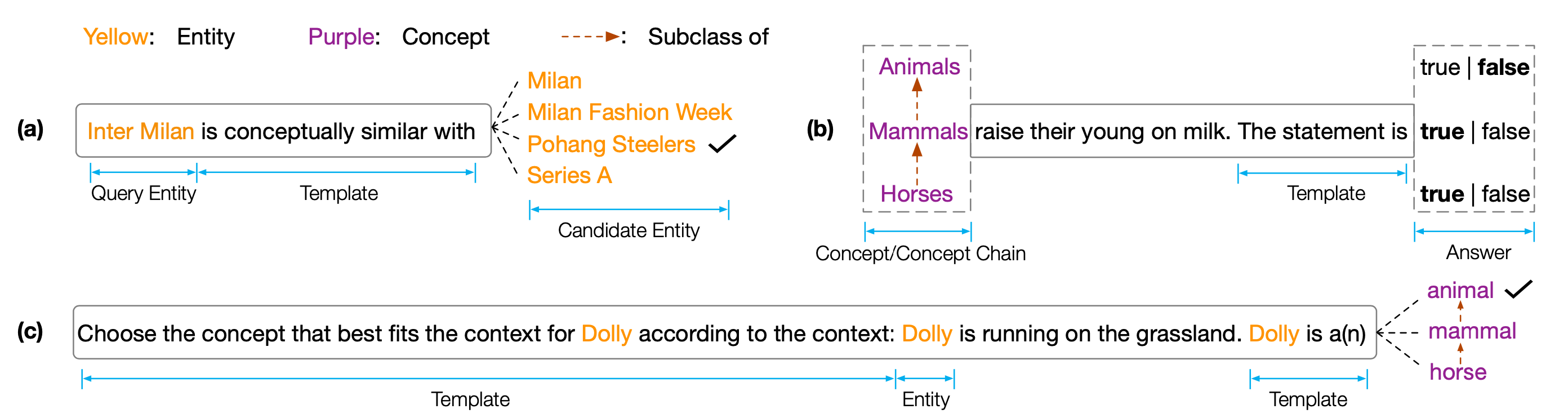

Conjunto de datos y código para el documento EMNLP 2022 '' Copen: sondeo de conocimiento conceptual en modelos de idiomas previamente capacitados ''. Copen es un punto de referencia de porobing conceptual de conocimiento que tiene como objetivo analizar las capacidades de comprensión conceptual de los modelos de lenguaje previamente capacitados (PLMS). Específicamente, Copen consta de tres tareas:

Experimentos extensos en diferentes tamaños y tipos de PLM muestran que los PLM existentes carecen sistemáticamente de conocimiento conceptual y sufren de varias correlaciones espurias. Creemos que este es un cuello de botella crítico para realizar una cognición humana en PLMS. Se necesitan más objetivos o arquitecturas conscientes del concepto para desarrollar PLM conceptuales conocedores.

Para obtener los resultados de la prueba, debe enviar sus resultados a Codalab.

El repositorio de código se basa en Pytorch y Transformers . Utilice el siguiente comando para instalar todos los dependientes necesarios. pip install -r requirements.txt

El punto de referencia de Copen se coloca en Tsinghua Cloud, utilice el siguiente comando para descargar los conjuntos de datos y colocarlos en la ruta del propor.

cd data/

wget --content-disposition https://cloud.tsinghua.edu.cn/f/f0b33fb429fa4575aa7f/ ? dl=1

unzip copen_data.zip

mkdir task1/data

mkdir task2/data

mkdir task3/data

mv copen_data/task1/ * task1/data

mv copen_data/task2/ * task2/data

mv copen_data/task3/ * task3/data cd task1

python probing_data_processor.py

cd ../

cd task2

python probing_data_processor.py

cd ../

cd task3

python probing_data_processor.py

cd ../python processor_utils.py task1 mc

python processor_utils.py task2 sc

python processor_utils.py task3 mc cd code/probing

bash task1/run.sh 0 bert bert-base-uncased

bash task2/run.sh 0 bert bert-base-uncased

bash task3/run.sh 0 bert bert-base-uncased cd code/finetuning

cd task1/

bash ../run.sh 0 bert bert-base-uncased task1 mc 42

cd task2/

bash ../run.sh 0 bert bert-base-uncased task2 sc 42

cd task3/

bash ../run.sh 0 bert bert-base-uncased task3 mc 42Si nuestros códigos o un punto de referencia lo ayudan, cíquanos:

@inproceedings{peng2022copen,

title={COPEN: Probing Conceptual Knowledge in Pre-trained Language Models},

author={Peng, Hao and Wang, Xiaozhi and Hu, Shengding and Jin, Hailong and Hou, Lei and Li, Juanzi and Liu, Zhiyuan and Liu, Qun},

booktitle={Proceedings of EMNLP},

year={2022}

}