ttts

1.0.0

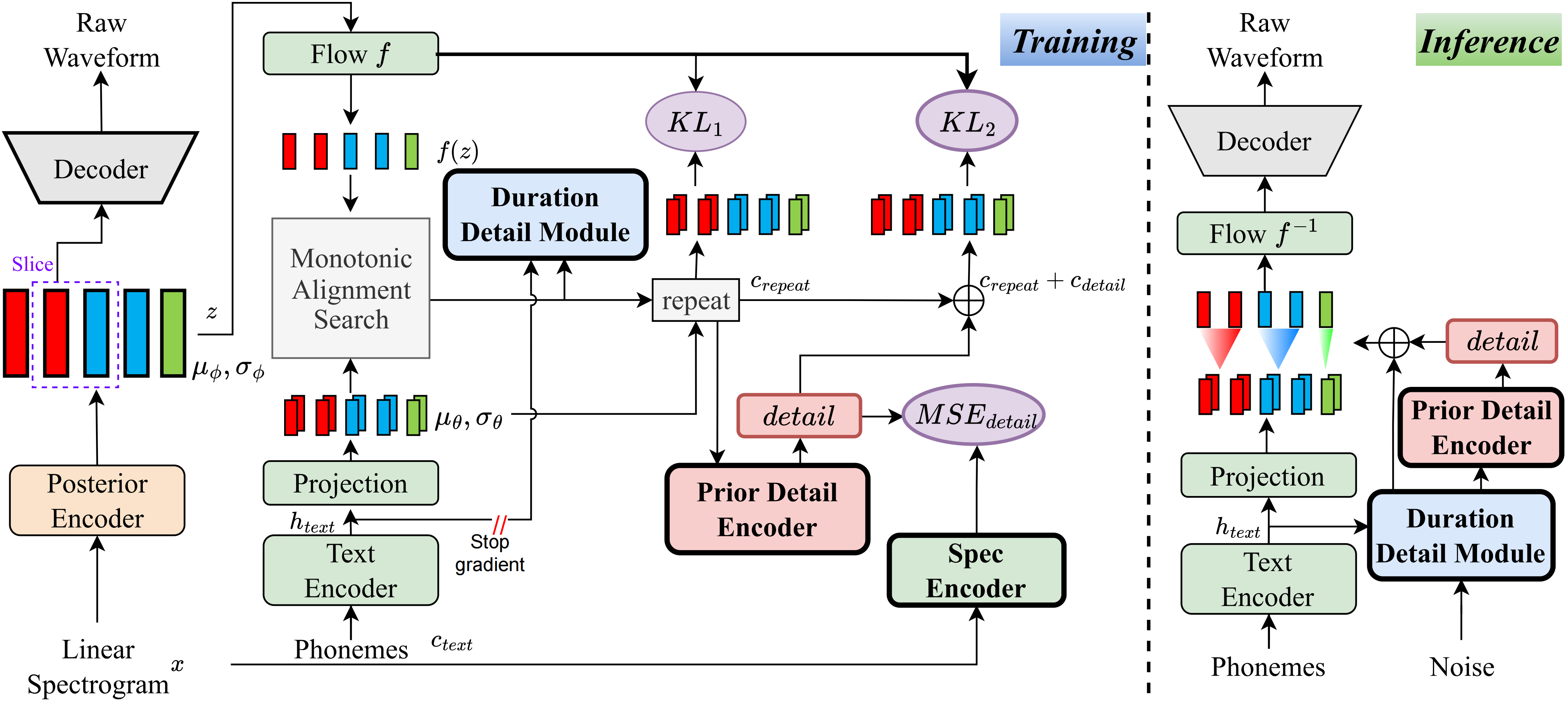

据我所知,该项目的方法是我提出的第一个此类方法。主要思想源于“细节”的建模,因为我对基于VQ(向量量化)方法无法很好地重建音频的事实感到困扰,并且也没有办法对此残差进行建模。但是,对于传统的VIT,有一些方法可以创建一些监督信号,例如线性光谱,或者使用可学习的嵌入来学习持续时间。这些观察结果最终导致了这种方法取得了非常好的结果。

访问演示页面

访问预训练的模型

pip install -e .

使用ttts/prepare/bpe_all_text_to_one_file.py合并您收集的所有文本。要训练令牌器,请检查ttts/gpt/voice_tokenizer以获取更多信息。

使用1_vad_asr_save_to_jsonl.py和2_romanize_text.py进行预处理数据集。使用以下指令训练模型。

accelerate launch ttts/vqvae/train_v3.py

现在支持中文,英语,日语,韩语。

您可以使用两个步骤使用此模型的任何语言。

ttts/gpt/voice_tokenizer获取字典。对于英语,您可以直接使用文本。但是,对于中文,您需要使用拼音,对于日语,您需要使用romaji,并确保在文本中包含发音信息。

请检查api.py以获取推理细节。

使用预估计的模型更改Train_v3.py中的负载路径,然后训练它。关于数据集,您应该预处理文本和音频路径和拉丁语。您可以参考ttts/prepare/2_romanize_text.py获取一些信息。