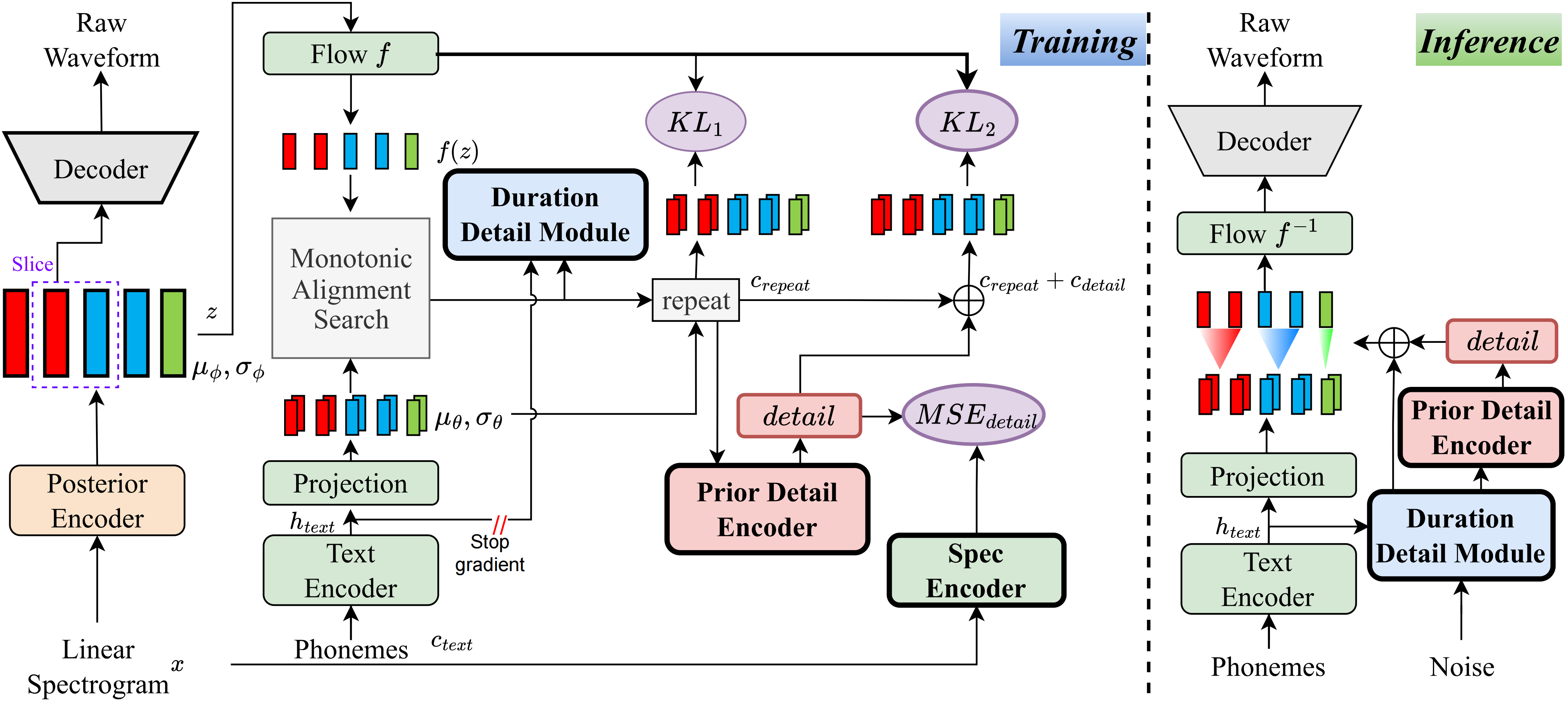

على حد علمي ، فإن الطريقة في هذا المشروع هي الأولى من نوعها التي اقترحتها. تنبع الفكرة الرئيسية من نمذجة "التفاصيل" ، حيث شعرت بالقلق من أن الأساليب القائمة على أن VQ (كمية المتجه) لا يمكن أن تعيد بناء الصوت بشكل جيد للغاية ، ولا توجد أيضًا طريقة لتصميم هذا المتبقي. ومع ذلك ، بالنسبة إلى الحالات التقليدية ، هناك طرق لإنشاء بعض الإشارات الإشرافية ، مثل الأطياف الخطية ، أو باستخدام التضمينات القابلة للتعلم لتعلم المدة. أدت هذه الملاحظات في النهاية إلى تحقيق هذه الطريقة نتائج جيدة للغاية.

قم بزيارة الصفحة التجريبية

قم بزيارة النماذج التي تم تدريبها مسبقًا

pip install -e .

استخدم ttts/prepare/bpe_all_text_to_one_file.py لدمج كل النص الذي جمعته. لتدريب الرمز المميز ، تحقق من ttts/gpt/voice_tokenizer لمزيد من المعلومات.

استخدم 1_vad_asr_save_to_jsonl.py و 2_romanize_text.py إلى مجموعة بيانات المعالجة المسبقة. استخدم التعليمات التالية لتدريب النموذج.

accelerate launch ttts/vqvae/train_v3.py

الآن دعم الصينية والإنجليزية واليابانية والكورية.

يمكنك استخدام أي لغة مع هذا النموذج بخطوتين.

ttts/gpt/voice_tokenizer للحصول على قاموس.للغة الإنجليزية ، يمكنك استخدام النص مباشرة. ومع ذلك ، بالنسبة للصينية ، تحتاج إلى استخدام Pinyin ، وبالنسبة اليابانية ، تحتاج إلى استخدام Romaji ، مع التأكد من تضمين معلومات النطق في النص.

يرجى التحقق من api.py للحصول على تفاصيل الاستدلال.

قم بتغيير مسار الحمل في Train_v3.py مع نموذج pretrained ، ثم تدريبه. حول مجموعة البيانات ، يجب أن تعالج النص ومسار الصوت واللاتينية. يمكنك الرجوع إلى ttts/prepare/2_romanize_text.py للحصول على بعض المعلومات.