如果您有疑问或想帮助您可以在Laion Discord服务器上的#音频生成频道中找到我们。

通过反转耳语构建的开源文本到语音系统。以前称为Spear-Tts-Pytorch 。

我们希望该模型像稳定的扩散一样,但对于语音来说 - 既强大又易于自定义。

我们仅使用适当许可的语音记录,所有代码都是开源的,因此该模型始终可以安全用于商业应用程序。

目前,这些模型已在英语liblelight数据集上进行培训。在下一个版本中,我们想针对多种语言(Whisper和codec都是多语言)。

综合语音样本:

我们在EN+PL+FR数据集上成功培训了一个tiny S2A模型,它可以用法语进行语音克隆:

我们能够使用仅接受英语和波兰语训练的冷冻语义令牌来做到这一点。这支持了我们能够培训单个语义令牌模型以支持世界上所有语言的想法。即使是当前不受耳语模型支持的人也很可能。请继续关注此方面的更多更新。 :)

我们将上周花费了优化推理性能。我们集成了torch.compile ,添加了kV摄取并调整了一些层 - 现在,我们在消费者4090上的工作速度比实时快12倍!

我们可以用一句话混合语言(在这里突出显示的英语项目名称无缝地混合到波兰语音中):

开玩笑,Pierwszy测试Wielojęzycznego

Whisper Speech模型Zamieniającegotekst naMowę,CollaboraiLaionnauczyli nauczyli na superkomputerzeJewels。

我们还添加了一种简单的方法来测试语音粘结。这是温斯顿·丘吉尔(Winston Churchill)著名演讲的样本声音(无线电静态是一个功能,而不是错误;) - 它是参考录音的一部分):

您可以在COLAB上测试所有这些(我们优化了依赖项,因此现在不到30秒才能安装)。拥抱面空间即将到来。

我们推出了一种新的SD S2A模型,该模型在仍在产生高质量演讲的同时更快。我们还根据参考音频文件添加了语音克隆的示例。

与往常一样,您可以查看我们的colab自己尝试一下!

另一个三人模型,这次它们支持多种语言(英语和波兰语)。这是偷看的两个新样本。您可以查看我们的Colab自己尝试一下!

英语演讲,女性声音(从波兰语言数据集转移):

波兰样本,男性声音:

较旧的进度更新在这里存档

我们鼓励您从上面的Google Colab链接开始,或在本地运行提供的笔记本。如果您想手动下载或从头开始训练模型,则在HuggingFace上都可以使用Whisperspeech预训练的模型以及转换后的数据集。

通用架构类似于Audiolm,Google的Spear TT和Meta的Musicgen。我们避免了NIH综合征,并在功能强大的开源模型的顶部建立了它:从Openai窃窃私语,生成语义令牌并执行转录,从Meta for Meta进行声学建模和containtr Inc的VOCOS作为高质量的Vocoder。

我们给了两个演讲,深入研究了窃窃私语。第一个谈论大规模培训的挑战:

从缩放低语模型到80k+小时的语音 - jakubcłapa录制的技巧

另一个是我们做出的建筑选择的更多信息:

开源文本到语音项目:窃窃私语 - 深度讨论

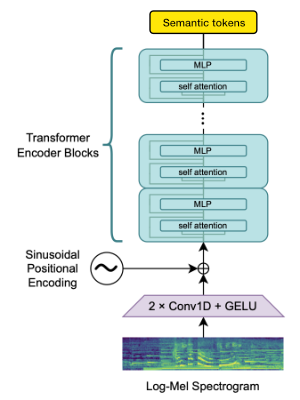

我们利用OpenAi Whisper编码器块来生成嵌入,然后进行量化以获取语义令牌。

如果语言已经受到窃窃私语的支持,那么此过程仅需要音频文件(没有地面真相转录)。

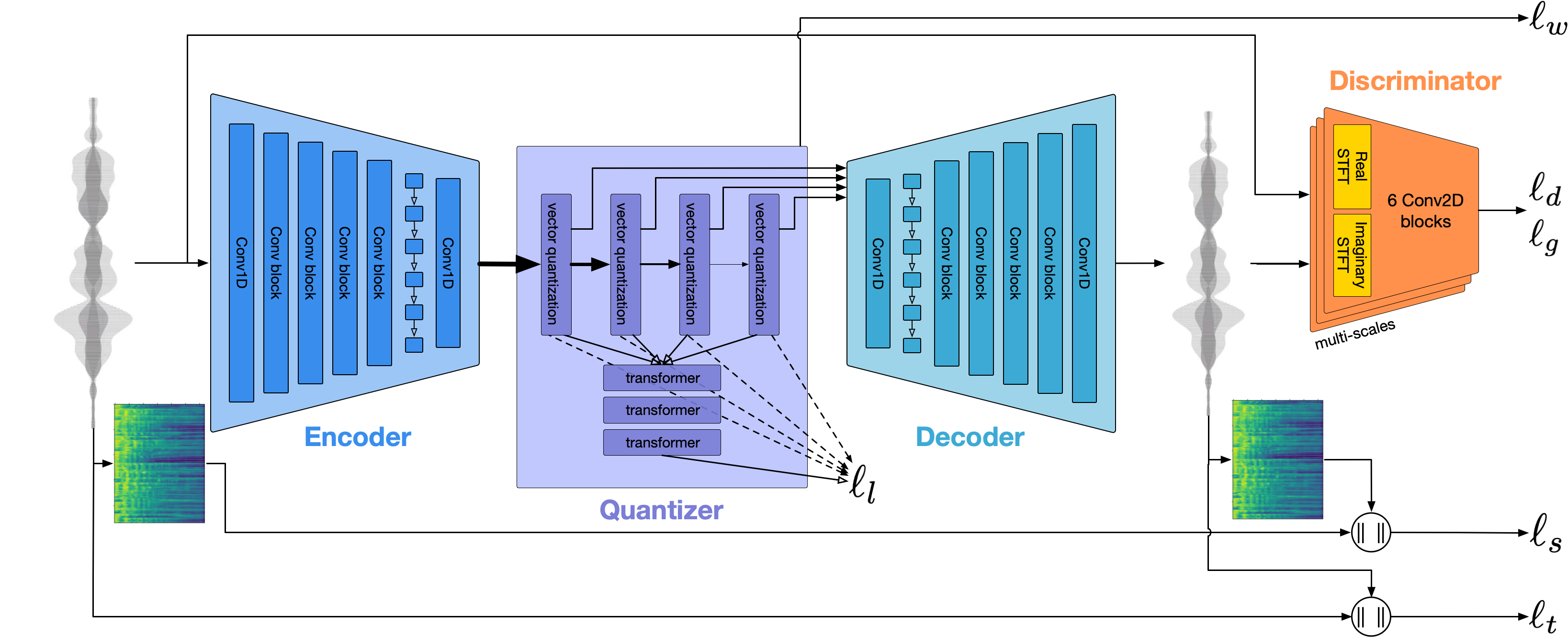

我们使用Encodec对音频波形进行建模。开箱即用,它以1.5kbps的形式提供合理的质量,我们可以使用VOCOS(在Eccodec代币上仔细预测的Vocos)将其提高到高质量。

没有慷慨的赞助,这项工作将是不可能的:

我们非常感谢高斯超级计算中心(www.gauss-centre.eu)通过在GCS超级计算中心(JSC)的GCS超级计算机Booster上通过John von Neumann计算研究所(NIC)提供计算时间来资助这项工作的一部分,并提供了访问的访问。

我们还要感谢个人贡献者在建立此模型方面的巨大帮助:

qwerty_qwer 我们可以为您提供开源和专有AI项目的帮助。您可以通过Collabora网站或Discord(和)与我们联系

我们依靠许多惊人的开源项目和研究论文:

@article { SpearTTS ,

title = { Speak, Read and Prompt: High-Fidelity Text-to-Speech with Minimal Supervision } ,

url = { https://arxiv.org/abs/2302.03540 } ,

author = { Kharitonov, Eugene and Vincent, Damien and Borsos, Zalán and Marinier, Raphaël and Girgin, Sertan and Pietquin, Olivier and Sharifi, Matt and Tagliasacchi, Marco and Zeghidour, Neil } ,

publisher = { arXiv } ,

year = { 2023 } ,

} @article { MusicGen ,

title = { Simple and Controllable Music Generation } ,

url = { https://arxiv.org/abs/2306.05284 } ,

author = { Jade Copet and Felix Kreuk and Itai Gat and Tal Remez and David Kant and Gabriel Synnaeve and Yossi Adi and Alexandre Défossez } ,

publisher = { arXiv } ,

year = { 2023 } ,

} @article { Whisper

title = { Robust Speech Recognition via Large-Scale Weak Supervision } ,

url = { https://arxiv.org/abs/2212.04356 } ,

author = { Radford, Alec and Kim, Jong Wook and Xu, Tao and Brockman, Greg and McLeavey, Christine and Sutskever, Ilya } ,

publisher = { arXiv } ,

year = { 2022 } ,

} @article { EnCodec

title = { High Fidelity Neural Audio Compression } ,

url = { https://arxiv.org/abs/2210.13438 } ,

author = { Défossez, Alexandre and Copet, Jade and Synnaeve, Gabriel and Adi, Yossi } ,

publisher = { arXiv } ,

year = { 2022 } ,

} @article { Vocos

title = { Vocos: Closing the gap between time-domain and Fourier-based neural vocoders for high-quality audio synthesis } ,

url = { https://arxiv.org/abs/2306.00814 } ,

author = { Hubert Siuzdak } ,

publisher = { arXiv } ,

year = { 2023 } ,

}