รวมการเป็นตัวแทนระดับโมเลกุลและข้อความผ่านการสร้างแบบจำลองภาษาหลายงาน

Dimitrios Christofidellis*, Giorgio Giannone*, Jannis เกิด, Ole Winther, Teodoro Laino, Matteo Manica

การประชุมนานาชาติเกี่ยวกับการเรียนรู้ของเครื่องจักร (ICML), 2023

[Paper] [แอป Gradio] [รหัส]

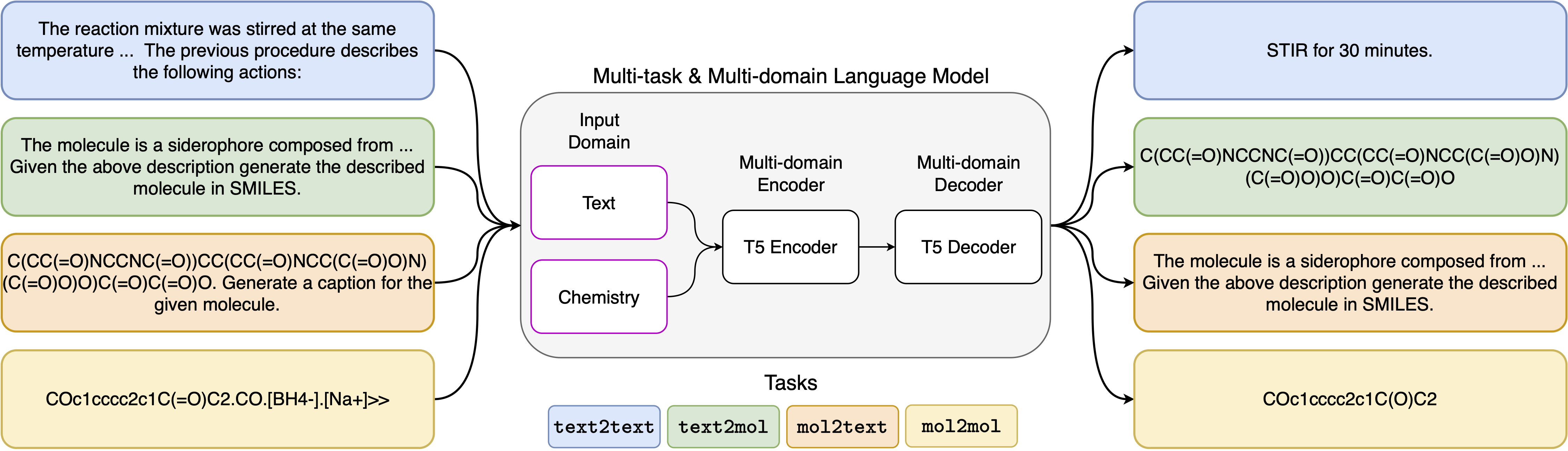

ความก้าวหน้าล่าสุดในแบบจำลองภาษาประสาทได้ถูกนำไปใช้กับสาขาเคมีที่ประสบความสำเร็จโดยเสนอวิธีแก้ปัญหาแบบดั้งเดิมสำหรับปัญหาคลาสสิกในการออกแบบโมเลกุลและการวางแผนการสังเคราะห์ วิธีการใหม่เหล่านี้มีศักยภาพที่จะเติมเชื้อเพลิงในยุคใหม่ของระบบอัตโนมัติที่ขับเคลื่อนด้วยข้อมูลในการค้นพบทางวิทยาศาสตร์ อย่างไรก็ตามโดยทั่วไปแล้วโมเดลพิเศษจะยังคงจำเป็นสำหรับแต่ละงานซึ่งนำไปสู่ความจำเป็นในการปรับจูนปัญหาเฉพาะและการละเลยความสัมพันธ์ของงาน อุปสรรคสำคัญในสาขานี้คือการขาดการเป็นตัวแทนแบบครบวงจรระหว่างภาษาธรรมชาติและการเป็นตัวแทนทางเคมีทำให้เกิดความซับซ้อนและ จำกัด การมีปฏิสัมพันธ์กับเครื่องจักรของมนุษย์ ที่นี่เราเสนอรูปแบบภาษาหลายโดเมนแบบหลายโมเดลที่สามารถแก้ปัญหางานที่หลากหลายทั้งในโดเมนเคมีและภาษาธรรมชาติ แบบจำลองของเราสามารถจัดการกับสารเคมีและภาษาธรรมชาติพร้อมกันโดยไม่ต้องใช้การฝึกอบรมล่วงหน้าราคาแพงในโดเมนเดียวหรือโมเดลเฉพาะงาน ที่น่าสนใจคือการแบ่งปันน้ำหนักทั่วทั้งโดเมนช่วยปรับปรุงแบบจำลองของเราอย่างน่าทึ่งเมื่อเปรียบเทียบกับฐานทัพที่ล้ำสมัยในงานเดี่ยวและงานข้ามโดเมน โดยเฉพาะอย่างยิ่งการแบ่งปันข้อมูลข้ามโดเมนและงานก่อให้เกิดการปรับปรุงขนาดใหญ่ในงานข้ามโดเมนขนาดที่เพิ่มขึ้นตามขนาดซึ่งวัดได้มากกว่าหนึ่งโหลของตัวชี้วัดที่เกี่ยวข้อง งานของเราชี้ให้เห็นว่าแบบจำลองดังกล่าวสามารถเร่งการค้นพบอย่างมีประสิทธิภาพและมีประสิทธิภาพในด้านวิทยาศาสตร์กายภาพโดยการปรับแต่งการปรับแต่งเฉพาะปัญหาและการเพิ่มปฏิสัมพันธ์ของมนุษย์

การติดตั้งข้อกำหนด:

pip install -r requirements.txtสร้างเคอร์เนลเฉพาะ:

python -m ipykernel install --name text_chem_t5_demoดีไป

กระบวนการฝึกอบรมดำเนินการโดยใช้เทรนเนอร์การสร้างแบบจำลองภาษาโดยใช้ Transformers Hugging Face (Wolf et al., 2020) และ Pytorch Lightning (Falcon และทีม Pytorch Lightning, 2019) จากห้องสมุด GT4SD (Manica et al., 2022) ในการทำซ้ำการฝึกอบรมคุณต้องติดตั้งไลบรารี GT4SD ก่อน สำหรับข้อมูลเพิ่มเติมเกี่ยวกับกระบวนการติดตั้งของไลบรารี GT4SD คุณสามารถเยี่ยมชมหน้าได้ เมื่อติดตั้ง GT4SD คุณสามารถใช้คำสั่งต่อไปนี้เพื่อเปิดการฝึกอบรมของเรา โปรดทราบว่าชุดข้อมูลที่ให้ไว้ในไดเรกทอรี dataset-sample มีเพียงชุดย่อยขนาดเล็กของชุดข้อมูลจริงของเรา เพื่อสร้างชุดข้อมูลการฝึกอบรมเต็มรูปแบบของเราเราอ้างอิงผู้อ่านที่สนใจไปยังส่วนที่เกี่ยวข้องของบทความของเราและการอ้างอิงที่มีให้ที่นั่น

gt4sd-trainer --training_pipeline_name language-modeling-trainer

--model_name_or_path t5-base

--lr 6e-4

--lr_decay 0.99

--batch_size 8

--train_file dataset-sample/train.jsonl

--validation_file dataset-sample/valid.jsonl

--default_root_dir text_chem_t5_base

--type cgm

--val_check_interval 20000

--max_epochs 1

--limit_val_batches 500

--accumulate_grad_batches 4

--log_every_n_steps 5000

--monitor val_loss

--save_top_k 1

--mode min

--every_n_train_steps 20000

--accelerator 'ddp'

เทมเพลตพรอมต์ที่เราใช้สำหรับงาน 5 งานที่แตกต่างกันสามารถพบได้ในตารางต่อไปนี้โดยที่ <put> แสดงถึงอินพุตจริงสำหรับแต่ละงาน

| งาน | เทมเพลต |

|---|---|

| การทำนายล่วงหน้า | ทำนายผลิตภัณฑ์ของปฏิกิริยาต่อไปนี้: <put> |

| การสังเคราะห์ | ทำนายปฏิกิริยาที่สร้างผลิตภัณฑ์ต่อไปนี้: <put> |

| ย่อหน้าต่อการกระทำ | การกระทำใดที่อธิบายไว้ในย่อหน้าต่อไปนี้: <put> |

| คำอธิบายถึงรอยยิ้ม | เขียนด้วยรอยยิ้มโมเลกุลที่อธิบายไว้: <put> |

| รอยยิ้ม | คำบรรยายภาพรอยยิ้มต่อไปนี้: <put> |

รุ่นสี่รุ่นของเรามีให้บริการผ่าน Huggignface Hub ในลิงค์ต่อไปนี้:

ในสมุดบันทึกที่ให้มา (demo.ipynb) เรานำเสนอตัวอย่างของวิธีการใช้โมเดลสำหรับ 5 งานที่แตกต่างกัน

@inproceedings { christofidellis2023unifying ,

title = { Unifying Molecular and Textual Representations via Multi-task Language Modelling } ,

author = { Christofidellis, Dimitrios and Giannone, Giorgio and Born, Jannis and Winther, Ole and Laino, Teodoro and Manica, Matteo } ,

booktitle = { Proceedings of the 40th International Conference on Machine Learning } ,

pages = { 6140--6157 } ,

year = { 2023 } ,

volume = { 202 } ,

series = { Proceedings of Machine Learning Research } ,

publisher = { PMLR } ,

pdf = { https://proceedings.mlr.press/v202/christofidellis23a/christofidellis23a.pdf } ,

url = { https://proceedings.mlr.press/v202/christofidellis23a.html } ,

}