توحيد التمثيل الجزيئي والنصوص عبر نمذجة اللغة متعددة المهام

Dimitrios Christofidellis*، Giorgio Giannone*، Jannis Born ، Ole Winther ، Teodoro Laino ، Matteo Manica

المؤتمر الدولي للتعلم الآلي (ICML) ، 2023

[ورقة] [تطبيق Gradio] [رمز]

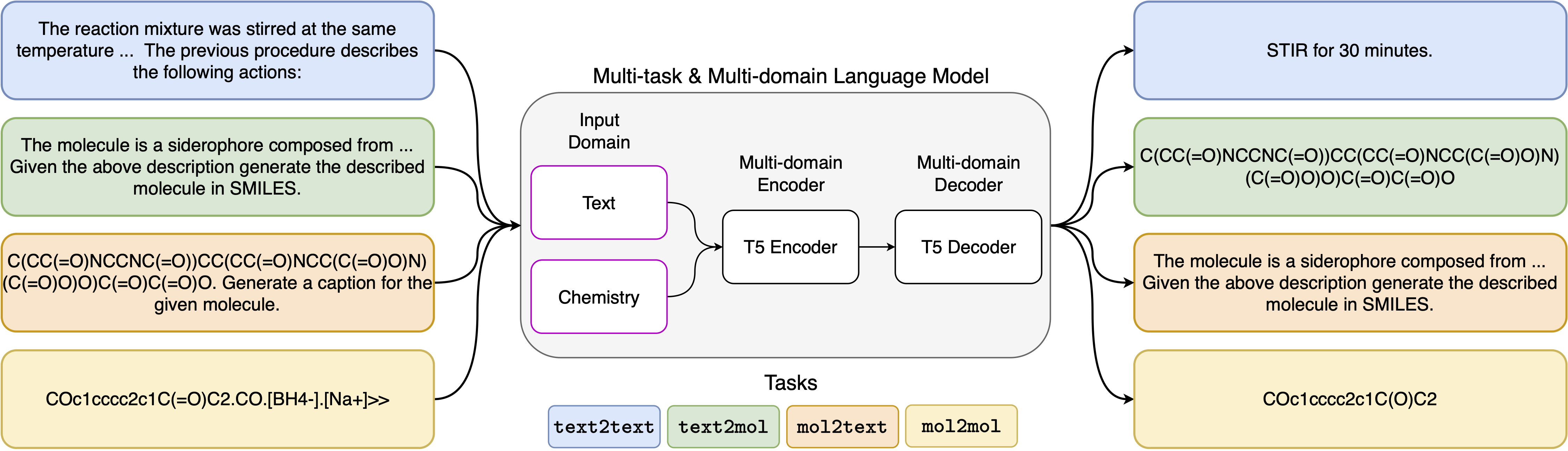

كما تم تطبيق التطورات الحديثة في نماذج اللغة العصبية بنجاح على مجال الكيمياء ، مما يوفر حلولًا توليدية للمشاكل الكلاسيكية في التصميم الجزيئي وتخطيط التوليف. هذه الطرق الجديدة لديها القدرة على تأجيج حقبة جديدة من الأتمتة القائمة على البيانات في الاكتشاف العلمي. ومع ذلك ، لا تزال النماذج المتخصصة مطلوبة عادةً لكل مهمة ، مما يؤدي إلى الحاجة إلى صناديق التثبيت الخاصة بالمشكلة وإهمال المهام. العقبة الرئيسية في هذا المجال هي عدم وجود تمثيل موحد بين اللغة الطبيعية والتمثيل الكيميائي ، مما يعقد ويقتصر تفاعل الإنسان والآلة. هنا ، نقترح أول نموذج لغة متعددة المجالات والمهام يمكن أن يحل مجموعة واسعة من المهام في كل من مجالات اللغة الكيميائية والطبيعية. يمكن لنموذجنا التعامل مع اللغة الكيميائية والطبيعية بشكل متزامن ، دون الحاجة إلى التدريب المسبق باهظة الثمن على المجالات المفردة أو النماذج الخاصة بالمهمة. ومن المثير للاهتمام ، أن تبادل الأوزان عبر المجالات يحسن بشكل ملحوظ نموذجنا عند قيامه بتقييم خطوط الأساس الحديثة على مهام مجلد واحد ومجال. على وجه الخصوص ، يؤدي مشاركة المعلومات عبر المجالات والمهام إلى تحسينات كبيرة في مهام النطاق عبر المجال ، والتي يزداد حجمها بمقياس ، كما تم قياسه بأكثر من عشرة من المقاييس ذات الصلة. يشير عملنا إلى أن مثل هذه النماذج يمكن أن تسرع باكتشاف بشكل قوي وكفاءة في العلوم الفيزيائية من خلال تحل محل التفاعلات الدقيقة الخاصة بالمشكلة وتعزيز النموذج البشري .

متطلبات التثبيت:

pip install -r requirements.txtإنشاء نواة مخصصة:

python -m ipykernel install --name text_chem_t5_demoمن الجيد الذهاب

يتم تنفيذ عملية التدريب باستخدام مدرب نمذجة اللغة استنادًا إلى محولات الوجه المعانقة (Wolf et al. ، 2020) و Pytorch Lightning (Falcon و Pytorch Lightning Team ، 2019) من مكتبة GT4SD (Manica et al. ، 2022). لإعادة إنتاج التدريب ، تحتاج أولاً إلى تثبيت مكتبة GT4SD. لمزيد من المعلومات حول عملية تثبيت مكتبة GT4SD ، يمكنك زيارة صفحتها. بمجرد تثبيت GT4SD ، يمكنك استخدام الأمر التالي لإطلاق تدريبنا. لاحظ أن انقسامات مجموعة البيانات المقدمة في دليل dataset-sample تحتوي على مجموعة فرعية صغيرة فقط من انقسامات مجموعة البيانات الفعلية الخاصة بنا. لتجديد مجموعة بيانات التدريب الكاملة الخاصة بنا ، نشير إلى القارئ المهتمين إلى القسم المعني من ورقتنا والمراجع المقدمة هناك.

gt4sd-trainer --training_pipeline_name language-modeling-trainer

--model_name_or_path t5-base

--lr 6e-4

--lr_decay 0.99

--batch_size 8

--train_file dataset-sample/train.jsonl

--validation_file dataset-sample/valid.jsonl

--default_root_dir text_chem_t5_base

--type cgm

--val_check_interval 20000

--max_epochs 1

--limit_val_batches 500

--accumulate_grad_batches 4

--log_every_n_steps 5000

--monitor val_loss

--save_top_k 1

--mode min

--every_n_train_steps 20000

--accelerator 'ddp'

يمكن العثور على قوالب موجات التي استخدمناها في المهام الخمسة المختلفة في الجدول التالي ، حيث يمثل <Put> الإدخال الفعلي لكل مهمة.

| مهمة | نموذج |

|---|---|

| التنبؤ إلى الأمام | توقع منتج التفاعل التالي: <الإدخال> |

| إعادة التخليق | توقع رد الفعل الذي ينتج المنتج التالي: <prope> |

| فقرة إلى أفعال | ما هي الإجراءات الموصوفة في الفقرة التالية: <prope> |

| الوصف إلى الضيق | اكتب في الابتسامات الجزيء الموصوف: <input> |

| الابتسامات إلى الاستفادة | التسمية التوضيحية الابتسامات التالية: <prope> |

تتوفر المتغيرات الأربعة لنموذجنا عبر HUGGIGNFAFCE HUB في الروابط التالية:

في دفتر الملاحظات المقدم (Demo.ipynb) ، نقدم أمثلة على كيفية استخدام النموذج للمهام الخمسة المختلفة.

@inproceedings { christofidellis2023unifying ,

title = { Unifying Molecular and Textual Representations via Multi-task Language Modelling } ,

author = { Christofidellis, Dimitrios and Giannone, Giorgio and Born, Jannis and Winther, Ole and Laino, Teodoro and Manica, Matteo } ,

booktitle = { Proceedings of the 40th International Conference on Machine Learning } ,

pages = { 6140--6157 } ,

year = { 2023 } ,

volume = { 202 } ,

series = { Proceedings of Machine Learning Research } ,

publisher = { PMLR } ,

pdf = { https://proceedings.mlr.press/v202/christofidellis23a/christofidellis23a.pdf } ,

url = { https://proceedings.mlr.press/v202/christofidellis23a.html } ,

}