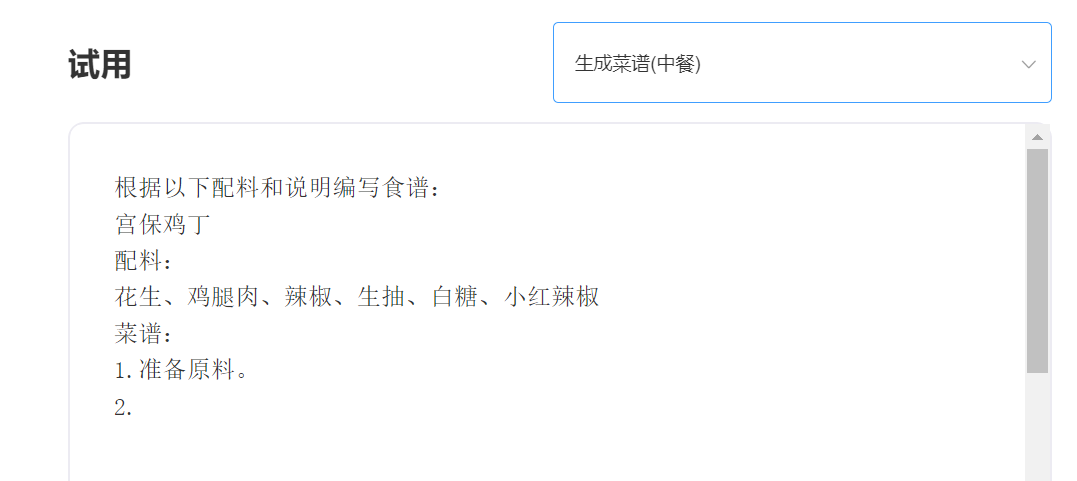

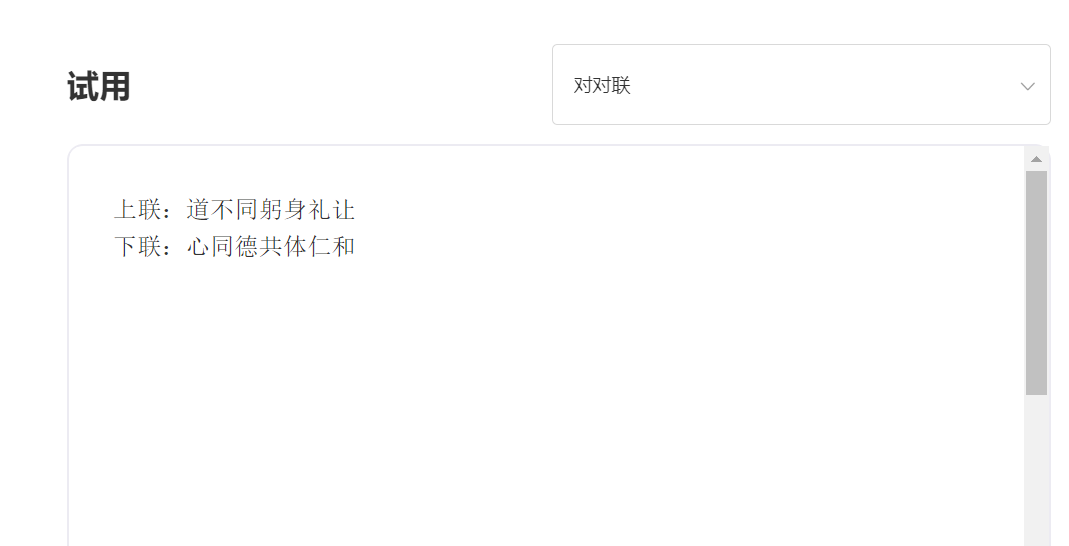

SkyText เป็นรุ่นใหญ่ที่ได้รับการฝึกฝนมาก่อน GPT3 ภาษาจีนที่เปิดตัวโดยเอกฐาน Zhiyuan ซึ่งสามารถทำงานที่แตกต่างกันเช่นแชทคำถามและคำตอบและการแปลภาษาจีน-อังกฤษ นอกเหนือจากการใช้การแชทขั้นพื้นฐานการสนทนาคำถามและคำตอบรุ่นนี้ยังสามารถรองรับการแปลภาษาจีนและภาษาอังกฤษความต่อเนื่องของเนื้อหาคู่การเขียนบทกวีโบราณการสร้างสูตรการสร้างโพสต์ใหม่บุคคลที่สามสร้างคำถามสัมภาษณ์และฟังก์ชั่นอื่น ๆ

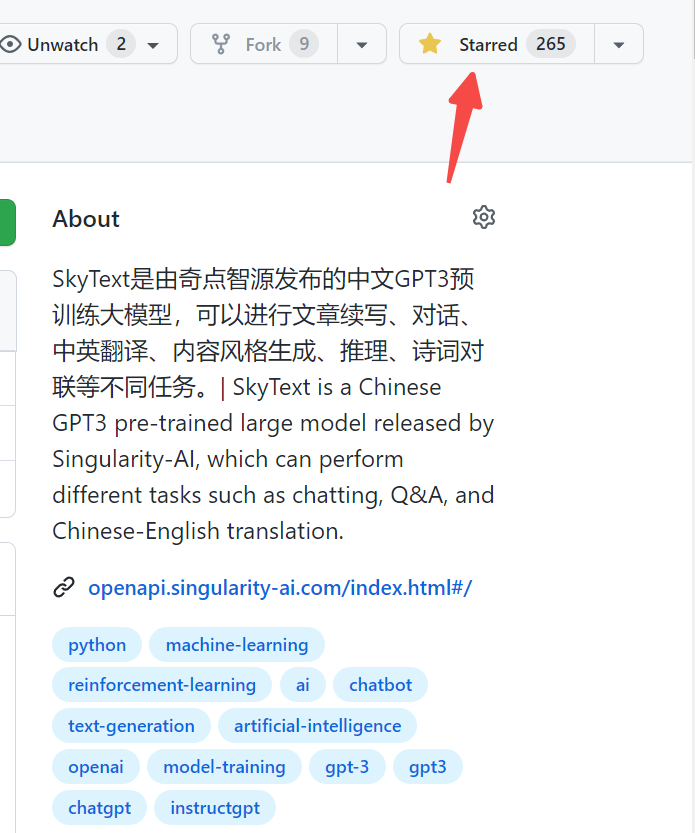

โมเดลพารามิเตอร์หนึ่งร้อยสี่พันล้าน [ปิดแหล่งที่มาชั่วคราวจะมีการปล่อยพารามิเตอร์พารามิเตอร์สิบพันล้านรุ่นใหม่ในไม่ช้าดังนั้นโปรดติดตาม! 】 https://huggingface.co/skywork/skytext

โมเดลพารามิเตอร์สามพันล้าน https://huggingface.co/skywork/skytexttiny

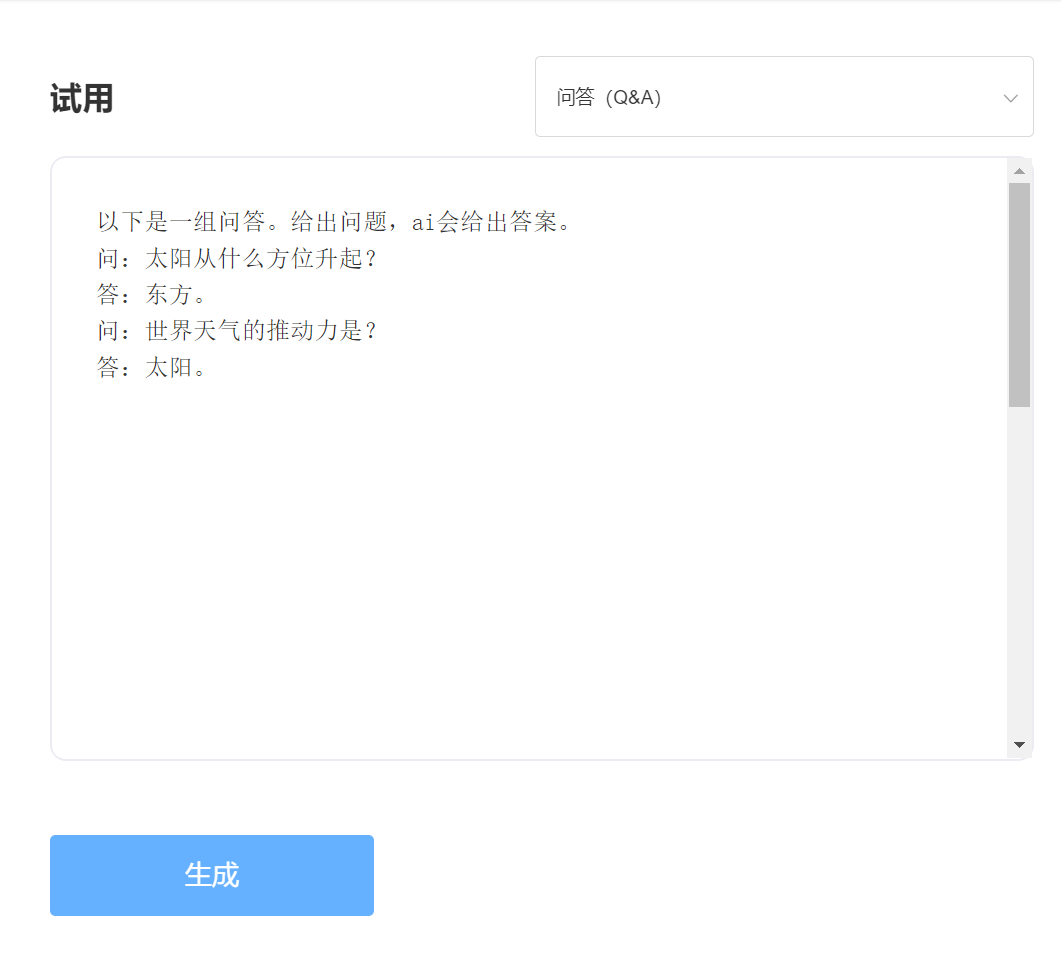

ประสบการณ์และการทดลองกรุณาเยี่ยมชมการทดลอง API อัจฉริยะที่เป็นเอกเทศ

เข้า:

เอาท์พุท:

ข้อได้เปรียบทางเทคนิค 1: การทำความสะอาดข้อมูลด้วยกระบวนการมากกว่า 30 กระบวนการ

ด้วยการพัฒนาเทคโนโลยี NLP โมเดลขนาดใหญ่ที่ผ่านการฝึกอบรมมาก่อนได้กลายเป็นหนึ่งในเทคโนโลยีหลักของปัญญาประดิษฐ์ แบบจำลองขนาดใหญ่ที่ผ่านการฝึกอบรมมาก่อนมักจะต้องได้รับการฝึกฝนข้อความขนาดใหญ่และข้อความออนไลน์โดยธรรมชาติกลายเป็นแหล่งสำคัญที่สุดของคลังข้อมูล คุณภาพของคลังการฝึกอบรมอย่างไม่ต้องสงสัยส่งผลโดยตรงต่อประสิทธิภาพของแบบจำลอง ในการฝึกอบรมแบบจำลองที่มีความสามารถที่โดดเด่นข่าวกรองเอกพจน์ใช้กระบวนการทำความสะอาดมากกว่า 30 กระบวนการเมื่อทำความสะอาดข้อมูล รายละเอียดที่ยอดเยี่ยมได้สร้างเอฟเฟกต์แบบจำลองที่ยอดเยี่ยม

ข้อได้เปรียบทางเทคนิค 2: วิธีการเข้ารหัสภาษาจีนที่เพิ่มประสิทธิภาพและสร้างสรรค์สิ่งใหม่ ๆ

ในสาขาของโมเดลขนาดใหญ่ก่อนการฝึกอบรมมันถูกครอบงำโดยชุมชนอังกฤษและความสำคัญของการฝึกอบรมรุ่นใหญ่ก่อนการใช้ในภาษาจีนนั้นชัดเจนในตัวเอง ซึ่งแตกต่างจากข้อความพินอินเป็นภาษาอังกฤษวิธีการป้อนข้อมูลภาษาจีนของรุ่นจีนที่ผ่านการฝึกอบรมมาก่อนควรแตกต่างกันอย่างชัดเจน Singularity Intelligence ใช้วิธีการเข้ารหัสจีนที่ไม่เหมือนใครตามลักษณะของภาษาจีนซึ่งสอดคล้องกับนิสัยการใช้ภาษาจีนและสร้างพจนานุกรมจีนที่เอื้อต่อการทำความเข้าใจแบบจำลอง

-

推荐

transformers>=4.18.0

# -*- coding: utf-8 -*-

from transformers import GPT2LMHeadModel

from transformers import AutoTokenizer

from transformers import TextGenerationPipeline

# 以 SkyWork/SkyText(13billions) 为例,还有 SkyWork/SkyTextTiny(2.6billions) 可用, 期待使用

model = GPT2LMHeadModel . from_pretrained ( "SkyWork/SkyText" )

tokenizer = AutoTokenizer . from_pretrained ( "SkyWork/SkyText" , trust_remote_code = True )

text_generator = TextGenerationPipeline ( model , tokenizer , device = 0 )

input_str = "今天是个好天气"

max_new_tokens = 20

print ( text_generator ( input_str , max_new_tokens = max_new_tokens , do_sample = True )) ใบอนุญาต MIT