เรียกใช้แบ็กเอนด์ LLM, API, ส่วนหน้าและบริการอย่างง่ายดายด้วยคำสั่งเดียว

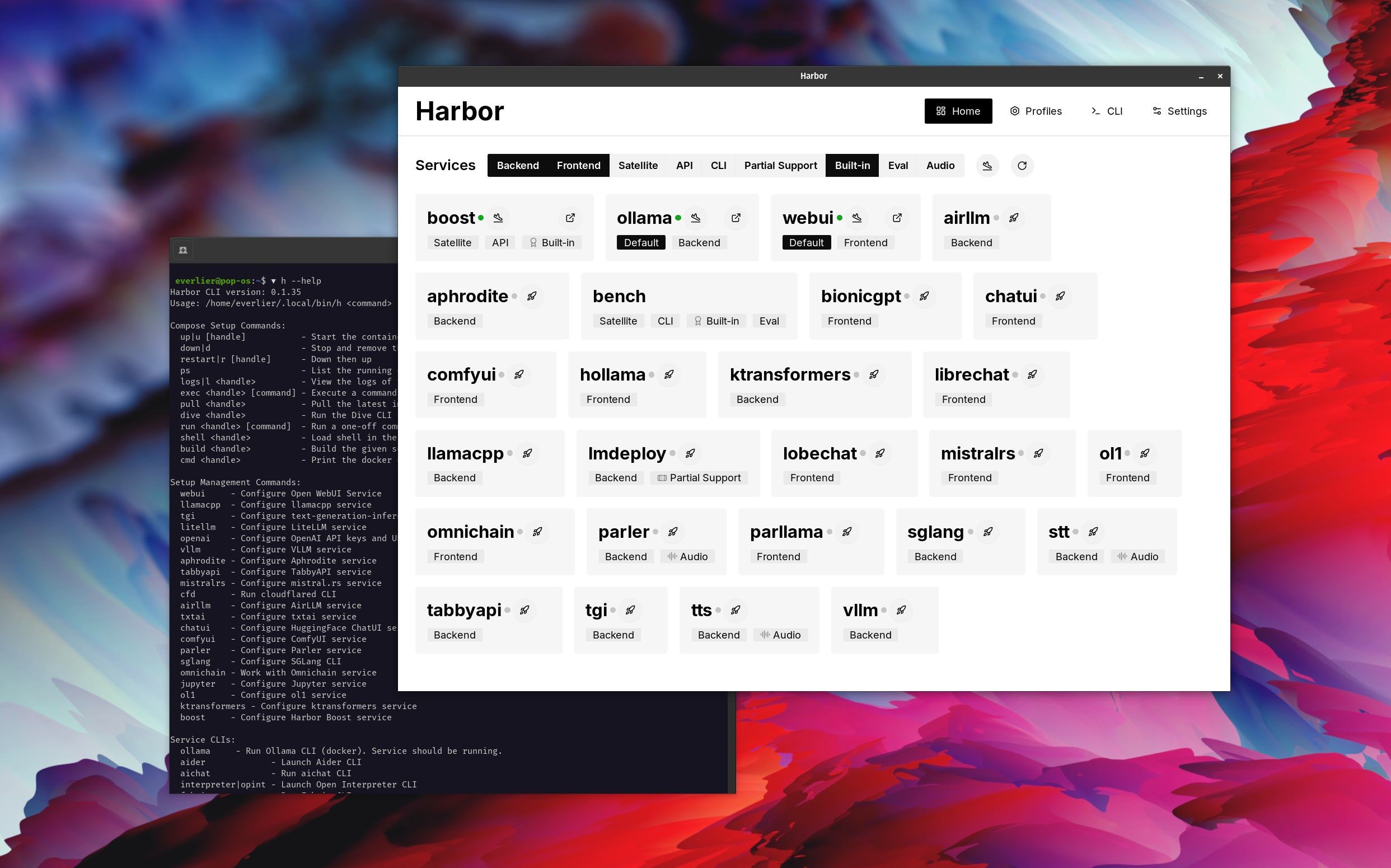

Harbour เป็นชุดเครื่องมือ LLM แบบคอนเทนเนอร์ที่ช่วยให้คุณเรียกใช้ LLM และบริการเพิ่มเติม ประกอบด้วย CLI และแอพสหายที่ให้คุณจัดการและเรียกใช้บริการ AI ได้อย่างง่ายดาย

เปิด webui ⦁︎ comfyui ⦁︎ librechat ⦁︎ huggingface chatui ⦁︎ lobe แชท⦁︎ hollama ⦁︎ parllama ⦁︎ bionicgpt ⦁︎อะไรก็ได้⦁︎แชท nio

Ollama ⦁︎ llama.cpp ⦁︎ vllm ⦁︎ tabbyapi ⦁︎ aphrodite engine ⦁︎ mistral.rs ⦁︎ openai-speech ⦁︎เร็วขึ้น-ไวรัสเซิร์ฟเวอร์⦁︎ parler ︎ SGLANG ⦁︎ KTRANSFORMERS ⦁︎ NEXA SDK

ม้านั่ง Harbour ⦁︎ Harbour Boost ⦁︎ searxng ⦁︎ perplexica ⦁︎ dify ⦁︎ plandex ⦁︎ litellm ⦁︎ langfuse ⦁︎ Open Interpreter ⦁Cloudflared⦁︎ CMDH ⦁︎ผ้า ︎ Omnichain ⦁︎ LM-Evaluation-Harness ⦁︎ Jupyterlab ⦁︎ OL1 ⦁︎⦁︎ OpenHands ⦁︎ litlytics ⦁︎ repopack ⦁︎ n8n ⦁︎ bolt.new ⦁︎เปิดท่อ webui ⦁︎ qdrant ⦁︎ k6 ⦁︎ protfffoo ⦁︎ webtop ⦁︎ omniparser ⦁︎ flowise

ดูเอกสารประกอบบริการสำหรับภาพรวมโดยย่อของแต่ละรายการ

# Run Harbor with default services:

# Open WebUI and Ollama

harbor up

# Run Harbor with additional services

# Running SearXNG automatically enables Web RAG in Open WebUI

harbor up searxng

# Run additional/alternative LLM Inference backends

# Open Webui is automatically connected to them.

harbor up llamacpp tgi litellm vllm tabbyapi aphrodite sglang ktransformers

# Run different Frontends

harbor up librechat chatui bionicgpt hollama

# Get a free quality boost with

# built-in optimizing proxy

harbor up boost

# Use FLUX in Open WebUI in one command

harbor up comfyui

# Use custom models for supported backends

harbor llamacpp model https://huggingface.co/user/repo/model.gguf

# Shortcut to HF Hub to find the models

harbor hf find gguf gemma-2

# Use HFDownloader and official HF CLI to download models

harbor hf dl -m google/gemma-2-2b-it -c 10 -s ./hf

harbor hf download google/gemma-2-2b-it

# Where possible, cache is shared between the services

harbor tgi model google/gemma-2-2b-it

harbor vllm model google/gemma-2-2b-it

harbor aphrodite model google/gemma-2-2b-it

harbor tabbyapi model google/gemma-2-2b-it-exl2

harbor mistralrs model google/gemma-2-2b-it

harbor opint model google/gemma-2-2b-it

harbor sglang model google/gemma-2-2b-it

# Convenience tools for docker setup

harbor logs llamacpp

harbor exec llamacpp ./scripts/llama-bench --help

harbor shell vllm

# Tell your shell exactly what you think about it

harbor opint

harbor aider

harbor aichat

harbor cmdh

# Use fabric to LLM-ify your linux pipes

cat ./file.md | harbor fabric --pattern extract_extraordinary_claims | grep " LK99 "

# Access service CLIs without installing them

harbor hf scan-cache

harbor ollama list

# Open services from the CLI

harbor open webui

harbor open llamacpp

# Print yourself a QR to quickly open the

# service on your phone

harbor qr

# Feeling adventurous? Expose your harbor

# to the internet

harbor tunnel

# Config management

harbor config list

harbor config set webui.host.port 8080

# Create and manage config profiles

harbor profile save l370b

harbor profile use default

# Lookup recently used harbor commands

harbor history

# Eject from Harbor into a standalone Docker Compose setup

# Will export related services and variables into a standalone file.

harbor eject searxng llamacpp > docker-compose.harbor.yml

# Run a build-in LLM benchmark with

# your own tasks

harbor bench run

# Gimmick/Fun Area

# Argument scrambling, below commands are all the same as above

# Harbor doesn't care if it's "vllm model" or "model vllm", it'll

# figure it out.

harbor model vllm

harbor vllm model

harbor config get webui.name

harbor get config webui_name

harbor tabbyapi shell

harbor shell tabbyapi

# 50% gimmick, 50% useful

# Ask harbor about itself

harbor how to ping ollama container from the webui ? ในการสาธิตแอพ Harbour ใช้เพื่อเปิดสแต็คเริ่มต้นด้วย Ollama และ Open Webui Services ต่อมา SeArxng ก็เริ่มต้นขึ้นและ WebUI สามารถเชื่อมต่อกับมันสำหรับ Web Rag ได้ทันที หลังจากนั้น Harbour Boost ก็เริ่มต้นและเชื่อมต่อกับ WebUI โดยอัตโนมัติเพื่อกระตุ้นผลลัพธ์ที่สร้างสรรค์มากขึ้น เป็นขั้นตอนสุดท้ายการกำหนดค่า Harbour จะถูกปรับในแอพสำหรับโมดูล klmbr ใน Harbour Boost ซึ่งทำให้เอาต์พุตไม่สามารถใช้งานได้สำหรับ LLM (ยังไม่สามารถแก้ไขได้สำหรับมนุษย์)

หากคุณพอใจกับ Docker และ Linux Administration - คุณอาจไม่จำเป็นต้องมีท่าเรือต่อ se เพื่อจัดการสภาพแวดล้อม LLM ในพื้นที่ของคุณ อย่างไรก็ตามคุณมีแนวโน้มที่จะมาถึงทางออกที่คล้ายกันในที่สุด ฉันรู้เรื่องนี้เพราะฉันกำลังตั้งค่าการตั้งค่าที่คล้ายกันมากโดยไม่มีเสียงนกหวีดและระฆังทั้งหมด

ท่าเรือไม่ได้รับการออกแบบให้เป็นโซลูชันการปรับใช้ แต่เป็นผู้ช่วยสำหรับสภาพแวดล้อมการพัฒนา LLM ในท้องถิ่น เป็นจุดเริ่มต้นที่ดีสำหรับการทดลองกับ LLM และบริการที่เกี่ยวข้อง

ในภายหลังคุณสามารถขับออกจากท่าเรือและใช้บริการในการตั้งค่าของคุณเองหรือใช้ Harbour เป็นฐานสำหรับการกำหนดค่าของคุณเอง

โครงการนี้ประกอบด้วยเชลล์ CLI ขนาดใหญ่พอสมควรไฟล์ .env ขนาดเล็กพอสมควรและไฟล์ enourmous (สำหรับหนึ่ง repo) จำนวนไฟล์ docker-compose

hf , ollama , ฯลฯ ) ผ่าน Docker โดยไม่ต้องติดตั้งharbor eject