Führen Sie mühelos LLM -Backends, APIs, Frontends und Dienste mit einem Befehl aus.

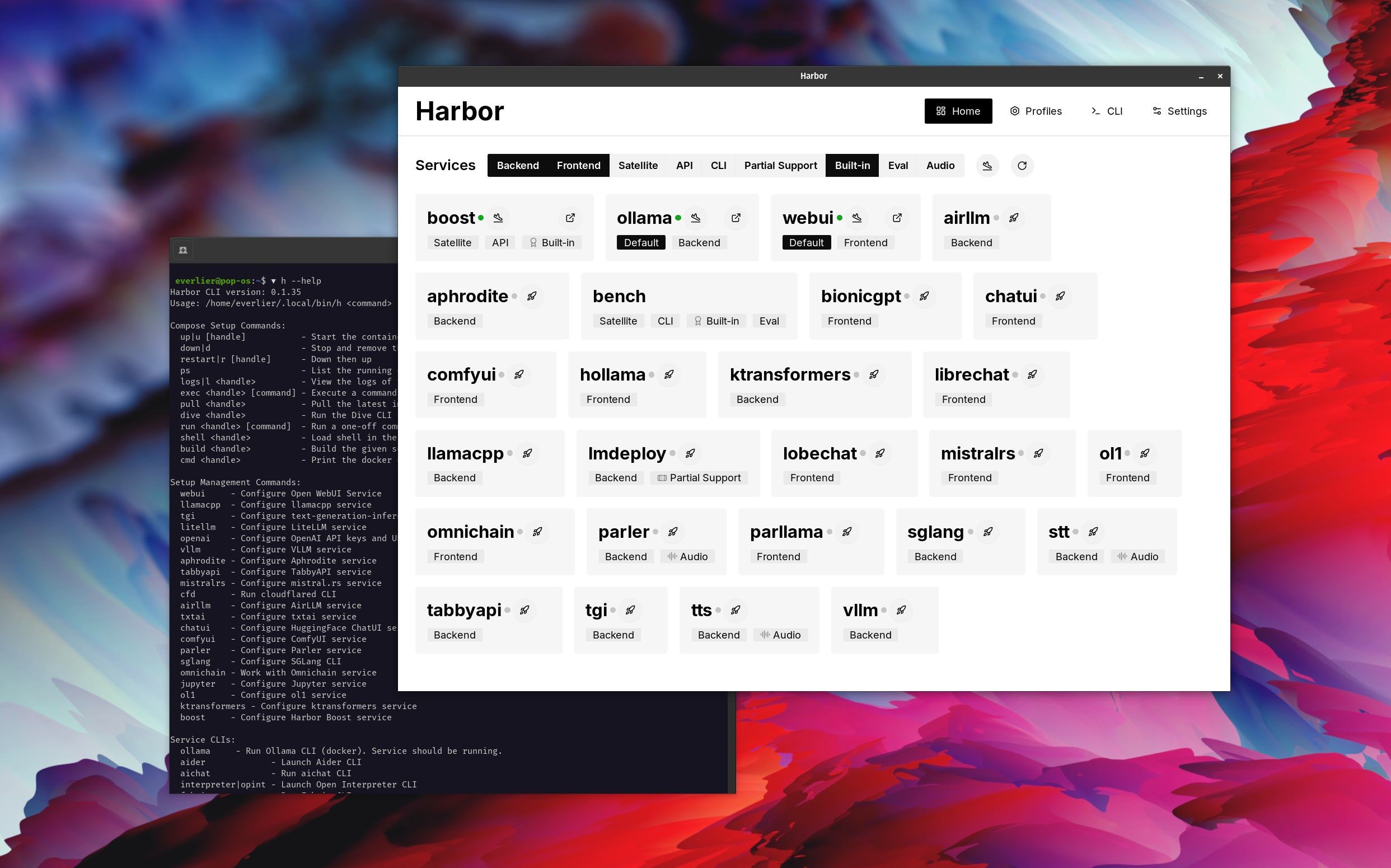

Harbor ist ein Container -LLM -Toolkit, mit dem Sie LLMs und zusätzliche Dienste ausführen können. Es besteht aus einer CLI und einer Companion -App, mit der Sie KI -Dienste problemlos verwalten und ausführen können.

Öffnen Sie Webui ⦁︎ Comfyui ⦁︎ librechat ⦁︎ Huggingface Chatui ⦁︎ Lappenatch Chat ⦁︎ Hollama ⦁︎ Parllama ⦁︎ bionicgpt ⦁︎ Anythingllm ⦁︎ Chat Nio

Ullama ⦁︎ llama.cpp ⦁︎ vllm ⦁︎ Tabbyapi ⦁︎ Aphrodite Engine ⦁︎ Mistral.rs ⦁︎ Openedai-Speech ⦁︎ schneller-Whisper-server ⦁︎ Parler ⦁︎ Text-Generation-Inferenz ⦁︎ lmdeploy ⦁︎ luftlungen ⦁ ︎ Sglang ⦁︎ Ktransformatoren ⦁︎ Nexa SDK

Harbor Bench ⦁︎ Harbor Boost ⦁︎ SearXNG ⦁︎ Perplexica ⦁︎ Dify ⦁︎ Plandex ⦁︎ LiteLLM ⦁︎ LangFuse ⦁︎ Open Interpreter ⦁ ︎cloudflared ⦁︎ cmdh ⦁︎ fabric ⦁︎ txtai RAG ⦁︎ TextGrad ⦁︎ Aider ⦁︎ aichat ⦁ ︎ Omnichain ⦁︎ LM-Evaluierungshärte ⦁︎ Jupyterlab ⦁︎ ol1 ⦁︎ OpenHands ⦁︎ Litlytics ⦁︎ Repopack ⦁︎ n8n ⦁︎ Bolt.New ⦁︎ Öffnen Sie Webui -Pipelines ⦁︎ Qdrant ⦁︎ K6 ⦁︎ promptfoo ⦁︎ Webtop ⦁︎ Omniparser ⦁︎ Flowise

Eine kurze Übersicht über die Dienste finden Sie in den Diensten.

# Run Harbor with default services:

# Open WebUI and Ollama

harbor up

# Run Harbor with additional services

# Running SearXNG automatically enables Web RAG in Open WebUI

harbor up searxng

# Run additional/alternative LLM Inference backends

# Open Webui is automatically connected to them.

harbor up llamacpp tgi litellm vllm tabbyapi aphrodite sglang ktransformers

# Run different Frontends

harbor up librechat chatui bionicgpt hollama

# Get a free quality boost with

# built-in optimizing proxy

harbor up boost

# Use FLUX in Open WebUI in one command

harbor up comfyui

# Use custom models for supported backends

harbor llamacpp model https://huggingface.co/user/repo/model.gguf

# Shortcut to HF Hub to find the models

harbor hf find gguf gemma-2

# Use HFDownloader and official HF CLI to download models

harbor hf dl -m google/gemma-2-2b-it -c 10 -s ./hf

harbor hf download google/gemma-2-2b-it

# Where possible, cache is shared between the services

harbor tgi model google/gemma-2-2b-it

harbor vllm model google/gemma-2-2b-it

harbor aphrodite model google/gemma-2-2b-it

harbor tabbyapi model google/gemma-2-2b-it-exl2

harbor mistralrs model google/gemma-2-2b-it

harbor opint model google/gemma-2-2b-it

harbor sglang model google/gemma-2-2b-it

# Convenience tools for docker setup

harbor logs llamacpp

harbor exec llamacpp ./scripts/llama-bench --help

harbor shell vllm

# Tell your shell exactly what you think about it

harbor opint

harbor aider

harbor aichat

harbor cmdh

# Use fabric to LLM-ify your linux pipes

cat ./file.md | harbor fabric --pattern extract_extraordinary_claims | grep " LK99 "

# Access service CLIs without installing them

harbor hf scan-cache

harbor ollama list

# Open services from the CLI

harbor open webui

harbor open llamacpp

# Print yourself a QR to quickly open the

# service on your phone

harbor qr

# Feeling adventurous? Expose your harbor

# to the internet

harbor tunnel

# Config management

harbor config list

harbor config set webui.host.port 8080

# Create and manage config profiles

harbor profile save l370b

harbor profile use default

# Lookup recently used harbor commands

harbor history

# Eject from Harbor into a standalone Docker Compose setup

# Will export related services and variables into a standalone file.

harbor eject searxng llamacpp > docker-compose.harbor.yml

# Run a build-in LLM benchmark with

# your own tasks

harbor bench run

# Gimmick/Fun Area

# Argument scrambling, below commands are all the same as above

# Harbor doesn't care if it's "vllm model" or "model vllm", it'll

# figure it out.

harbor model vllm

harbor vllm model

harbor config get webui.name

harbor get config webui_name

harbor tabbyapi shell

harbor shell tabbyapi

# 50% gimmick, 50% useful

# Ask harbor about itself

harbor how to ping ollama container from the webui ? In der Demo wird Harbor App verwendet, um einen Standard -Stack mit Ollama und Webui -Diensten zu eröffnen. Später wird auch Searxng gestartet und Webui kann eine Verbindung zum Weblagen direkt außerhalb der Box herstellen. Danach wird auch Harbour Boost gestartet und mit dem Webui automatisch angeschlossen, um kreativere Ausgaben zu induzieren. Als letzter Schritt wird die Harbor -Konfiguration in der App für das klmbr -Modul im Hafenschub eingestellt, wodurch die Ausgabe für das LLM (dennoch für den Menschen) unvergleichlich ist.

Wenn Sie mit Docker und Linux -Administration vertraut sind, benötigen Sie wahrscheinlich keinen Hafen per se, um Ihre lokale LLM -Umgebung zu verwalten. Sie werden jedoch auch wahrscheinlich zu einer ähnlichen Lösung kommen. Ich kenne das auf eine Tatsache, da ich ziemlich ähnliches Setup rockte, nur ohne all die Pfeifen und Glocken.

Harbor ist nicht als Bereitstellungslösung konzipiert, sondern als Helfer für die lokale LLM -Entwicklungsumgebung. Es ist ein guter Ausgangspunkt für das Experimentieren mit LLMs und verwandten Diensten.

Sie können später aus dem Hafen auswerfen und die Dienste in Ihrem eigenen Setup nutzen oder weiterhin Hafen als Basis für Ihre eigene Konfiguration verwenden.

Dieses Projekt besteht aus einer ziemlich großen Shell-CLI, einer ziemlich kleinen .env Datei und einer dockerischen docker-compose Dateien (für eine Repo).

hf , ollama usw.) über Docker ohne Installationharbor eject zu laufen