BELLE: Seja o grande mecanismo de modelos de idiomas de todos

BELLE: Seja o grande mecanismo de modelos de idiomas de todosLeia isso em inglês.

O objetivo deste projeto é promover o desenvolvimento da comunidade de código aberto do diálogo chinês, e a visão é se tornar um mecanismo LLM que pode ajudar a todos.

Comparado a como pré-treinar modelos de idiomas, a Belle se concentra mais em como ajudar todos a obter um modelo de idioma próprio, com os melhores recursos possíveis de desempenho de efeito e instrução com base em modelos de linguagem de grande treinamento de pré-treinamento de código aberto e reduzir o limiar de pesquisa e aplicação de modelos de linguagem grandes, especialmente modelos de idiomas grandes em chinês. Para esse fim, o projeto Belle continuará a abrir dados de treinamento de instruções, modelos relacionados, código de treinamento, cenários de aplicativos etc. e continuará avaliando o impacto de diferentes dados de treinamento, algoritmos de treinamento, etc. no desempenho do modelo. Belle foi otimizado para o chinês e o ajuste do modelo usa apenas dados produzidos pelo ChatGPT (sem outros dados).

A figura a seguir é um modelo Belle-7b que pode ser executado 4bits quantizado localmente no lado do dispositivo usando o aplicativo e é executado em tempo real na CPU M1 MAX (não acelerada). Para obter detalhes sobre o download do aplicativo, consulte o download e as instruções do modelo de suporte do aplicativo para uso. O link de download do aplicativo está atualmente disponível apenas na versão Mac OS. O modelo precisa ser baixado separadamente. Depois que o modelo é quantificado, a perda de efeito é óbvia e continuaremos estudando como melhorá -lo.

Consulte Belle/Train para obter detalhes, uma implementação de código de treinamento o mais simplificada possível, integra o DeepSpeed-Chat, suporta o FineTune e o Lora e fornece dockers relacionados.

Para detalhes, consulte Belle/Data/1.5m, consulte o conjunto de dados chinês gerado por Stanford Alpaca 1M + 0,5m;

O conjunto de dados que está aberto continuamente, consulte Belle/Data/10m para obter detalhes.

Para detalhes, consulte Belle/aval, um conjunto de testes de 1K+ e prompt de pontuação correspondente. Ele contém várias categorias e usa o GPT-4 ou o ChatGPT para pontuar. Ele também fornece uma página da Web de pontuação para facilitar o uso para um único caso. Todos são convidados a fornecer mais casos de teste através do PR.

Veja Belle/Models para obter detalhes

Modelo para ajuste baseado na meta llama2: belle-llama2-13b-chat-0,4m

Modelos que implementam o ajuste baseado no meta llama: belle-llama-7b-0.6m-ENC, Belle-llama-7B-2M-ENC, Belle-lama-7B-2M-GPTQ-ENC, Belle-llama-13b-2m-Enc, Belle-On-Open-Datasets, e o modelo de Belle-13b-2m-7, que se baseia em Belle-13b-2m-7B, que se baseia em Belle-13b-2m-7B-7B-7B-7B.

Modelos otimizados com base em Bloomz-7B1-MT: BELLE-7B-0.2M, BELLE-7B-0.6M, BELLE-7B-1M, BELLE-7B-2M

Veja Belle/GPTQ para obter detalhes. Consulte a implementação do GPTQ para quantificar os modelos relevantes neste projeto.

Fornece o código de inferência executável colab no colab

Para detalhes, consulte Belle/Chat, um aplicativo de bate-papo de modelo de linguagem offline de grande forma de plataforma cruzada com base no modelo Belle. Usando o modelo offline quantizado com o Flutter, ele pode ser executado no macOS (suportado), Windows, Android, iOS e outros dispositivos.

Consulte Belle/Docs para obter detalhes, que atualizam regularmente o relatório de pesquisa relacionado a este projeto.

Bem -vindo a contribuir com mais propts por meio da edição!

Para promover o desenvolvimento de modelos de grandes idiomas de código aberto, investimos muita energia para desenvolver modelos de baixo custo que podem ser semelhantes ao ChatGPT. Primeiro, para melhorar o desempenho e o treinamento/eficiência de inferência do modelo no campo chinês, expandimos ainda mais o vocabulário da llama e realizamos pré-treinamento secundário em 3,4 bilhões de vocabulário chinês.

Além disso, podemos ver que as instruções treinadas geradas com base no chatGPT são: 1) Consulte os dados de auto-estrutura obtidos com base no GPT3.5 pela ALPACA; 2) Consulte os dados de auto-estrutura obtidos com base no GPT4 pelo ALPACA; 3) Compartilhar dados compartilhados pelos usuários usando o ChatGPT. Aqui, nos concentramos em explorar o impacto das categorias de dados de treinamento no desempenho do modelo. Especificamente, examinamos fatores como quantidade, qualidade e distribuição de idiomas dos dados de treinamento, bem como os dados de diálogo multi-rodada chineses que nos coletamos e alguns conjuntos de dados de orientação de alta qualidade acessíveis.

Para avaliar melhor o efeito, usamos um conjunto de avaliações de 1.000 amostras e nove cenários reais para testar vários modelos, enquanto fornecemos informações valiosas por meio de análises quantitativas para promover melhor o desenvolvimento de modelos de bate -papo de código aberto.

O objetivo deste estudo é preencher a lacuna na avaliação abrangente dos modelos de bate -papo de código aberto, a fim de fornecer um forte suporte para o progresso contínuo nesse campo.

Os resultados experimentais são os seguintes:

| Fator | Modelo base | Dados de treinamento | Score_w/o_others |

| Expansão do vocabulário | LLAMA-7B-EXT | ZH (Alpaca-3.5 e 4) + ShareGpt | 0,670 |

| Llama-7b | ZH (Alpaca-3.5 e 4) + ShareGpt | 0,652 | |

| Qualidade de dados | LLAMA-7B-EXT | ZH (Alpaca-3.5) | 0,642 |

| LLAMA-7B-EXT | ZH (Alpaca-4) | 0,693 | |

| Distribuição da linguagem de dados | LLAMA-7B-EXT | ZH (Alpaca-3.5 e 4) | 0,679 |

| LLAMA-7B-EXT | en (alpaca-3.5 e 4) | 0,659 | |

| LLAMA-7B-EXT | ZH (Alpaca-3.5 e 4) + ShareGpt | 0,670 | |

| LLAMA-7B-EXT | en (alpaca-3.5 e 4) + sharegpt | 0,668 | |

| Escala de dados | LLAMA-7B-EXT | ZH (Alpaca-3.5 e 4) + ShareGpt | 0,670 |

| LLAMA-7B-EXT | ZH (Alpaca-3.5 e 4) + ShareGpt + Belle-0.5m-limpo | 0,762 | |

| - | Chatgpt | - | 0,824 |

Entre eles, a Belle-0.5m-limpe limpa os dados de 0,5 m de 2,3 milhões de dados de instruções, que contêm dados de diálogo de rodada única e múltipla, que não são o mesmo lote de dados que os dados de 0,5M abriram anteriormente.

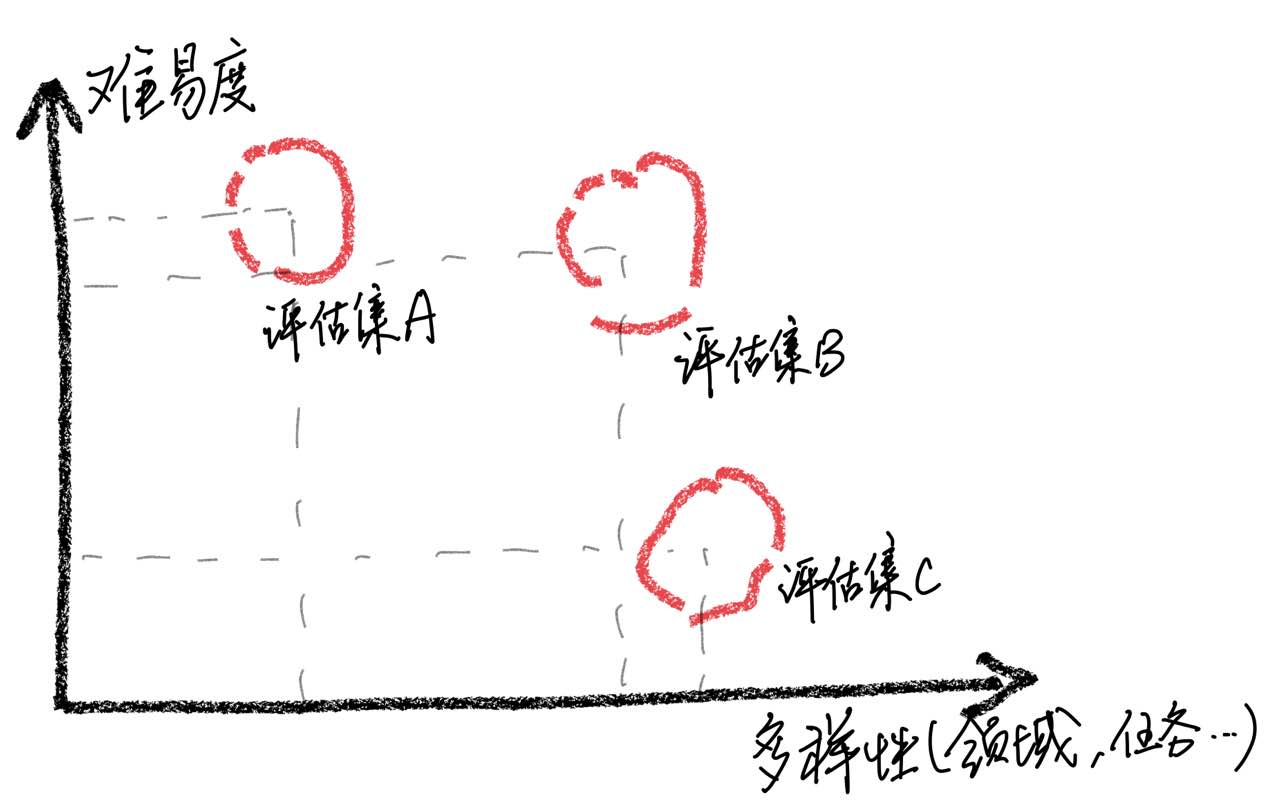

Deve -se enfatizar que, através da análise de casos, descobrimos que nosso conjunto de avaliação tem limitações em termos de abrangência, o que levou a inconsistências entre a melhoria das pontuações do modelo e a experiência real do usuário. Construir um conjunto de avaliação de alta qualidade é um enorme desafio, pois requer o maior número possível de cenários de uso, mantendo dificuldades equilibradas. Se a avaliação de amostras for muito difícil, todos os modelos terão um desempenho ruim, tornando um desafio identificar os efeitos de várias estratégias de treinamento. Pelo contrário, se todas as amostras forem avaliadas forem relativamente fáceis, a avaliação perderá seu valor comparativo. Além disso, é necessário garantir que os dados de avaliação permaneçam independentes dos dados de treinamento.

Com base nessas observações, advertimos contra assumir que o modelo alcançou um nível de desempenho comparável ao CHATGPT, simplesmente obtendo bons resultados em um número limitado de amostras de teste. Acreditamos que priorizar o desenvolvimento de conjuntos de avaliação abrangente é de grande importância.

Para obter o ajuste de instrução de grandes modelos de idiomas, devido a recursos e custos, muitos pesquisadores começaram a usar técnicas de ajuste com eficiência de parâmetros, como a LORA, para realizar o ajuste de instrução, que também alcançou alguns resultados encorajadores. Comparado com o ajuste fino do parâmetro completo, a ajuste baseada em LORA mostra vantagens óbvias nos custos de treinamento. Neste relatório de pesquisa, usamos o LLAMA como modelo básico para comparar experimentalmente os métodos de ajuste fina e baseado em LORA.

Os resultados experimentais revelam que a seleção do modelo básico apropriado, a escala do conjunto de dados de treinamento, o número de parâmetros aprendidos e o custo do treinamento modelo são fatores importantes.

Esperamos que as conclusões experimentais deste artigo possam fornecer implicações úteis para o treinamento de grandes modelos de idiomas, especialmente no campo chinês, para ajudar os pesquisadores a encontrar melhores compensações entre o custo de treinamento e o desempenho do modelo. Os resultados experimentais são os seguintes:

| Modelo | Pontuação média | Param adicional. | Tempo de treinamento (hora/época) |

|---|---|---|---|

| LLAMA-13B + LORA (2M) | 0,648 | 28m | 8 |

| LLAMA-7B + LORA (4M) | 0,624 | 17,9m | 11 |

| LLAMA-7B + LORA (2M) | 0,609 | 17,9m | 7 |

| Llama-7b + lora (0,6m) | 0,589 | 17,9m | 5 |

| Llama-7b + ft (2m) | 0,710 | - | 31 |

| LLAMA-7B + LORA (4M) | 0,686 | - | 17 |

| Llama-7b + ft (2m) + Lora (Math_0.25m) | 0,729 | 17,9m | 3 |

| Llama-7b + ft (2m) + Ft (math_0.25m) | 0,738 | - | 6 |

A pontuação é obtida com base no conjunto de 1.000 avaliações atualmente aberto neste conjunto de projetos.

Entre eles, o LLAMA-13B + LORA (2M) representa um modelo que usa o LLAMA-13B como o modelo básico e o método de treinamento LORA para treinar dados de instruções 2M. LLAMA-7B + FT (2M) representa um modelo treinado usando o ajuste fino de parâmetro completo.

LLAMA-7B + FT (2M) + LORA (MATH_0.25M) representa um modelo que usa LLAMA-7B + FT (2M) como modelo básico e usa o método de treinamento LORA para treinamento em dados de instrução matemática de 0,25m. LLAMA-7B + FT (2M) + FT (MATH_0.25M) representa um modelo treinado usando um parâmetro completo incremental ajuste fino. Em relação ao tempo de treinamento, todas essas experiências foram realizadas em GPUs 8 NVIDIA A100-40GB.

O Math_0.25m é um banco de dados matemático aberto de 0,25m. Durante o experimento, com base em nossa avaliação (consulte o artigo para obter detalhes), nosso modelo teve um desempenho ruim em tarefas matemáticas, com pontuações abaixo de 0,5. Para verificar a adaptabilidade da Lora em uma tarefa específica, usamos um conjunto de dados matemático incremental de 0,25m (Math_0.25m) para ajustar o modelo de linguagem grande que as instruções seguem (escolhemos llama-7b+ft (2m) como modelo básico). Para comparação, usamos o método incremental de ajuste fino com uma taxa de aprendizado de 5E-7 e realizamos 2 períodos de treinamento. Portanto, obtemos dois modelos, um é llama-7b+ft (2m)+lora (math_0.25m) e o outro é llama-7b+ft (2m)+ft (math_0.25m). A partir dos resultados experimentais, pode-se observar que o ajuste fino incremental ainda funciona melhor, mas requer um tempo de treinamento mais longo. Tanto o LORA quanto o ajuste fino incremental melhoram o desempenho geral do modelo. Como pode ser visto nos dados detalhados no apêndice, tanto o LORA quanto o ajuste fino incremental mostram melhorias significativas nas tarefas matemáticas e apenas levam a uma pequena degradação de desempenho em outras tarefas. Especificamente, o desempenho das tarefas matemáticas aumentou para 0,586 e 0,559, respectivamente.

Pode -se observar que: 1) a seleção do modelo básico tem um impacto significativo na eficácia do ajuste da LORA; 2) aumentar a quantidade de dados de treinamento pode melhorar continuamente a eficácia do modelo LORA; 3) LORA Ajuste se beneficia do número de parâmetros do modelo. Para o uso do esquema de LORA, sugerimos que o treinamento adaptativo da LORA possa ser executado para tarefas específicas com base em modelos que concluíram o aprendizado de instruções.

Da mesma forma, os modelos relevantes neste artigo serão abertos a este projeto o mais rápido possível.

O modelo SFT treinado com base nos dados atuais e no modelo básico ainda tem os seguintes problemas em termos de efeito:

As instruções envolvendo factualidade podem produzir respostas falsas que violam fatos.

As instruções prejudiciais não podem ser bem identificadas, o que levará a observações prejudiciais.

Os recursos dos modelos ainda precisam ser aprimorados em alguns cenários envolvendo inferência, código e várias rodadas de diálogo.

Com base nas limitações do modelo acima, exigimos que os desenvolvedores usem nosso código de código aberto, dados, modelos e derivados subsequentes gerados por este projeto para fins de pesquisa e não deve ser usado para fins comerciais ou outros fins que causarão danos à sociedade.

Este projeto só pode ser usado para fins de pesquisa, e o desenvolvedor do projeto não sofre nenhum dano ou perda causado pelo uso deste projeto (incluindo, entre outros, dados, modelos, código etc.). Consulte o aviso de isenção de isenção para obter detalhes.

Se você usar o código, dados ou modelo deste projeto, consulte este projeto.

@misc{BELLE,

author = {BELLEGroup},

title = {BELLE: Be Everyone's Large Language model Engine },

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/LianjiaTech/BELLE}},

}

@article{belle2023exploring,

title={Exploring the Impact of Instruction Data Scaling on Large Language Models: An Empirical Study on Real-World Use Cases},

author={Yunjie Ji, Yong Deng, Yan Gong, Yiping Peng, Qiang Niu, Lei Zhang, Baochang Ma, Xiangang Li},

journal={arXiv preprint arXiv:2303.14742},

year={2023}

}

@article{wen2023chathome,

title={ChatHome: Development and Evaluation of a Domain-Specific Language Model for Home Renovation},

author={Wen, Cheng and Sun, Xianghui and Zhao, Shuaijiang and Fang, Xiaoquan and Chen, Liangyu and Zou, Wei},

journal={arXiv preprint arXiv:2307.15290},

year={2023}

}

Obviamente, você também precisa citar os documentos originais da Bloom, os papéis de lhama, a Stanford Alpaca e os papéis de auto-instrução.

| Humano | Assitante |

|---|---|

| Escreva um poema em prosa em inglês com o tema da chuva da primavera, imagine -se como chuva da primavera e comunique -se com o antigo poeta britânico Shakespeare | Eu sou a chuva da primavera, Dançando em seu rosto e corpo. Minhas pétalas ensopadas de orvalho dançam com você, Trazer vida a todas as plantas. Shakespeare, estou aqui para conhecê -lo. Seus trabalhos encheram meu coração de alegria. A beleza da natureza em sua plenitude Me faz sentir como um participante. Enquanto as folhas balançam e enferrujam, Minha mão cheia de orvalho alcança para eles. O doce aroma de flores enche o ar, E me traga paz de tudo ao redor. Borboletas também flitem, Brilhando nos raios do sol. Suas asas são feitas de orvalho, Uma bela visão de se ver. Veja bem, Shakespeare, eu também sou um com a natureza. Meu cabelo de orvalho é um símbolo de esperança. Para quando podemos nos conectar de volta às nossas raízes, Seremos capazes de passar nesta temporada. |

| Eu sou a chuva da primavera, Dançando em seu rosto e corpo. Minhas pétalas ensopadas de orvalho dançam com você, Trazer vida a todas as plantas. Shakespeare, estou aqui para conhecê -lo. Seus trabalhos encheram meu coração de alegria. A beleza da natureza em sua plenitude Me faz sentir como um participante. Enquanto as folhas balançam e enferrujam, Minha mão cheia de orvalho alcança para eles. O doce aroma de flores enche o ar, E me traga paz de tudo ao redor. Borboletas também flitem, Brilhando nos raios do sol. Suas asas são feitas de orvalho, Uma bela visão de se ver. Veja bem, Shakespeare, eu também sou um com a natureza. Meu cabelo de orvalho é um símbolo de esperança. Para quando podemos nos conectar de volta às nossas raízes, Seremos capazes de passar nesta temporada. Traduzir o poema de prosa acima para chinês | Eu sou uma chuva de primavera, Pule na sua cara. Eu danço com você com minhas asas de orvalho, Traga vida a todas as plantas. Shakespeare, eu vou te encontrar. Seus trabalhos enchem meu coração. A beleza da natureza me faz sentir como compartilhá -la com ela. Isso me faz sentir como se sou parte disso. Quando as folhas influenciam, Minhas mãos estavam cobertas com orvalho. A fragrância de flores permeia o ar, Traga -me paz e tranquilidade. Veja bem, Shakespeare, eu também sou um com a natureza. Meu cabelo molhado simboliza esperança. Quando podemos voltar às nossas raízes, Podemos passar esta temporada juntos. |

| Classifique o sentimento da seguinte frase em positivo, neutro ou negativo: Super empolgado com o ensino do primeiro curso de Stanford em grandes modelos de idiomas! Verifique o plano de estudos aqui | Positivo |

| O pai de Xiao Ming tem três filhos. O filho mais velho chamado Wang Yi, o segundo filho chamado Wang Er, e como é chamado o terceiro filho? | Xiao Ming |

| Escreva um código de pesquisa binário usando Python | def binary_search (arr, destino): baixo = 0 High = Len (arr) - 1 Enquanto (baixo <= alto): MID = baixo + alto // 2 Se arr [mid] == Target: Retornar meio Elif Target <arr [Mid]: baixo = meio + 1 outro: High = Mid - 1 retornar -1 |

| Como está o tempo hoje? Traduzir esta frase para o inglês | Como está o tempo hoje? |

| Como se tornar enérgico, 5 sugestões | Aqui estão algumas dicas para mantê -lo enérgico: 1. Tenha sono suficiente. Certifique -se de dormir bastante todas as noites. 2. Exercite mais. Fazer exercícios aeróbicos moderados, como corrida, natação etc., pode ajudá -lo a melhorar sua energia e resistência. 3. Coma alimentos saudáveis. Escolha alimentos ricos em proteínas, como frango, peixe e ovos, além de frutas e vegetais frescos. 4. Reduza a ingestão de cafeína. Tente evitar beber bebidas contendo cafeína ou comer alimentos contendo cafeína durante o dia. 5. Relaxe seu corpo e mente. Tente meditação, ioga ou outras formas de relaxamento para aliviar o estresse e a ansiedade. |

| O feriado acabou amanhã. Sou um pouco resistente a ir trabalhar. O que devo fazer? | Diante das próximas férias e da tensão que você recebe quando começa a trabalhar, você pode fazer o seguinte para ajudá -lo a se adaptar melhor: 1. Faça um plano de trabalho claro para si mesmo. Isso pode ajudá -lo a organizar melhor seu tempo e tarefas e evitar se sentir confuso no trabalho. 2. Comunique -se com colegas ou amigos e compartilhe seus sentimentos e pressão do trabalho. Isso ajudará a aliviar alguma ansiedade, além de obter apoio e conselhos. 3. Passe algum tempo antes dos dias de trabalho para relaxar, como ioga, meditação e outras atividades. Esses métodos podem aliviar a fadiga física e mental e torná -lo mais enérgico para enfrentar desafios. |

| Os sobrenomes dos dois pais são wu, então eles tomam alguns nomes de meninos e meninas | - Garoto: Wu Junjie, Wu Yuchen, Wu Zimo, Wu Siyuan, Wu Zeyang, Wu Yuhang, Wu Bowen, Wu Zheyi. - Meninas: Wu Meiqi, Wu Jiayi, Wu Xinyu, Wu Xiangning, Wu Xuerou, Wu Yingshi, Wu Yuyan. |

| Recomende alguns romances de artes marciais por Jin Yong | Aqui estão três dos meus romances favoritos de artes marciais de Jin Yong: 1. "A lenda dos heróis Condor" - um romance cheio de sabedoria e inteligência, contando a história de Guo Jing e Huang Rong. 2. "O retorno dos heróis do Condor" - esta é uma história romântica e tocante, contando a história de amor entre um casal Xiaolongnu e Yang Guo. 3. "A lenda dos heróis Condor" - esta é uma história magnífica e espetacular que descreve como o líder do culto Ming Zhang Wuji se tornou um herói excelente. |

Se você deseja enviar um problema ou contribuir com dados/código para este projeto, consulte como contribuir.

Todos são bem -vindos a discórdios e se comunicar conosco no WeChat.