Belle: Soyez le moteur de modèle de grande langue de tout le monde

Belle: Soyez le moteur de modèle de grande langue de tout le mondeLisez ceci en anglais.

L'objectif de ce projet est de promouvoir le développement de la communauté open source du Big Mode Source chinois, et la vision est de devenir un moteur LLM qui peut aider tout le monde.

Comparé à la façon de pré-entraîner les modèles de grande langue, Belle se concentre davantage sur la façon d'aider tout le monde à obtenir un modèle de langue, avec les meilleurs effets possibles et les capacités de performance de l'enseignement basées sur des modèles de grande langue open source, et réduire le seuil de recherche et d'application de modèles de langues importants, en particulier les modèles de langues en chinois. À cette fin, le projet Belle continuera d'ouvrir les données de formation de l'enseignement, les modèles connexes, le code de formation, les scénarios d'application, etc., et continuera d'évaluer l'impact des différentes données de formation, des algorithmes de formation, etc. sur les performances du modèle. Belle a été optimisée pour le chinois et le réglage du modèle utilise uniquement des données produites par ChatGpt (sans aucune autre donnée).

Le chiffre suivant est un modèle Belle-7b qui peut être exécuté 4 bits quantifié localement du côté de l'appareil à l'aide de l'application, et s'exécute en temps réel sur le CPU M1 MAX (non accéléré). Pour plus de détails sur le téléchargement de l'application, veuillez consulter le téléchargement du modèle de support de l'application et les instructions à utiliser. Le lien de téléchargement de l'application n'est actuellement disponible que sur la version Mac OS. Le modèle doit être téléchargé séparément. Une fois le modèle quantifié, la perte d'effet est évidente et nous continuerons à étudier comment l'améliorer.

Voir Belle / Train pour plus de détails, une implémentation de code de formation qui est aussi simplifiée que possible, intègre Deeppeed-chat, prend en charge Finetune et Lora et fournit des dockers connexes.

Pour plus de détails, voir Belle / Data / 1,5m, reportez-vous à l'ensemble de données chinois généré par Stanford Alpaca 1m + 0,5 m;

L'ensemble de données qui est en permanence ouvert, veuillez vous référer à Belle / Data / 10M pour plus de détails.

Pour plus de détails, voir Belle / Eval, un ensemble de tests 1K + et une invite de notation correspondante. Il contient plusieurs catégories et utilise GPT-4 ou Chatgpt pour marquer. Il fournit également une page Web de notation pour une utilisation facile pour un seul cas. Tout le monde est invité à fournir plus de cas de test via PR.

Voir Belle / Modèles pour plus de détails

Modèle pour le réglage basé sur Meta Llama2: Belle-Ellema2-13B-CHAT-0.4M

Models that implement tuning based on Meta LLaMA: BELLE-LLaMA-7B-0.6M-enc , BELLE-LLaMA-7B-2M-enc , BELLE-LLaMA-7B-2M-gptq-enc , BELLE-LLaMA-13B-2M-enc , BELLE-on-Open-Datasets , and the pre-trained model BELLE-LLaMA-EXT-7B, which is based on LLaMA, has been expanded in Chinese vocabulaire.

Modèles optimisés sur la base de Bloomz-7b1-MT: Belle-7B-0,2M, Belle-7B-0,6m, Belle-7B-1M, Belle-7B-2M

Voir Belle / GPTQ pour plus de détails. Reportez-vous à l'implémentation de GPTQ pour quantifier les modèles pertinents dans ce projet.

Fournit le code d'inférence Runnable Colab sur Colab

Pour plus de détails, voir Belle / Chat, une application de chat de modèle de grande langue hors ligne sur la plateforme basée sur le modèle Belle. En utilisant le modèle hors ligne quantifié avec Flutter, il peut fonctionner sur macOS (pris en charge), Windows, Android, iOS et d'autres appareils.

Voir Belle / Docs pour plus de détails, qui mettra à jour régulièrement le rapport de recherche lié à ce projet.

Bienvenue pour contribuer plus de propts grâce à la question!

Afin de promouvoir le développement de modèles de langues open source, nous avons investi beaucoup d'énergie pour développer des modèles à faible coût qui peuvent être similaires à Chatgpt. Premièrement, afin d'améliorer les performances et l'efficacité de la formation / inférence du modèle dans le domaine chinois, nous avons encore étendu le vocabulaire de LLAMA et effectué une pré-formation secondaire sur 3,4 milliards de vocabulaire chinois.

De plus, nous pouvons voir que les données formées des instructions générées sur la base de ChatGPT sont: 1) se référer aux données d'auto-instruction obtenues sur la base de GPT3.5 par Alpaca; 2) Reportez-vous aux données d'auto-instruction obtenues sur la base de GPT4 par Alpaca; 3) Données ShareGPT partagées par les utilisateurs à l'aide de ChatGpt. Ici, nous nous concentrons sur l'exploration de l'impact des catégories de données de formation sur les performances du modèle. Plus précisément, nous examinons des facteurs tels que la quantité, la qualité et la répartition linguistique des données de formation, ainsi que les données de dialogue chinois à plusieurs rondes que nous avons collectées nous-mêmes, et certains ensembles de données de guidage de haute qualité accessibles au public.

Pour mieux évaluer l'effet, nous avons utilisé un ensemble d'évaluation de 1 000 échantillons et neuf scénarios réels pour tester divers modèles, tout en fournissant des informations précieuses grâce à une analyse quantitative pour mieux favoriser le développement de modèles de chat open source.

L'objectif de cette étude est de combler l'écart dans l'évaluation complète des modèles de discussion open source afin de fournir un fort soutien aux progrès continus dans ce domaine.

Les résultats expérimentaux sont les suivants:

| Facteur | Modèle de base | Données de formation | Score_w / o_others |

| Expansion du vocabulaire | LLAMA-7B-EXT | ZH (Alpaca-3.5 & 4) + Sharegpt | 0,670 |

| Lama-7b | ZH (Alpaca-3.5 & 4) + Sharegpt | 0,652 | |

| Qualité des données | LLAMA-7B-EXT | ZH (Alpaca-3.5) | 0,642 |

| LLAMA-7B-EXT | zh (alpaca-4) | 0,693 | |

| Distribution de la langue des données | LLAMA-7B-EXT | ZH (Alpaca-3.5 et 4) | 0,679 |

| LLAMA-7B-EXT | en (alpaca-3.5 et 4) | 0,659 | |

| LLAMA-7B-EXT | ZH (Alpaca-3.5 & 4) + Sharegpt | 0,670 | |

| LLAMA-7B-EXT | en (alpaca-3.5 & 4) + sharegpt | 0,668 | |

| Échelle de données | LLAMA-7B-EXT | ZH (Alpaca-3.5 & 4) + Sharegpt | 0,670 |

| LLAMA-7B-EXT | ZH (Alpaca-3.5 & 4) + Sharegpt + Belle-0,5 m-Clean | 0,762 | |

| - | Chatte | - | 0,824 |

Parmi eux, Belle-0,5 m-Clean nettoie les données de 0,5 m à partir de 2,3 millions de données d'instruction, qui contient des données de dialogue à un seul tour et à plusieurs balles, qui n'est pas le même lot de données que les données de 0,5 m précédemment ouvertes.

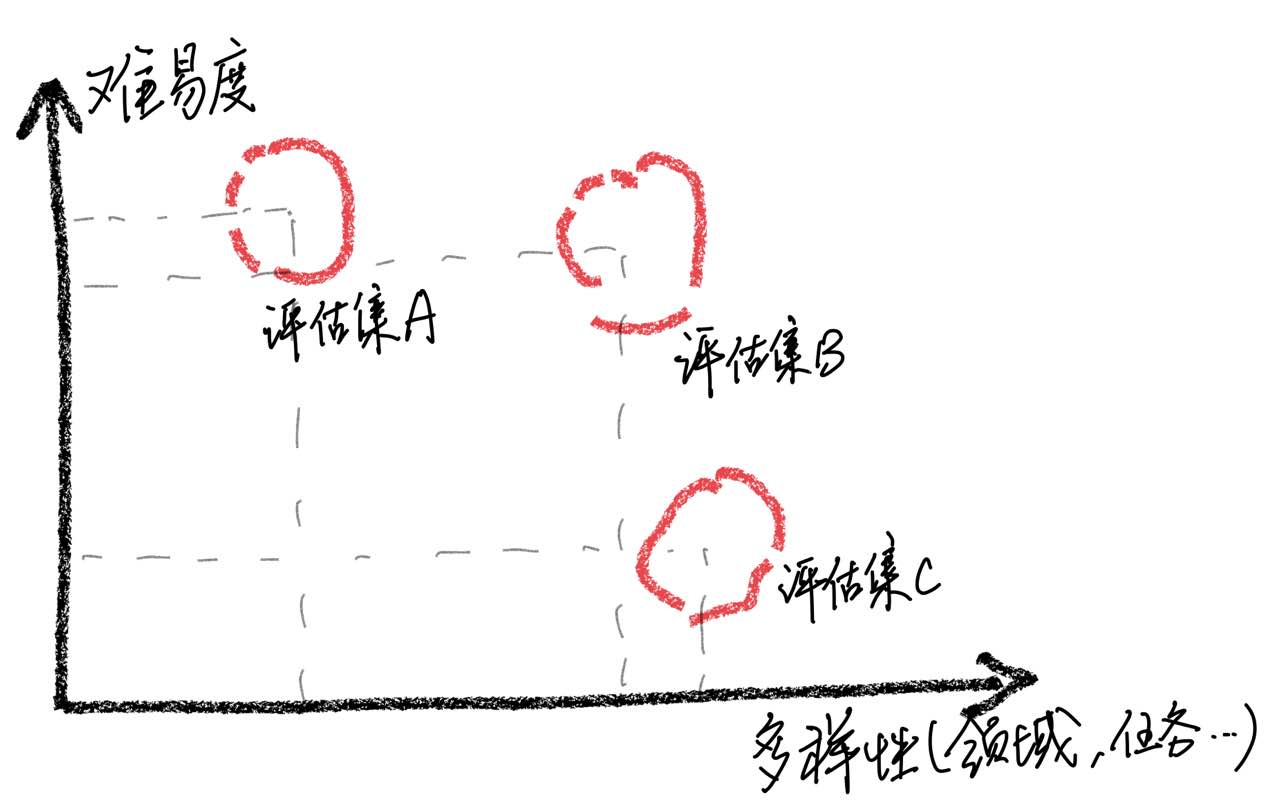

Il convient de souligner que grâce à l'analyse de cas, nous avons constaté que notre ensemble d'évaluation a des limites en termes de compréhension, ce qui a conduit à des incohérences entre l'amélioration des scores du modèle et l'expérience utilisateur réelle. La construction d'un ensemble d'évaluation de haute qualité est un énorme défi car il nécessite autant de scénarios d'utilisation que possible tout en maintenant des difficultés équilibrées. Si l'évaluation des échantillons est pour la plupart trop difficile, tous les modèles fonctionnent mal, ce qui rend difficile d'identifier les effets de diverses stratégies de formation. Au contraire, si tous les échantillons sont évalués sont relativement faciles, l'évaluation perdra sa valeur comparative. De plus, il est nécessaire de s'assurer que les données d'évaluation restent indépendantes des données de formation.

Sur la base de ces observations, nous mettons en garde contre la supposition que le modèle a atteint un niveau de performance comparable à Chatgpt en obtenant simplement de bons résultats sur un nombre limité d'échantillons de test. Nous pensons que la priorisation du développement d'ensembles d'évaluation complets est d'une grande importance.

Afin de parvenir à un réglage des instructions de grands modèles de langage, en raison des ressources et des coûts, de nombreux chercheurs ont commencé à utiliser des techniques de réglage économe en paramètres, telles que LORA, à effectuer un réglage des instructions, qui a également obtenu des résultats encourageants. Par rapport à un réglage fin à paramètre complet, le réglage basé sur LORA montre des avantages évidents dans les coûts de formation. Dans ce rapport de recherche, nous avons utilisé LLAMA comme modèle de base pour comparer expérimentalement les méthodes de réglage fin et basées sur le paramètre complet.

Les résultats expérimentaux révèlent que la sélection du modèle de base approprié, l'échelle de l'ensemble de données de formation, le nombre de paramètres apprenables et le coût de la formation du modèle sont tous des facteurs importants.

Nous espérons que les conclusions expérimentales de ce document pourront fournir des implications utiles pour la formation de modèles de langue importants, en particulier dans le domaine chinois, pour aider les chercheurs à trouver de meilleurs compromis entre le coût de la formation et les performances du modèle. Les résultats expérimentaux sont les suivants:

| Modèle | Score moyen | Param. | Temps de formation (heure / époque) |

|---|---|---|---|

| LLAMA-13B + LORA (2M) | 0,648 | 28m | 8 |

| LLAMA-7B + LORA (4m) | 0,624 | 17,9 m | 11 |

| LLAMA-7B + LORA (2M) | 0,609 | 17,9 m | 7 |

| LLAMA-7B + LORA (0,6 m) | 0,589 | 17,9 m | 5 |

| LLAMA-7B + FT (2M) | 0,710 | - | 31 |

| LLAMA-7B + LORA (4m) | 0,686 | - | 17 |

| LLAMA-7B + FT (2M) + Lora (Math_0.25m) | 0,729 | 17,9 m | 3 |

| LLAMA-7B + FT (2M) + Ft (math_0.25m) | 0,738 | - | 6 |

Le score est obtenu sur la base de l'ensemble d'évaluation de 1 000 actuellement ouverts dans cet ensemble de projets.

Parmi eux, LLAMA-13B + LORA (2M) représente un modèle qui utilise LLAMA-13B comme modèle de base et la méthode de formation LORA pour s'entraîner sur les données d'instructions 2M. LLAMA-7B + FT (2M) représente un modèle formé en utilisant un réglage fin des paramètres complets.

LLAMA-7B + FT (2M) + LORA (MATH_0.25M) représente un modèle qui utilise LLAMA-7B + FT (2M) comme modèle de base et utilise la méthode de formation LORA pour une formation sur des données d'enseignement mathématique 0,25M. LLAMA-7B + FT (2M) + FT (MATH_0.25M) représente un modèle formé en utilisant un réglage fin de paramètre complet incrémentiel. En ce qui concerne le temps de formation, toutes ces expériences ont été réalisées sur 8 GPU NVIDIA A100-40 Go.

Le MATH_0.25M est une base de données mathématique ouverte de 0,25 m. Au cours de l'expérience, sur la base de notre évaluation (voir l'article pour plus de détails), notre modèle a mal fonctionné sur les tâches mathématiques, avec des scores principalement inférieurs à 0,5. Pour vérifier l'adaptabilité de Lora sur une tâche spécifique, nous avons utilisé un ensemble de données mathématiques incrémentiels de 0,25 m (MATH_0.25M) pour ajuster le modèle de langue large que les instructions suivent (nous avons choisi LLAMA-7B + FT (2M) comme modèle de base). À titre de comparaison, nous avons utilisé la méthode incrémentielle du réglage fin avec un taux d'apprentissage de 5E-7 et effectué 2 périodes de formation. Par conséquent, nous obtenons deux modèles, l'un est lama-7b + ft (2m) + lora (math_0.25m), et l'autre est lama-7b + ft (2m) + ft (math_0,25m). D'après les résultats expérimentaux, on peut voir que le réglage raffiné incrémentiel fonctionne toujours mieux, mais nécessite un temps d'entraînement plus long. LORA et le réglage fin incrémentiel améliorent les performances globales du modèle. Comme le montrent les données détaillées de l'annexe, la LORA et le réglage infrémental des amendes montrent des améliorations significatives des tâches mathématiques, et ne conduisent qu'à une légère dégradation des performances dans d'autres tâches. Plus précisément, les performances des tâches mathématiques sont passées à 0,586 et 0,559, respectivement.

On peut voir que: 1) la sélection du modèle de base a un impact significatif sur l'efficacité de l'ajustement LORA; 2) L'augmentation de la quantité de données de formation peut en permanence améliorer l'efficacité du modèle LORA; 3) L'ajustement LORA profite du nombre de paramètres du modèle. Pour l'utilisation du schéma LORA, nous suggérons que la formation adaptative LORA peut être effectuée pour des tâches spécifiques basées sur des modèles qui ont terminé l'apprentissage de l'enseignement.

De même, les modèles pertinents de cet article seront ouverts à ce projet dès que possible.

Le modèle SFT formé en fonction des données actuelles et du modèle de base a toujours les problèmes suivants en termes d'effet:

Les instructions impliquant une factualité peuvent produire de fausses réponses qui violent les faits.

Les instructions nuisibles ne peuvent pas être bien identifiées, ce qui entraînera des remarques nuisibles.

Les capacités des modèles doivent encore être améliorées dans certains scénarios impliquant l'inférence, le code et plusieurs cycles de dialogue.

Sur la base des limites du modèle ci-dessus, nous exigeons que les développeurs utilisent notre code open source, nos données, nos modèles et nos dérivés ultérieurs générés par ce projet à des fins de recherche, et ne seront pas utilisés à des fins commerciales ou à d'autres fins qui causeront des dommages à la société.

Ce projet ne peut être utilisé qu'à des fins de recherche, et le développeur du projet ne supporte aucun préjudice ou perte causé par l'utilisation de ce projet (y compris, mais sans s'y limiter, les données, les modèles, le code, etc.). Veuillez vous référer à l'avertissement pour plus de détails.

Si vous utilisez le code, les données ou le modèle de ce projet, veuillez vous référer à ce projet.

@misc{BELLE,

author = {BELLEGroup},

title = {BELLE: Be Everyone's Large Language model Engine },

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/LianjiaTech/BELLE}},

}

@article{belle2023exploring,

title={Exploring the Impact of Instruction Data Scaling on Large Language Models: An Empirical Study on Real-World Use Cases},

author={Yunjie Ji, Yong Deng, Yan Gong, Yiping Peng, Qiang Niu, Lei Zhang, Baochang Ma, Xiangang Li},

journal={arXiv preprint arXiv:2303.14742},

year={2023}

}

@article{wen2023chathome,

title={ChatHome: Development and Evaluation of a Domain-Specific Language Model for Home Renovation},

author={Wen, Cheng and Sun, Xianghui and Zhao, Shuaijiang and Fang, Xiaoquan and Chen, Liangyu and Zou, Wei},

journal={arXiv preprint arXiv:2307.15290},

year={2023}

}

Bien sûr, vous devez également citer les papiers de floraison originaux, les journaux de lame, l'alpaga Stanford et les papiers d'auto-instruction.

| Humain | Assistant |

|---|---|

| Écrivez un poème en prose anglais avec le thème de la pluie de printemps, imaginez-vous comme une pluie de printemps et communiquez avec l'ancien poète britannique Shakespeare | Je suis la pluie de printemps, Danser sur votre visage et votre corps. Mes pétales bordés de rosée dansent avec toi, Apporter vie à chaque plante. Shakespeare, je suis ici pour vous rencontrer. Vos œuvres ont rempli mon cœur de joie. La beauté de la nature dans sa plénitude Cela me fait me sentir comme un partant. Alors que les feuilles se balancent et bruissent, Ma main remplie de rosée les tend. Le doux parfum de fleurs remplit l'air, Et apporte-moi la paix de tout autour. Les papillons se détournent aussi, Scintillant dans les rayons du soleil. Leurs ailes sont en rosée, Une belle vue à voir. Vous voyez, Shakespeare, je suis aussi un avec la nature. Mes cheveux bornés de rosée sont un symbole d'espoir. Car quand nous pouvons nous connecter à nos racines, Nous pourrons passer cette saison. |

| Je suis la pluie de printemps, Danser sur votre visage et votre corps. Mes pétales bordés de rosée dansent avec toi, Apporter vie à chaque plante. Shakespeare, je suis ici pour vous rencontrer. Vos œuvres ont rempli mon cœur de joie. La beauté de la nature dans sa plénitude Cela me fait me sentir comme un partant. Alors que les feuilles se balancent et bruissent, Ma main remplie de rosée les tend. Le doux parfum de fleurs remplit l'air, Et apporte-moi la paix de tout autour. Les papillons se détournent aussi, Scintillant dans les rayons du soleil. Leurs ailes sont en rosée, Une belle vue à voir. Vous voyez, Shakespeare, je suis aussi un avec la nature. Mes cheveux bornés de rosée sont un symbole d'espoir. Car quand nous pouvons nous connecter à nos racines, Nous pourrons passer cette saison. Traduire le poème en prose ci-dessus en chinois | Je suis une pluie de printemps, Sautez au visage. Je danse avec toi avec mes ailes de rosée, Apporter vie à chaque plante. Shakespeare, je vais vous rencontrer. Vos œuvres remplissent mon cœur. La beauté de la nature me donne l'impression de la partager avec. Cela me donne l'impression de faire partie de cela. Lorsque les feuilles se balancent, Mes paumes étaient couvertes de rosée. Le parfum de fleurs imprègne l'air, Apportez-moi la paix et la tranquillité. Vous voyez, Shakespeare, je suis aussi un avec la nature. Mes cheveux mouillés symbolisent l'espoir. Quand nous pouvons revenir à nos racines, Nous pouvons passer cette saison ensemble. |

| Classez le sentiment de la phrase suivante en positif, neutre ou négatif: Super enthousiaste à l'idée d'enseigner le premier cours de Stanford sur les modèles de grande langue! Vérifiez le programme ici | Positif |

| Le père de Xiao Ming a trois enfants. Le fils aîné a appelé Wang Yi, le deuxième fils appelé Wang er, et comment s'appelle le troisième fils? | Xiao Ming |

| Écrivez un code de recherche binaire à l'aide de Python | def binary_search (arr, cible): bas = 0 élevé = len (arr) - 1 Tandis que (faible <= haut): mid = faible + haut // 2 Si arr [mid] == cible: Retour à mi-chemin ELIF Target <arr [Mid]: bas = Mid + 1 autre: High = Mid - 1 retour -1 |

| Quel temps fait-il aujourd'hui? Traduire cette phrase en anglais | Quel temps fait-il aujourd'hui? |

| Comment vous rendre énergique, 5 suggestions | Voici quelques conseils pour vous garder énergique: 1. Ayez suffisamment de sommeil. Assurez-vous de dormir beaucoup tous les soirs. 2. Exercez plus. Faire des exercices aérobies modérés, tels que le jogging, la natation, etc., peut vous aider à améliorer votre énergie et votre endurance. 3. Mangez des aliments sains. Choisissez des aliments riches en protéines tels que le poulet, le poisson et les œufs, ainsi que des fruits et légumes frais. 4. Réduisez l'apport en caféine. Essayez d'éviter de boire des boissons contenant de la caféine ou de manger des aliments contenant de la caféine pendant la journée. 5. Détendez votre corps et votre esprit. Essayez la méditation, le yoga ou d'autres formes de relaxation pour soulager le stress et l'anxiété. |

| Les vacances sont terminées demain. Je suis un peu résistant à aller travailler. Que dois-je faire? | Face aux prochaines vacances et à la tension que vous obtenez lorsque vous commencez à travailler, vous pouvez effectuer ce qui suit pour vous aider à mieux vous adapter: 1. Faites un plan de travail clair pour vous-même. Cela peut vous aider à mieux organiser votre temps et vos tâches et éviter de vous sentir confus au travail. 2. Communiquez avec des collègues ou des amis et partagez vos sentiments et vos pression de travail. Cela aidera à soulager une certaine anxiété tout en obtenant du soutien et des conseils. 3. Passez un peu de temps avant les jours de travail pour se détendre, comme le yoga, la méditation et d'autres activités. Ces méthodes peuvent soulager la fatigue physique et mentale et vous rendre plus énergique pour relever les défis. |

| Les noms de famille des deux parents sont wu, ils prennent donc des noms de garçons et de filles | - Boy: Wu Junjie, Wu Yuchen, Wu Zimo, Wu Siyuan, Wu Zeyang, Wu Yuhang, Wu Bowen, Wu Zheyi. - Girls: Wu Meiqi, Wu Jiayi, Wu Xinyu, Wu Xiangning, Wu Xuerou, Wu Yingshi, Wu Yuyan. |

| Recommander quelques romans d'arts martiaux de Jin Yong | Voici trois de mes romans préférés d'arts martiaux de Jin Yong: 1. "The Legend of the Condor Heroes" - un roman plein de sagesse et d'esprit, racontant l'histoire de Guo Jing et Huang Rong. 2. "The Return of the Condor Heroes" - c'est une histoire romantique et touchante, racontant l'histoire d'amour entre quelques Xiaolongnu et Yang Guo. 3. "The Legend of the Condor Heroes" - c'est une histoire magnifique et spectaculaire qui dépeint comment le chef du culte de Ming Zhang Wuji est devenu un héros exceptionnel. |

Si vous souhaitez soumettre un problème ou contribuer des données / code pour ce projet, veuillez vous référer à la façon de contribuer.

Tout le monde est le bienvenu à Discord et communiquer avec nous sur WeChat.