ベル:みんなの大手言語モデルエンジンになります

ベル:みんなの大手言語モデルエンジンになりますこれを英語で読んでください。

このプロジェクトの目標は、中国の対話ビッグモデルのオープンソースコミュニティの開発を促進することであり、ビジョンはすべての人を助けることができるLLMエンジンになることです。

大規模な言語モデルを事前に訓練する方法と比較して、ベルは、オープンソースの大規模な言語モデルに基づいて、可能な限り最高の効果と指導のパフォーマンス機能を備えた、すべての人が独自の言語モデルを取得するのを支援する方法に焦点を当て、大規模な言語モデル、特に中国語の大規模な言語モデルの研究とアプリケーションのしきい値を減らします。この目的のために、Belleプロジェクトは、命令トレーニングデータ、関連モデル、トレーニングコード、アプリケーションシナリオなどを引き続き開き、モデルのパフォーマンスに対するさまざまなトレーニングデータ、トレーニングアルゴリズムなどの影響を引き続き評価します。 Belleは中国語用に最適化されており、モデルチューニングではChatGPTによって生成されたデータのみを使用します(他のデータなし)。

次の図は、アプリを使用してデバイス側で局所的にQuantized化され、M1 Max CPUでリアルタイムで実行できるBelle-7Bモデルです(加速していません)。アプリのダウンロードの詳細については、モデルのダウンロードをサポートするアプリと使用の手順を参照してください。アプリのダウンロードリンクは現在、Mac OSバージョンでのみ利用可能です。モデルは個別にダウンロードする必要があります。モデルが定量化された後、効果損失は明らかであり、それを改善する方法を研究し続けます。

詳細については、可能な限り簡素化され、Deepspeed-Chatを統合し、FinetuneとLoraをサポートし、関連するドッカーズを提供するトレーニングコードの実装については、Belle/Trainを参照してください。

詳細については、Belle/Data/1.5mを参照してください。StanfordAlpaca1m + 0.5mによって生成された中国のデータセットを参照してください。

継続的に開いているデータセットは、詳細についてはBelle/Data/10Mを参照してください。

詳細については、Belle/Eval、1K+テストセット、および対応するスコアリングプロンプトを参照してください。複数のカテゴリが含まれており、GPT-4またはChatGPTを使用してスコアを付けます。また、単一のケースで簡単に使用できるスコアリングWebページも提供します。誰もがPRを通じてより多くのテストケースを提供することを歓迎します。

詳細については、Belle/Modelsを参照してください

Meta llama2に基づくチューニングのモデル:belle-llama2-13b-chat-0.4m

メタラマに基づいてチューニングを実装するモデル:Belle-llama-7B-0.6M-Enc、Belle-llama-7B-2m-enc、Belle-llama-7b-2m-gptq-enc、belle-llama-13b-2m-enc、belle-on-open-datasets、およびpre-trained model bella-lama-ext-7b、absed absed bes bes bes absed extin 語彙。

Bloomz-7B1-MTに基づいて最適化されたモデル:Belle-7B-0.2M、Belle-7B-0.6M、Belle-7B-1M、Belle-7B-2M

詳細については、Belle/GPTQを参照してください。 GPTQの実装を参照して、このプロジェクトの関連モデルを定量化してください。

colab上の実行可能な推論コードコラブを提供します

詳細については、Belleモデルに基づくクロスプラットフォームオフラインの大規模な言語モデルチャットアプリであるBelle/Chatを参照してください。 Flutterを使用した量子化されたオフラインモデルを使用すると、MacOS(サポート)、Windows、Android、iOS、その他のデバイスで実行できます。

詳細については、Belle/Docsを参照してください。このプロジェクトに関連する調査レポートを定期的に更新します。

問題を通じてより多くのプロップを提供することを歓迎します!

オープンソースの大規模な言語モデルの開発を促進するために、ChatGPTに似た低コストモデルを開発するために多くのエネルギーを投資しました。第一に、中国の分野におけるモデルのパフォーマンスとトレーニング/推論の効率を改善するために、ラマの語彙をさらに拡大し、34億の中国の語彙で二次訓練を行いました。

さらに、ChatGPTに基づいて生成された訓練されたデータは次のとおりであることがわかります。1)ALPACAによってGPT3.5に基づいて得られた自己インストラクションデータを参照してください。 2)ALPACAによるGPT4に基づいて得られた自己計算データを参照してください。 3)chatgptを使用してユーザーが共有する共有データ。ここでは、モデルのパフォーマンスに対するトレーニングデータカテゴリの影響を調査することに焦点を当てています。具体的には、トレーニングデータの量、品質、言語分布などの要因、および自分で収集した中国のマルチラウンドダイアログデータ、および公開された高品質のガイダンスデータセットを調べます。

効果をより適切に評価するために、1,000のサンプルと9つの実際のシナリオの評価セットを使用して、さまざまなモデルをテストし、定量分析を通じて貴重な洞察を提供して、オープンソースチャットモデルの開発をよりよく促進しました。

この研究の目標は、この分野での継続的な進歩を強くサポートするために、オープンソースチャットモデルの包括的な評価のギャップを埋めることです。

実験結果は次のとおりです。

| 要素 | ベースモデル | トレーニングデータ | score_w/o_others |

| 語彙拡張 | llama-7b-ext | Zh(alpaca-3.5&4) + sharegpt | 0.670 |

| llama-7b | Zh(alpaca-3.5&4) + sharegpt | 0.652 | |

| データ品質 | llama-7b-ext | Zh(alpaca-3.5) | 0.642 |

| llama-7b-ext | Zh(alpaca-4) | 0.693 | |

| データ言語分布 | llama-7b-ext | Zh(alpaca-3.5&4) | 0.679 |

| llama-7b-ext | en(alpaca-3.5&4) | 0.659 | |

| llama-7b-ext | Zh(alpaca-3.5&4) + sharegpt | 0.670 | |

| llama-7b-ext | en(alpaca-3.5&4) + sharegpt | 0.668 | |

| データスケール | llama-7b-ext | Zh(alpaca-3.5&4) + sharegpt | 0.670 |

| llama-7b-ext | Zh(alpaca-3.5&4) + sharegpt +ベル-0.5mクリーン | 0.762 | |

| - | chatgpt | - | 0.824 |

その中で、 Belle-0.5mクリーンは、以前に開かれた0.5mデータと同じデータのバッチではない、単一ラウンドおよび複数ラウンドのダイアログデータを含む230万の命令データから0.5mのデータをクリーニングします。

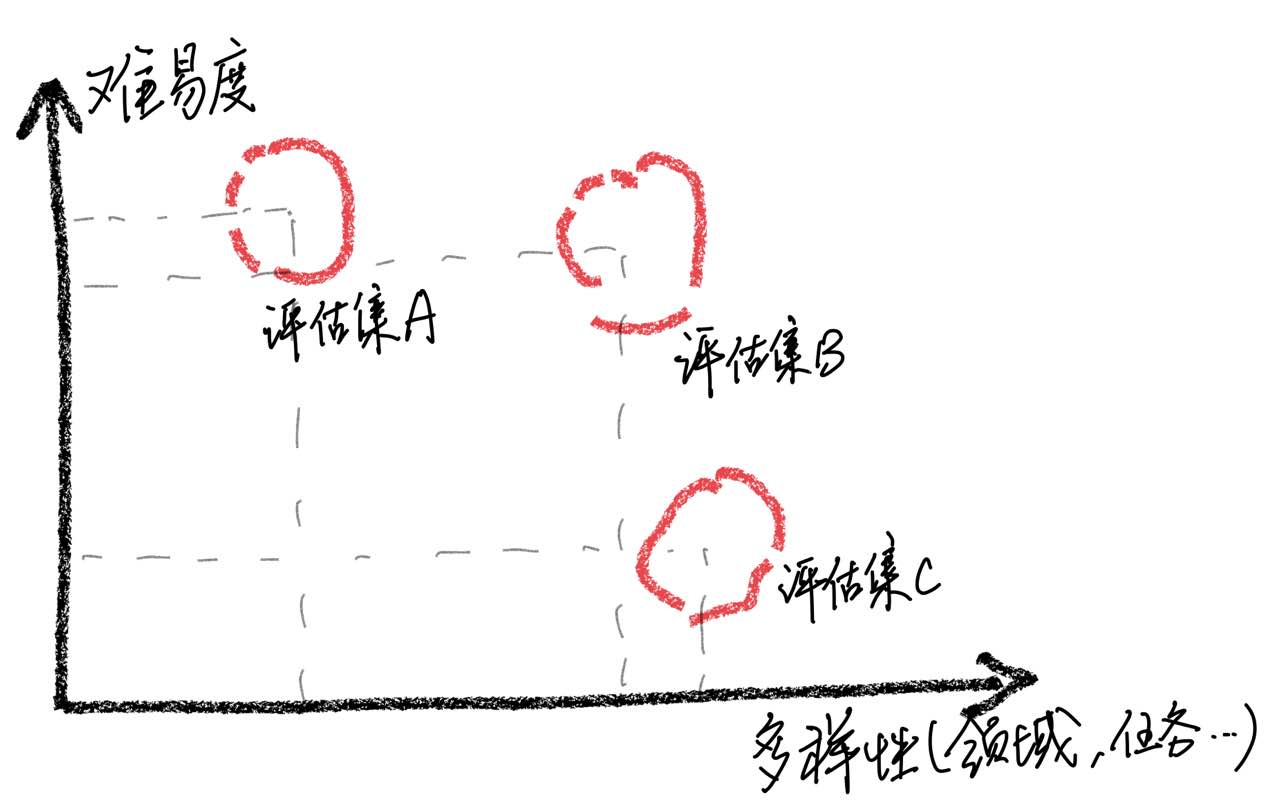

ケース分析を通じて、評価セットには包括性の点で制限があり、モデルスコアの改善と実際のユーザーエクスペリエンスの間の不一致につながることが強調されるべきです。高品質の評価セットを構築することは、バランスの取れた難易度を維持しながら、できるだけ多くの使用シナリオを必要とするため、大きな課題です。サンプルの評価がほとんど難しすぎる場合、すべてのモデルのパフォーマンスが低下し、さまざまなトレーニング戦略の効果を特定するのが難しくなります。それどころか、すべてのサンプルが比較的簡単に評価された場合、評価はその比較値を失います。さらに、評価データがトレーニングデータから独立したままであることを確認する必要があります。

これらの観察に基づいて、限られた数のテストサンプルで良い結果を得るだけで、モデルがChatGPTに匹敵するパフォーマンスレベルを達成したと仮定することに注意してください。包括的な評価セットの開発を優先することは非常に重要であると考えています。

リソースとコストにより、大規模な言語モデルの指導チューニングを達成するために、多くの研究者は、LORAなどのパラメーター効率の高いチューニング技術を使用して、いくつかの有望な結果を達成した指導チューニングを実行し始めました。フルパラメーターの微調整と比較して、LORAベースのチューニングは、トレーニングコストの明らかな利点を示しています。この研究レポートでは、Llamaを基本モデルとして使用して、フルパラメーターの微調整とLORAベースのチューニング方法を実験的に比較しました。

実験結果は、適切な基本モデルの選択、トレーニングデータセットのスケール、学習可能なパラメーターの数、モデルトレーニングのコストがすべて重要な要因であることを明らかにしています。

この論文の実験的結論が、特に中国の分野での大規模な言語モデルのトレーニングに有用な意味を提供し、研究者がトレーニングコストとモデルのパフォーマンスの間のより良いトレードオフを見つけるのを支援できることを願っています。実験結果は次のとおりです。

| モデル | 平均スコア | 追加のパラメーション。 | トレーニング時間(時間/エポック) |

|---|---|---|---|

| llama-13b + lora(2m) | 0.648 | 28m | 8 |

| llama-7b + lora(4m) | 0.624 | 17.9m | 11 |

| llama-7b + lora(2m) | 0.609 | 17.9m | 7 |

| llama-7b + lora(0.6m) | 0.589 | 17.9m | 5 |

| llama-7b + ft(2m) | 0.710 | - | 31 |

| llama-7b + lora(4m) | 0.686 | - | 17 |

| llama-7b + ft(2m) + lora(math_0.25m) | 0.729 | 17.9m | 3 |

| llama-7b + ft(2m) + ft(math_0.25m) | 0.738 | - | 6 |

スコアは、このプロジェクトセットで現在開いている1,000の評価セットに基づいて取得されます。

その中で、Llama-13B + Lora(2M)は、Llama-13Bを基本モデルとして使用し、LORAトレーニング方法として2Mの指導データをトレーニングするモデルを表しています。 llama-7b + ft(2m)は、完全なパラメーターの微調整を使用して訓練されたモデルを表します。

llama-7b + ft(2m) + lora(math_0.25m)は、Llama-7b + ft(2m)を基本モデルとして使用し、0.25mの数学指導データでトレーニングするためにLORAトレーニング方法を使用するモデルを表します。 llama-7b + ft(2m) + ft(math_0.25m)は、増分完全パラメーターの微調整を使用して訓練されたモデルを表します。トレーニング時間に関して、これらのすべての実験は、8 NVIDIA A100-40GB GPUで行われました。

Math_0.25mは、0.25mのオープン数学データベースです。実験中、評価に基づいて(詳細については論文を参照)、私たちのモデルは数学的タスクでは性能が低く、スコアはほとんど0.5未満でした。特定のタスクでLORAの適応性を検証するために、インクリメンタル0.25m数学データセット(MATH_0.25M)を使用して、命令が続く大きな言語モデルを調整しました(Llama-7B+FT(2M)を基本モデルとして選択しました)。比較のために、5E-7の学習率で増分微調整法を使用し、2つの期間のトレーニングを実施しました。したがって、2つのモデルを取得します。1つはllama-7b+ft(2m)+lora(math_0.25m)、もう1つはllama-7b+ft(2m)+ft(math_0.25m)です。実験結果から、増分微調整は依然として優れたパフォーマンスを発揮しますが、より長いトレーニング時間が必要であることがわかります。ロラと増分の両方の微調整は、モデルの全体的なパフォーマンスを改善します。付録の詳細なデータからわかるように、LORAと漸進的な微調整の両方が数学的タスクの大幅な改善を示し、他のタスクのわずかなパフォーマンスの劣化にのみつながります。具体的には、数学的タスクのパフォーマンスはそれぞれ0.586と0.559に増加しました。

次のことがわかります。1)基本モデルを選択すると、LORA調整の有効性に大きな影響があります。 2)トレーニングデータの量を増やすと、LORAモデルの有効性が継続的に向上する可能性があります。 3)LORA調整は、モデルパラメーターの数からの利点があります。 LORAスキームを使用するために、LORA適応トレーニングを、指導学習を完了したモデルに基づいて特定のタスクに対して実行できることをお勧めします。

同様に、このペーパーの関連モデルは、できるだけ早くこのプロジェクトに開かれます。

現在のデータと基本モデルに基づいてトレーニングされたSFTモデルには、効果の観点から次の問題があります。

事実を含む指示は、事実に違反する誤った答えを生み出す可能性があります。

有害な指示は十分に特定できないため、有害な発言につながります。

モデルの機能は、推論、コード、および複数のダイアログラウンドを含むいくつかのシナリオで改善する必要があります。

上記のモデルの制限に基づいて、開発者は、研究目的でこのプロジェクトによって生成されたオープンソースコード、データ、モデル、およびその後のデリバティブのみを使用することのみを要求し、社会に害を及ぼす商業目的またはその他の目的に使用してはなりません。

このプロジェクトは研究目的でのみ使用でき、プロジェクト開発者はこのプロジェクトの使用によって引き起こされる害や損失を負いません(データ、モデル、コードなどを含むがこれらに限定されません)。詳細については、免責事項を参照してください。

このプロジェクトのコード、データ、またはモデルを使用する場合は、このプロジェクトを参照してください。

@misc{BELLE,

author = {BELLEGroup},

title = {BELLE: Be Everyone's Large Language model Engine },

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/LianjiaTech/BELLE}},

}

@article{belle2023exploring,

title={Exploring the Impact of Instruction Data Scaling on Large Language Models: An Empirical Study on Real-World Use Cases},

author={Yunjie Ji, Yong Deng, Yan Gong, Yiping Peng, Qiang Niu, Lei Zhang, Baochang Ma, Xiangang Li},

journal={arXiv preprint arXiv:2303.14742},

year={2023}

}

@article{wen2023chathome,

title={ChatHome: Development and Evaluation of a Domain-Specific Language Model for Home Renovation},

author={Wen, Cheng and Sun, Xianghui and Zhao, Shuaijiang and Fang, Xiaoquan and Chen, Liangyu and Zou, Wei},

journal={arXiv preprint arXiv:2307.15290},

year={2023}

}

もちろん、オリジナルのブルームペーパー、ラマペーパー、スタンフォードアルパカ、自己インストラクションペーパーも引用する必要があります。

| 人間 | アシスタント |

|---|---|

| 春の雨をテーマにした英語の散文詩を書いて、自分を春の雨として想像して、古代のイギリスの詩人シェークスピアとコミュニケーションをとる | 私は春の雨です、 あなたの顔と体で踊る。 私の露にかぶった花びらはあなたと踊ります、 すべての植物に命を吹き込みます。 シェークスピア、私はあなたに会うためにここにいます。 あなたの作品は私の心を喜びで満たしました。 その膨満感における自然の美しさ 私はパートカーのように感じさせます。 葉が揺れたりざわめたりすると、 私の露に満ちた手は彼らのために手を伸ばします。 花の甘い香りが空気を満たします、 そして、周りから平和をもたらします。 蝶も飛び回る、 太陽の光線で輝く。 彼らの翼は露でできています、 見るべき美しい光景。 ご存知のように、シェークスピア、私も自然と一体です。 私の露にかかった髪は希望の象徴です。 私たちが私たちのルーツに戻ることができるときのために、 今シーズンを通してそれを成し遂げることができます。 |

| 私は春の雨です、 あなたの顔と体で踊る。 私の露にかぶった花びらはあなたと踊ります、 すべての植物に命を吹き込みます。 シェークスピア、私はあなたに会うためにここにいます。 あなたの作品は私の心を喜びで満たしました。 その膨満感における自然の美しさ 私はパートカーのように感じさせます。 葉が揺れたりざわめたりすると、 私の露に満ちた手は彼らのために手を伸ばします。 花の甘い香りが空気を満たします、 そして、周りから平和をもたらします。 蝶も飛び回る、 太陽の光線で輝く。 彼らの翼は露でできています、 見るべき美しい光景。 ご存知のように、シェークスピア、私も自然と一体です。 私の露にかかった髪は希望の象徴です。 私たちが私たちのルーツに戻ることができるときのために、 今シーズンを通してそれを成し遂げることができます。 上記の散文詩を中国語に翻訳します | 私は春の雨です、 あなたの顔にジャンプします。 私は露の翼であなたと一緒に踊ります、 すべての植物に命を吹き込みます。 シェークスピア、私はあなたに会います。 あなたの作品は私の心を満たします。 自然の美しさは、それを共有するように感じます。 それは私がその一部であるように感じさせます。 葉が揺れたとき、 私の手のひらは露で覆われていました。 花の香りが空気に浸透します、 私に平和と静けさをもたらします。 ご存知のように、シェークスピア、私も自然と一体です。 私の濡れた髪は希望を象徴しています。 ルーツに戻ることができるとき、 今シーズンを一緒に過ごすことができます。 |

| 次の文の感情を肯定的、中立、または否定に分類します。 大規模な言語モデルに関するスタンフォードの最初のコースを教えることに非常に興奮しています!ここでシラバスを確認してください | ポジティブ |

| Xiao Mingの父親には3人の子供がいます。長男は王イーと呼ばれ、次男は王と呼ばれ、三番目の息子は何と呼ばれていますか? | シャオミン |

| Pythonを使用してバイナリ検索コードを作成します | def binary_search(arr、ターゲット): 低= 0 high = len(arr)-1 while(low <= high): Mid = Low + High // 2 arr [mid] ==ターゲットの場合: 途中で戻ります Elif Target <arr [Mid]: LOW = MID + 1 それ以外: high = mid -1 -1を返します |

| 今日の天気はいかがですか?この文を英語に翻訳します | 今日の天気はどうですか? |

| 自分自身をエネルギッシュにする方法、5つの提案 | ここにあなたをエネルギッシュに保つためのいくつかのヒントがあります: 1。十分な睡眠をとってください。毎晩十分な睡眠をとることを確認してください。 2。もっとエクササイズします。ジョギング、水泳など、中程度の有酸素運動を行うことで、エネルギーと持久力を改善するのに役立ちます。 3。健康的な食べ物を食べる。鶏肉、魚、卵、新鮮な果物や野菜などのタンパク質が豊富な食品を選択してください。 4.カフェイン摂取量を減らします。日中はカフェインを含む飲み物を飲んだり、カフェインを含む食品を食べたりしないようにしてください。 5.体と心をリラックスさせてください。ストレスや不安を和らげるために、瞑想、ヨガ、または他の形のリラクゼーションを試してください。 |

| 休日は明日です。私は仕事に行くことに少し抵抗力があります。どうすればいいですか? | あなたの休日の終わりとあなたが働き始めるときにあなたが得る緊張に直面して、あなたはあなたがより良く適応するのを助けるために以下を行うことができます: 1.自分のために明確な作業計画を立ててください。これは、時間とタスクをよりよく整理し、職場で混乱していると感じることを避けるのに役立ちます。 2。同僚や友人とコミュニケーションを取り、あなたの感情と仕事のプレッシャーを共有します。これは、サポートとアドバイスを得る一方で、不安を和らげるのに役立ちます。 3。ヨガ、瞑想、その他の活動など、リラックスするために仕事の前に時間を過ごします。これらの方法は、身体的および精神的な疲労を緩和し、課題を満たすためによりエネルギッシュになります。 |

| 両親の姓はwuなので、男の子と女の子の名前を取ります | - 少年:ウジュジー、ウー・ユチェン、ウー・ジモ、ウー・シユアン、ウー・ザヤン、ウー・ユハン、ウー・ボーエン、ウー・ジエイ。 - 女の子:Wu Meiqi、Wu Jiayi、Wu Xinyu、Wu Xiangning、Wu Xuerou、Wu Yingshi、Wu Yuyan。 |

| ジン・ヨンの武道小説をお勧めします | 私のお気に入りのジンヨンの武道小説の3つは次のとおりです。 1。「コンドルヒーローズの伝説」 - 知恵と機知に満ちた小説で、グオジンとファンロンの物語を語っています。 2。「コンドルのヒーローの復活」 - これはロマンチックで感動的な物語であり、カップルのXiaolongnuとYang Guoの間でラブストーリーを語っています。 3。「コンドルヒーローズの伝説」 - これは、明のカルトチャンウジのリーダーが傑出したヒーローになった方法を描いた壮大で壮大な物語です。 |

このプロジェクトの問題を提出したり、データ/コードを貢献したりする場合は、貢献方法を参照してください。

誰もがwechatで私たちとコミュニケーションをとることを誰もが歓迎します。