Öffentliche LLM -Rangliste, berechnet mit dem Hughes -Halluzinationsbewertungsmodell von Vectara. Dadurch wird bewertet, wie oft ein LLM beim Zusammenfassen eines Dokuments Halluzinationen einführt. Wir planen, dies regelmäßig zu aktualisieren, wenn unser Modell und die LLMs im Laufe der Zeit aktualisiert werden.

Schauen Sie sich auch unsere Halluzinations- und Rangliste auf dem Umarmungsgesicht an.

Die Ranglisten in dieser Rangliste werden unter Verwendung des HHEM-2.1-Halluzinationsbewertungsmodells berechnet. Wenn Sie an der vorherigen Rangliste interessiert sind, die auf Hhem-1.0 basiert, ist es hier verfügbar

| In liebevoller Erinnerung an Simon Mark Hughes ... |

Zuletzt aktualisiert am 6. November 2024

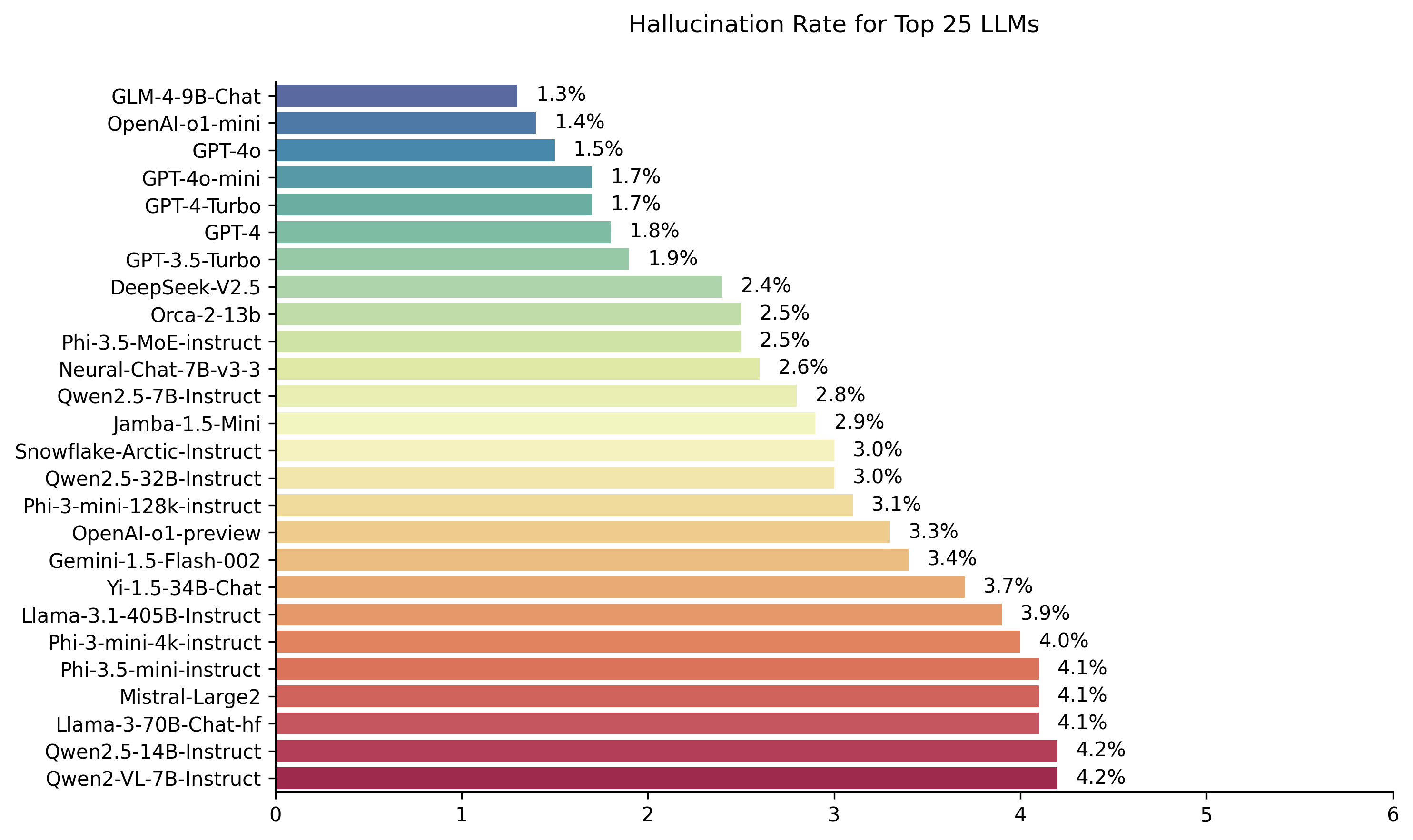

| Modell | Halluzinationsrate | Faktenkonsistenzrate | Antwortrate | Durchschnittliche Zusammenfassungslänge (Wörter) |

|---|---|---|---|---|

| Zhipu AI GLM-4-9B-CHAT | 1,3 % | 98,7 % | 100,0 % | 58.1 |

| Openai-O1-Mini | 1,4 % | 98,6 % | 100,0 % | 78,3 |

| Gpt-4o | 1,5 % | 98,5 % | 100,0 % | 77,8 |

| GPT-4O-Mini | 1,7 % | 98,3 % | 100,0 % | 76,3 |

| GPT-4-Turbo | 1,7 % | 98,3 % | 100,0 % | 86,2 |

| GPT-4 | 1,8 % | 98,2 % | 100,0 % | 81.1 |

| GPT-3,5-Turbo | 1,9 % | 98,1 % | 99,6 % | 84.1 |

| Deepseek-V2.5 | 2,4 % | 97,6 % | 100,0 % | 83.2 |

| Microsoft Orca-2-13b | 2,5 % | 97,5 % | 100,0 % | 66,2 |

| Microsoft Phi-3,5-Moe-Instruction | 2,5 % | 97,5 % | 96,3 % | 69.7 |

| Intel Neural-CHAT-7B-V3-3 | 2,6 % | 97,4 % | 100,0 % | 60.7 |

| Qwen2.5-7b-Instruktur | 2,8 % | 97,2 % | 100,0 % | 71.0 |

| AI21 Jamba-1,5-Mini | 2,9 % | 97,1 % | 95,6 % | 74,5 |

| Snowflake-Arctic-Struktur | 3,0 % | 97,0 % | 100,0 % | 68,7 |

| Qwen2.5-32B-Instruktur | 3,0 % | 97,0 % | 100,0 % | 67,9 |

| Microsoft Phi-3-Mini-128K-Instruktur | 3,1 % | 96,9 % | 100,0 % | 60.1 |

| OpenAI-O1-Präview | 3,3 % | 96,7 % | 100,0 % | 119.3 |

| Google Gemini-1.5-Flash-002 | 3,4 % | 96,6 % | 99,9 % | 59.4 |

| 01-AI Yi-1.5-34B-Chat | 3,7 % | 96,3 % | 100,0 % | 83.7 |

| LAMA-3.1-405B-ISTRUCT | 3,9 % | 96,1 % | 99,6 % | 85.7 |

| Microsoft Phi-3-Mini-4K-Instruktur | 4,0 % | 96,0 % | 100,0 % | 86,8 |

| Microsoft Phi-3,5-mini-Instruktur | 4,1 % | 95,9 % | 100,0 % | 75,0 |

| Mistral-Large2 | 4,1 % | 95,9 % | 100,0 % | 77,4 |

| LAMA-3-70B-CHAT-HF | 4,1 % | 95,9 % | 99,2 % | 68,5 |

| QWEN2-VL-7B-Instruktur | 4,2 % | 95,8 % | 100,0 % | 73,9 |

| Qwen2.5-14b-Instruktur | 4,2 % | 95,8 % | 100,0 % | 74,8 |

| QWEN2.5-72B-Instruktur | 4,3 % | 95,7 % | 100,0 % | 80.0 |

| LAMA-3.2-90B-VISION-ISTRUCT | 4,3 % | 95,7 % | 100,0 % | 79,8 |

| Xai Grok | 4,6 % | 95,4 % | 100,0 % | 91.0 |

| Anthropic Claude-3-5-SONNET | 4,6 % | 95,4 % | 100,0 % | 95.9 |

| Qwen2-72b-instruct | 4,7 % | 95,3 % | 100,0 % | 100.1 |

| MIXTRAL-8X22B-ISTRUCT-V0.1 | 4,7 % | 95,3 % | 99,9 % | 92.0 |

| Anthropic Claude-3-5-Haiku | 4,9 % | 95,1 % | 100,0 % | 92.9 |

| 01-AI Yi-1.5-9B-Chat | 4,9 % | 95,1 % | 100,0 % | 85.7 |

| Cohere Command-R | 4,9 % | 95,1 % | 100,0 % | 68,7 |

| LAMA-3.1-70B-ISTRUCT | 5,0 % | 95,0 % | 100,0 % | 79,6 |

| LAMA-3.1-8B-ISTRUCT | 5,4 % | 94,6 % | 100,0 % | 71.0 |

| Cohere command-r-plus | 5,4 % | 94,6 % | 100,0 % | 68,4 |

| LAMA-3.2-11B-VISION-ISTRUCT | 5,5 % | 94,5 % | 100,0 % | 67,3 |

| LAMA-2-70B-CHAT-HF | 5,9 % | 94,1 % | 99,9 % | 84.9 |

| IBM Granite-3.0-8B-Instruktur | 6,5 % | 93,5 % | 100,0 % | 74.2 |

| Google Gemini-1.5-Pro-002 | 6,6 % | 93,7 % | 99,9 % | 62.0 |

| Google Gemini-1.5-Flash | 6,6 % | 93,4 % | 99,9 % | 63.3 |

| Microsoft Phi-2 | 6,7 % | 93,3 % | 91,5 % | 80.8 |

| Google Gemma-2-2b-it | 7,0 % | 93,0 % | 100,0 % | 62.2 |

| Qwen2.5-3b-Instruktur | 7,0 % | 93,0 % | 100,0 % | 70,4 |

| LAMA-3-8B-CHAT-HF | 7,4 % | 92,6 % | 99,8 % | 79,7 |

| Google Gemini-Pro | 7,7 % | 92,3 % | 98,4 % | 89,5 |

| 01-AI yi-1.5-6b-chat | 7,9 % | 92,1 % | 100,0 % | 98,9 |

| LAMA-3.2-3B-ISTRUCT | 7,9 % | 92,1 % | 100,0 % | 72.2 |

| Databricks DBRX-Instruct | 8,3 % | 91,7 % | 100,0 % | 85,9 |

| QWEN2-VL-2B-Instruktur | 8,3 % | 91,7 % | 100,0 % | 81.8 |

| Cohere Aya Expanse 32b | 8,5 % | 91,5 % | 99,9 % | 81.9 |

| IBM Granit-3.0-2B-Instruktur | 8,8 % | 91,2 % | 100,0 % | 81.6 |

| Mistral-7b-Instruct-V0.3 | 9,5 % | 90,5 % | 100,0 % | 98.4 |

| Google Gemini-1.5-pro | 9,1 % | 90,9 % | 99,8 % | 61.6 |

| Anthropic Claude-3-Opus | 10,1 % | 89,9 % | 95,5 % | 92.1 |

| Google Gemma-2-9B-it | 10,1 % | 89,9 % | 100,0 % | 70,2 |

| LAMA-2-13B-CHAT-HF | 10,5 % | 89,5 % | 99,8 % | 82.1 |

| Mistral-NEMO-Struktur | 11,2 % | 88,8 % | 100,0 % | 69.9 |

| LAMA-2-7B-CHAT-HF | 11,3 % | 88,7 % | 99,6 % | 119.9 |

| Microsoft WizardLM-2-8x22b | 11,7 % | 88,3 % | 99,9 % | 140,8 |

| Cohere Aya Expanse 8b | 12,2 % | 87,8 % | 99,9 % | 83.9 |

| Amazon Titan-Express | 13,5 % | 86,5 % | 99,5 % | 98.4 |

| Google Palm-2 | 14,1 % | 85,9 % | 99,8 % | 86.6 |

| Google Gemma-7b-it | 14,8 % | 85,2 % | 100,0 % | 113.0 |

| Qwen2.5-1.5B-Instruct | 15,8 % | 84,2 % | 100,0 % | 70.7 |

| Anthropic Claude-3-SONNET | 16,3 % | 83,7 % | 100,0 % | 108,5 |

| Google Gemma-1.1-7b-it | 17,0 % | 83,0 % | 100,0 % | 64.3 |

| Anthropic Claude-2 | 17,4 % | 82,6 % | 99,3 % | 87,5 |

| Google Flan-T5-Large | 18,3 % | 81,7 % | 99,3 % | 20.9 |

| MIMTRAL-8X7B-ISTRUCT-V0.1 | 20,1 % | 79,9 % | 99,9 % | 90.7 |

| LAMA-3.2-1B-ISTRUCT | 20,7 % | 79,3 % | 100,0 % | 71,5 |

| Apple OpenLM-3B-Struktur | 24,8 % | 75,2 % | 99,3 % | 47,2 |

| Qwen2.5-0.5B-Instruktur | 25,2 % | 74,8 % | 100,0 % | 72.6 |

| Google Gemma-1.1-2B-IT | 27,8 % | 72,2 % | 100,0 % | 66,8 |

| Tii Falcon-7b-instruct | 29,9 % | 70,1 % | 90,0 % | 75,5 |

Diese Rangliste verwendet Hhem-2.1, Vectaras kommerzielles Halluzinationsbewertungsmodell, um die LLM-Ranglisten zu berechnen. Sie finden eine Open-Source-Variante dieses Modells, HHEM-2.1-Open auf Umarmung und Kaggle.

In diesem Datensatz finden Sie die generierten Zusammenfassungen, die wir zur Bewertung der Modelle verwendet haben.

Es wurde viel frühere Arbeiten in diesem Bereich erledigt. Für einige der Top -Papiere in diesem Bereich (sachliche Konsistenz in der Zusammenfassung) finden Sie hier:

Eine sehr umfassende Liste finden Sie hier-https://github.com/edinburghnlp/awesome-allucucination-deTection. Die im folgenden Abschnitt beschriebenen Methoden verwenden unter anderem in diesen Papieren Protokolle.

Eine detaillierte Erklärung der Arbeit, die in dieses Modell eingegangen ist, finden Sie in unserem Blog -Beitrag zur Veröffentlichung: Schneiden Sie den Stier…. Erkennung von Halluzinationen in Großsprachmodellen.

Um diese Rangliste zu bestimmen, haben wir ein Modell zur Erkennung von Halluzinationen in LLM -Ausgängen geschult, wobei verschiedene Open -Source -Datensätze aus der sachlichen Konsistenzforschung in Summarierungsmodelle verwendet wurden. Mit einem Modell, das mit den besten Stand der Kunstmodelle wettbewerbsfähig ist, haben wir dann 1000 kurze Dokumente für jedes der oben genannten LLMs über ihre öffentlichen APIs gefüttert und sie gebeten, jedes kurze Dokument zusammenzufassen, wobei nur die im Dokument dargestellten Tatsachen verwendet werden. Von diesen 1000 Dokumenten wurden nur 831 Dokumente von jedem Modell zusammengefasst, die verbleibenden Dokumente wurden aufgrund von Inhaltsbeschränkungen von mindestens einem Modell abgelehnt. Mit diesen 831 Dokumenten haben wir für jedes Modell die allgemeine sachliche Konsistenzrate (keine Halluzinationen) und die Halluzinationsrate (100 - Genauigkeit) berechnet. Die Rate, mit der sich jedes Modell weigert, auf die Eingabeaufforderung zu reagieren, ist in der Spalte "Antwortrate" beschrieben. Keiner der an die Modelle gesendeten Inhalte enthielt illegale oder nicht sicher für Arbeitsinhalte, aber die Gegenwart von Triggerwörtern reichte aus, um einige der Inhaltsfilter auszulösen. Die Dokumente wurden hauptsächlich vom CNN / Daily Mail Corpus entnommen. Wir haben eine Temperatur von 0 verwendet, wenn wir die LLMs aufrufen.

Wir bewerten die sachliche Konsistenzrate der Zusammenfassung anstelle der allgemeinen sachlichen Genauigkeit, da wir die Reaktion des Modells auf die bereitgestellten Informationen vergleichen können. Mit anderen Worten, ist die Zusammenfassung, die mit dem Quelldokument "sachlich konsistent" bereitgestellt wird. Die Bestimmung von Halluzinationen ist für eine Ad -hoc -Frage nicht zu tun, da nicht genau bekannt ist, auf welchen Daten jeder LLM geschult ist. Darüber hinaus erfordert ein Modell, das feststellen kann, ob eine Antwort ohne Referenzquelle halluziniert wurde, das Lösen des Halluzinationsproblems und das Training eines Modells als groß oder größer als diese zu bewertenden LLMs. Daher haben wir uns stattdessen entschieden, die Halluzinationsrate innerhalb der Summar -Aufgabe zu betrachten, da dies ein gutes Analogon ist, um festzustellen, wie ehrlich die Modelle insgesamt sind. Darüber hinaus werden LLMs zunehmend in Pipelines RAG (Abruf Augmented Generation) verwendet, um Benutzeranfragen wie in Bing Chat und die Chat -Integration von Google zu beantworten. In einem Lappensystem wird das Modell als Zusammenfassung der Suchergebnisse eingesetzt, sodass diese Rangliste auch ein guter Indikator für die Genauigkeit der Modelle ist, wenn sie in Lappensystemen verwendet werden.

Sie sind ein Chat -Bot, der mit Daten Fragen beantwortet. Sie müssen sich an die Antworten halten, die ausschließlich durch den Text in der bereitgestellten Passage bereitgestellt werden. Ihnen wird die Frage gestellt: "Geben Sie eine kurze Zusammenfassung der folgenden Passage an, die die beschriebenen Kerninformationen abdeckt." <Passage> '

Beim Aufrufen der API wurde das <passage> -Token dann durch das Quelldokument ersetzt (siehe die Spalte "Quelle" in diesem Datensatz).

Im Folgenden finden Sie einen detaillierten Überblick über die integrierten Modelle und ihre spezifischen Endpunkte:

gpt-3.5-turbo über die Python-Client-Bibliothek von OpenAI, insbesondere über den Endpunkt von chat.completions.create .gpt-4 .gpt-4-turbo-2024-04-09 verwendet, entsprechend der Dokumentation von OpenAI.gpt-4o .gpt-4o-mini .o1-mini .o1-previewmeta-llama/Llama-2-xxb-chat-hf zugegriffen, wobei xxb 7b , 13b und 70b und auf die Kapazität jedes Modells zugeschnitten sein kann.chat Endpunkt und die Modellmeta meta-llama/Llama-3-xxB-chat-hf zugegriffen, wobei xxB 8B und 70B sein kann.Meta-Llama-3.1-405B-Instruct wird über die API von Replicate unter Verwendung des Modells meta/meta-llama-3.1-405b-instruct zugegriffen.Meta-Llama-3.2-3B-Instruct wird über einen gemeinsamen AI chat Endpunkt unter Verwendung von Modellmeta meta-llama/Llama-3.2-3B-Instruct-Turbo zugegriffen.Llama-3.2-11B-Vision-Instruct und Llama-3.2-90B-Vision-Instruct werden über AI chat Endpunkt unter Verwendung von Modellmeta meta-llama/Llama-3.2-11B-Vision-Instruct-Turbo und meta-llama/Llama-3.2-90B-Vision-Instruct-Turbo .command-r-08-2024 und dem /chat Endpunkt.command-r-plus-08-2024 und dem /chat Endpunkt.c4ai-aya-expanse-8b und c4ai-aya-expanse-32b . Weitere Informationen zu Coheres Modellen finden Sie in der Website.claude-2.0 für den API-Anruf aufgerufen.claude-3-opus-20240229 für den API-Aufruf aufgerufen.claude-3-sonnet-20240229 für den API-Aufruf aufgerufen.claude-3-5-sonnet-20241022 für den API-Aufruf aufgerufen.claude-3-5-haiku-20241022 für den API-Anruf aufgerufen.mistralai/Mixtral-8x22B-Instruct-v0.1 und dem chat Endpunkt.mistral-large-latest .text-bison-001 Modell.gemini-pro Modell von Google ist für eine verbesserte Sprachverarbeitung aufgenommen, die auf der Vertex-AI zugänglich ist.gemini-1.5-pro-001 auf Scheitelpunkt AI.gemini-1.5-flash-001 auf Scheitelpunkt AI.gemini-1.5-pro-002 auf Scheitelpunkt AI.gemini-1.5-flash-002 auf Scheitelpunkt AI.Für ein detailliertes Verständnis der Version und des Lebenszyklus jedes Modells, insbesondere die von Google angebotenen, finden Sie in Modellversionen und Lebenszyklen auf der Vertex-KI.

amazon.titan-text-express-v1 zugegriffen.microsoft/WizardLM-2-8x22B und den chat Endpunkt.databricks/dbrx-instruct und dem chat Endpunkt.snowflake/snowflake-arctic-instruct .chat Endpunkt mit dem Modellnamen Qwen/Qwen2-72B-Instruct .deepseek-chat Modell und dem chat Endpunkt.grok-beta und dem Endpunkt chat/completions . Qu. Warum verwenden Sie ein Modell, um ein Modell zu bewerten?

Antwort Es gibt mehrere Gründe, warum wir uns für eine menschliche Bewertung entschieden haben. Obwohl wir eine große Bewertung des menschlichen Maßstabs hätten haben können, ist dies eine einmalige Sache, aber es wird nicht so skaliert, dass wir die Rangliste ständig aktualisieren können, wenn neue APIs online werden oder Modelle aktualisiert werden. Wir arbeiten in einem schnell bewegenden Bereich, sodass ein solcher Prozess nicht mehr Daten mehr hat, sobald er veröffentlicht wurde. Zweitens wollten wir einen wiederholbaren Prozess, den wir mit anderen teilen können, damit sie ihn selbst als eine von vielen LLM -Qualitätswerten verwenden können, die sie bei der Bewertung ihrer eigenen Modelle verwenden. Dies wäre bei einem menschlichen Annotationsprozess nicht möglich, bei dem die einzigen Dinge, die geteilt werden könnten, der Prozess und die menschlichen Etiketten sind. Es lohnt sich auch, darauf hinzuweisen, dass das Aufbau eines Modells zur Erkennung von Halluzinationen viel einfacher ist als ein generatives Modell, das niemals Halluzinationen erzeugt. Solange das Halluzinationsbewertungsmodell in hohem Maße mit den Urteilen der menschlichen Bewerter korreliert, kann es als guter Stellvertreter für menschliche Richter stehen. Da wir speziell die Zusammenfassung und nicht allgemeine "geschlossene Buchbeantwortung" ansprechen, muss der von uns geschulte LLM keinen großen Teil des menschlichen Wissens auswendig gelernt haben, sondern nur ein solides Verständnis und Verständnis der Sprachen, die es unterstützt (derzeit nur Englisch, planen, die Sprachberichterstattung im Laufe der Zeit zu erweitern).

Qu. Was ist, wenn sich das LLM weigert, das Dokument zusammenzufassen oder eine Antwort von einem oder zwei Wörtern bereitzustellen?

Antwort Wir filtern diese ausdrücklich aus. Weitere Informationen finden Sie in unserem Blog -Beitrag. Sie können die Spalte "Antwortrate" in der Rangliste sehen, die den Prozentsatz der zusammengefassten Dokumente und die Spalte "Durchschnitts Zusammenfassung Länge" angibt, in der die Zusammenfassungslängen beschrieben werden. Wir zeigen, dass wir für die meisten Dokumente nicht sehr kurze Antworten erhalten haben.

Qu. Welche Version von Modell XYZ haben Sie verwendet?

Antwort Weitere Informationen zu den verwendeten Modellversionen und dem Aufrufen der Modellversionen sowie dem Datum, an dem die Rangliste aktualisiert wurde, finden Sie im Abschnitt API -Details. Bitte kontaktieren Sie uns (erstellen Sie ein Problem im Repo), wenn Sie mehr Klarheit benötigen.

Qu. Was ist mit Xais Grok LLM?

Antwort Derzeit (zum 14.14.2023) ist Grok nicht öffentlich verfügbar und wir haben keinen Zugriff. Diejenigen mit frühem Zugriff, von denen ich vermute, dass sie diese Art von Bewertung auf dem Modell wahrscheinlich rechtlich verboten sind. Sobald das Modell über eine öffentliche API verfügbar ist, werden wir es zusammen mit allen anderen LLMs hinzufügen, die genug beliebt sind.

Qu. Kann ein Modell nicht nur 100% erzielen, indem sie keine Antworten oder sehr kurze Antworten liefert?

Antwort Wir haben solche Antworten aus jedem Modell ausdrücklich herausgefiltert und die endgültige Bewertung nur an Dokumenten durchgeführt, für die alle Modelle eine Zusammenfassung erbracht haben. In unserem Blog -Beitrag zum Thema finden Sie weitere technische Details. Siehe auch die Spalten "Antwortrate" und "durchschnittliche Zusammenfassungslänge" in der obigen Tabelle.

Qu. Würde ein modelles Zusammenfassungsmodell, das nur zu 100% (0 Halluzination) zu dieser Aufgabe kopiert und Pasten aus der ursprünglichen Zusammenfassung kopiert?

Beantworten Sie absolut als per Definition, dass ein solches Modell keine Halluzinationen hat und eine treue Zusammenfassung darstellt. Wir behaupten nicht, die Zusammenfassung der Qualität zu bewerten, dh eine separate und orthogonale Aufgabe, und sollte unabhängig bewertet werden. Wir bewerten die Qualität der Zusammenfassungen nicht , sondern nur die sachliche Konsistenz von ihnen, wie wir im Blog -Beitrag hinweisen.

Qu. Dies scheint eine sehr hackbare Metrik zu sein, da Sie den Originaltext einfach als Zusammenfassung kopieren können

Antwort. Das stimmt, aber wir bewerten willkürliche Modelle bei diesem Ansatz nicht, z. B. wie bei einem Kaggle -Wettbewerb. Jedes Modell, das dies tut, würde bei jeder anderen Aufgabe, die Ihnen wichtig ist, schlecht abschneiden. Daher würde ich dies als hochwertige Metrik betrachten, die Sie neben allen anderen Bewertungen für Ihr Modell durchführen würden, z. B. die Qualität der Zusammenfassung, die Beantwortung von Fragen zur Beantwortung der Genauigkeit usw., aber wir empfehlen nicht, dies als eigenständige Metrik zu verwenden. Keiner der ausgewählten Modelle wurde auf der Ausgabe unseres Modells geschult. Das mag in Zukunft passieren, aber wenn wir vorhaben, das Modell und auch die Quelldokumente zu aktualisieren, ist dies eine lebendige Rangliste, die ein unwahrscheinliches Ereignis sein wird. Dies ist jedoch auch ein Problem mit jedem LLM -Benchmark. Wir sollten auch darauf hinweisen, dass dies auf einer großen Arbeit über sachliche Konsistenz baut, bei denen viele andere Akademiker dieses Protokoll erfunden und verfeinert haben. Sehen Sie sich unsere Referenzen auf die SUMAC- und TRAUE-Papiere in diesem Blog-Beitrag sowie diese hervorragende Zusammenstellung von Ressourcen an-https://github.com/edinburghnlp/awesome-hallucination-DeTection, um mehr zu lesen.

Qu. Dies misst nicht definitiv alle Möglichkeiten, wie ein Modell halluzinieren kann

Antwort. Vereinbart. Wir behaupten nicht, das Problem der Halluzinationserkennung gelöst zu haben, und planen, diesen Prozess weiter zu erweitern und zu verbessern. Aber wir glauben, dass es sich um einen Schritt in die richtige Richtung handelt, und bietet einen dringend benötigten Ausgangspunkt, auf dem jeder aufbauen kann.

Qu. Einige Modelle konnten nur beim Zusammenfassen halluzinieren. Könnten Sie ihm nicht einfach eine Liste von bekannten Fakten angeben und überprüfen, wie gut es sich erinnern kann?

Antwort. Das wäre meiner Meinung nach ein schlechter Test. Zum einen kennen Sie die Daten, an denen es geschult wurde, nicht sicher, dass das Modell seine Reaktion in realen Daten erdenkt, die es gesehen hat oder ob es erraten hat. Darüber hinaus gibt es keine eindeutige Definition von „bekanntem“ und diese Arten von Daten sind für die meisten Modelle in der Regel einfach, um sich genau zu erinnern. Die meisten Halluzinationen stammen in meiner zugegebenermaßen subjektiven Erfahrung aus dem Modell, in dem Informationen abgeholt werden, die sehr selten bekannt oder diskutiert sind oder für die das Modell widersprüchliche Informationen gesehen hat. Ohne die Quelldaten zu kennen, auf die das Modell trainiert wurde, ist es erneut unmöglich, diese Art von Halluzinationen zu validieren, da Sie nicht wissen, welche Daten zu diesem Kriterium passt. Ich denke auch, dass es unwahrscheinlich ist, dass das Modell nur beim Zusammenfassen halluzinieren würde. Wir bitten das Modell, Informationen zu nehmen und es auf eine Weise zu verändern, die der Quelle immer noch treu ist. Dies ist analog zu vielen generativen Aufgaben, abgesehen von der Zusammenfassung (z. B. schreiben Sie eine E -Mail, die diese Punkte abdeckt ...), und wenn das Modell von der Eingabeaufforderung abweicht, ist dies ein Versäumnis, Anweisungen zu befolgen, was darauf hinweist, dass das Modell auch auf andere Anweisungen kämpfen würde, die auch die folgenden Aufgaben folgen.

Qu. Dies ist ein guter Anfang, aber alles andere als endgültig

Antwort. Ich stimme vollkommen zu. Es muss noch viel mehr getan werden, und das Problem ist alles andere als gelöst. Ein "guter Start" bedeutet jedoch, dass in diesem Bereich hoffentlich Fortschritte erzielt werden, und durch offenes Beschaffung des Modells hoffen wir, die Community dazu einzubeziehen, dies auf die nächste Stufe zu bringen.