加州大学伯克利分校的研究团队近日发布了一项突破性的研究成果——TULIP(Towards Unified Language-Image Pretraining)模型。这一模型旨在提升视觉语言预训练的性能,特别是在需要高保真理解的视觉中心任务中,成功克服了现有对比学习模型(如CLIP)的局限性。

TULIP模型通过集成生成式数据增强、增强的对比学习以及重构正则化等创新技术,显著提升了视觉和语言之间的对齐能力。实验结果表明,TULIP在多个基准测试中均取得了最先进的性能,为零样本分类和视觉语言推理树立了新的标杆。

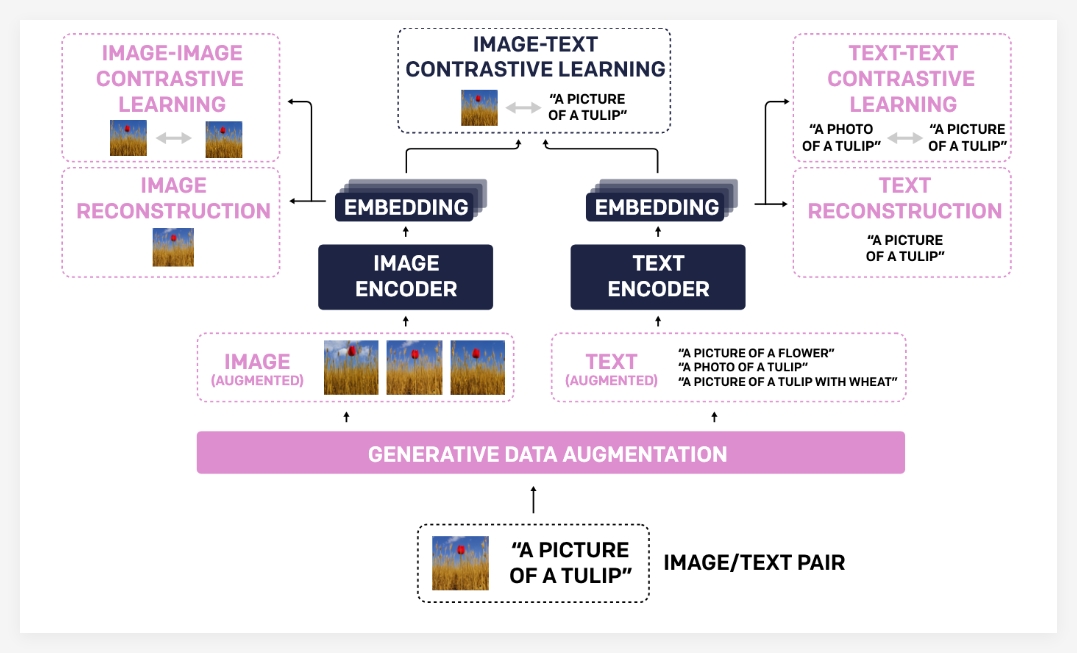

TULIP模型之所以能够取得如此显著的进步,主要归功于其独特的技术组合。首先,生成式数据增强(Generative Data Augmentation)利用生成模型来扩充训练数据,从而提高模型的鲁棒性和泛化能力。通过合成更多样化的图像-文本对,模型能够学习到更全面的视觉和语言知识。

其次,增强的对比学习(Enhanced Contrastive Learning)与传统的对比学习方法不同,TULIP不仅关注图像和文本之间的匹配,还引入了图像-图像以及文本-文本的对比学习目标。这种增强的对比学习方式能够帮助模型更好地理解不同图像之间的视觉相似性以及不同文本描述之间的语义关联,从而提升对细粒度信息的理解能力。

最后,重构正则化(Reconstruction Regularization)进一步加强了视觉和语言特征的对齐。该方法促使模型能够从图像特征中重构出对应的文本描述,或者从文本特征中重构出相应的图像,从而迫使模型学习到更深层次的跨模态关联。

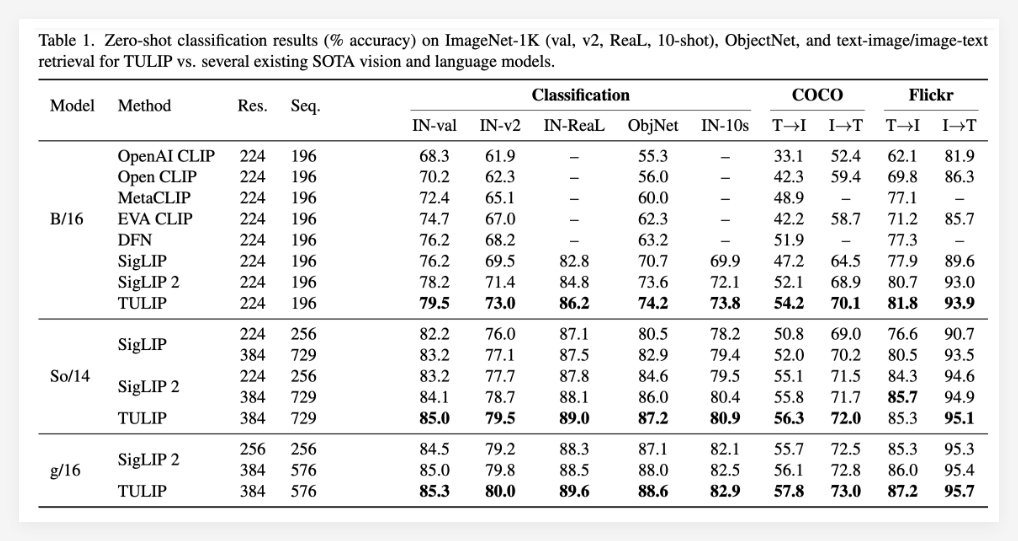

实验结果充分证明了TULIP模型的优越性。据报道,TULIP在多个重要的视觉和视觉语言基准测试中均达到了当前最优水平(state-of-the-art)。具体表现包括:ImageNet-1K零样本分类的显著提升、细粒度物体识别能力的增强以及多模态推理得分的提高。

尤其值得一提的是,TULIP相较于现有方法,在MMVP基准测试中取得了高达3倍的性能提升,并且在微调的视觉任务上也实现了2倍的性能提升。这些数据充分表明了TULIP在提升模型性能方面的巨大潜力。

项目:https://tulip-berkeley.github.io/