カリフォルニア大学バークレー校の研究チームは最近、画期的な研究結果であるチューリップ(統一された言語イメージ前)モデルをリリースしました。このモデルは、特に高忠実度の理解を必要とする視覚中心のタスクにおいて、視覚言語の事前トレーニングのパフォーマンスを改善することを目的としており、既存のコントラスト学習モデル(CLIPなど)の制限を克服することを目的としています。

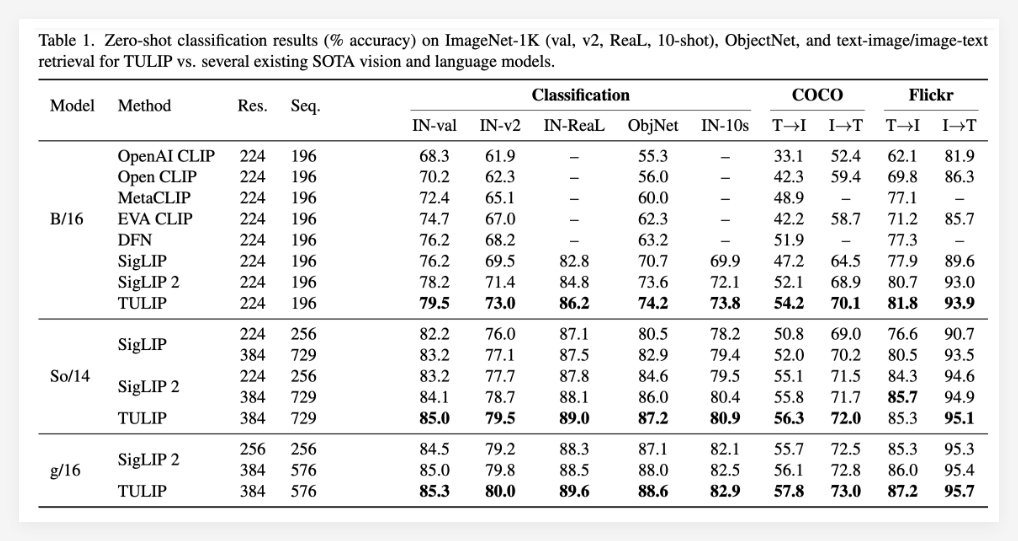

TULIPモデルは、統合された生成データの増強、コントラスト学習の強化、再構築の正規化などの革新的な技術を通じて、ビジョンと言語の整合性を大幅に改善します。実験結果は、チューリップが複数のベンチマークで最先端のパフォーマンスを達成し、ゼロサンプル分類と視覚的な言語の推論のための新しいベンチマークを設定したことを示しています。

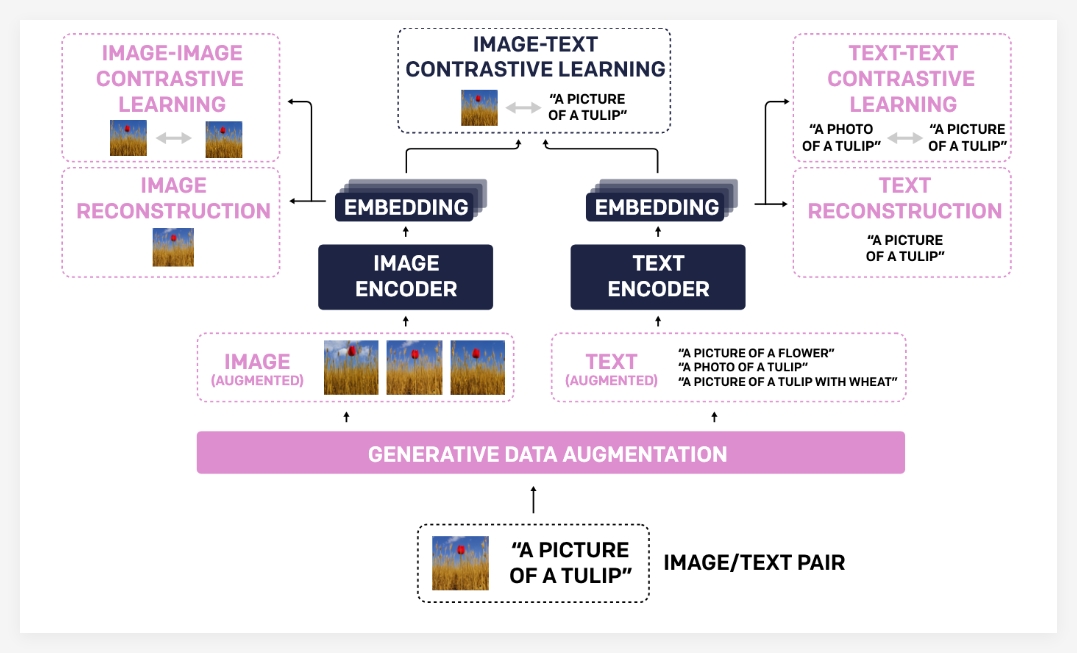

チューリップモデルがこのような重要な進歩を達成した理由は、主にそのユニークなテクノロジーポートフォリオによるものです。第一に、生成データの増強は、生成モデルを使用してトレーニングデータを拡張し、それによりモデルの堅牢性と一般化能力を改善します。より多様な画像テキストペアを合成することにより、モデルはより包括的な視覚的および言語的知識を学ぶことができます。

第二に、強化されたコントラスト学習は、従来のコントラスト学習方法とは異なります。 Tulipは、画像とテキストの一致に焦点を当てるだけでなく、画像イメージとテキストテキストの比較学習目標を紹介します。この強化されたコントラスト学習方法は、モデルが異なる画像間の視覚的類似性と、異なるテキストの説明間のセマンティックな関連性をよりよく理解するのに役立ちます。

最後に、再構築の正規化により、視覚的および言語的特徴の整合がさらに強化されます。この方法により、モデルは画像機能から対応するテキストの説明をテキスト機能から対応する画像から再構築することで、モデルにより深いクロスモーダルの関連性を学習させることができます。

実験結果は、チューリップモデルの優位性を完全に証明しています。チューリップは、複数の重要な視覚的および視覚的言語ベンチマーク(最先端)で現在の最適レベルを達成したと報告されています。特定のパフォーマンスには、ImagENET-1Kゼロサンプル分類の大幅な改善、微細粒子認識能力の強化、およびマルチモーダル推論スコアの改善が含まれます。

Tulipは、既存の方法と比較して、MMVPベンチマークで最大3倍のパフォーマンスの改善を達成しており、微調整された視覚タスクの2倍のパフォーマンス改善も達成していることに特に言及する価値があります。これらのデータは、モデルのパフォーマンスの向上におけるチューリップの大きな可能性を完全に示しています。

プロジェクト:https://tulip-berkeley.github.io/