Situs web resmi www.binance.com/zh-cn :Masukkan situs web resmi ☜☜

Aplikasi: ☞☞ Unduh Aplikasi Resmi☜☜

Tim peneliti di University of California, Berkeley baru -baru ini merilis model penelitian terobosan - model TULIP (menuju pretraining image -image). Model ini bertujuan untuk meningkatkan kinerja pra-pelatihan bahasa visual, terutama dalam tugas yang berpusat pada penglihatan yang membutuhkan pemahaman kesetiaan tinggi, dan berhasil mengatasi keterbatasan model pembelajaran kontras yang ada (seperti klip).

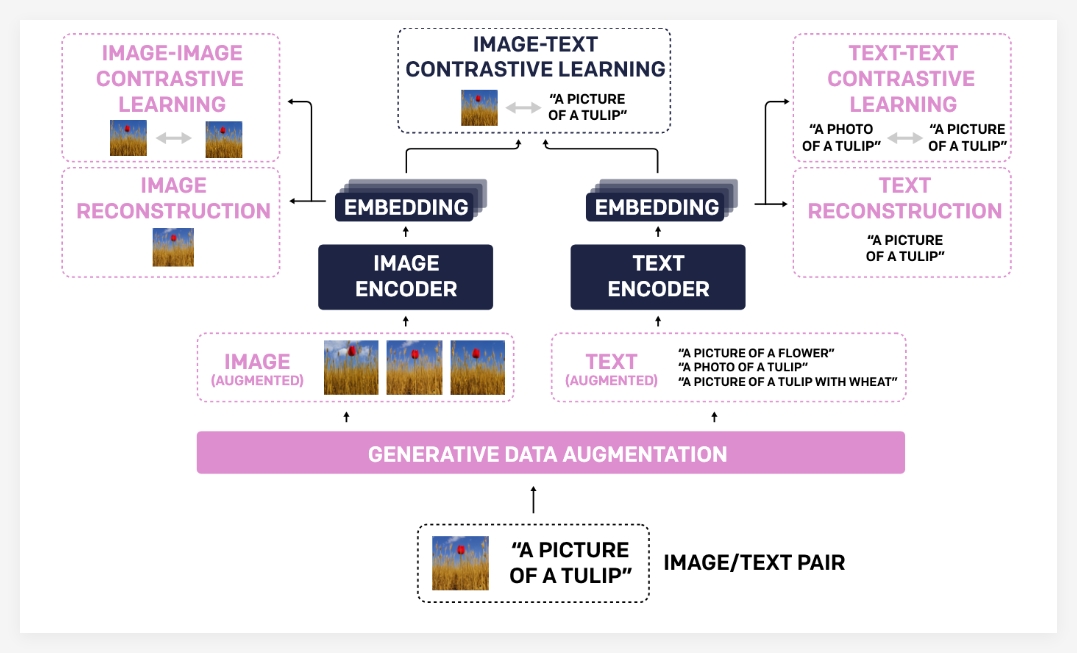

Model TULIP secara signifikan meningkatkan penyelarasan antara visi dan bahasa melalui teknologi inovatif seperti augmentasi data generatif terintegrasi, peningkatan pembelajaran kontras, dan regularisasi rekonstruksi. Hasil eksperimen menunjukkan bahwa Tulip telah mencapai kinerja canggih dalam berbagai tolok ukur, menetapkan tolok ukur baru untuk klasifikasi sampel nol dan penalaran bahasa visual.

Alasan mengapa model TULIP telah mencapai kemajuan yang signifikan terutama karena portofolio teknologi yang unik. Pertama, augmentasi data generatif menggunakan model generatif untuk menambah data pelatihan, sehingga meningkatkan ketahanan dan kemampuan generalisasi model. Dengan mensintesis pasangan teks-teks yang lebih beragam, model ini dapat mempelajari pengetahuan visual dan linguistik yang lebih komprehensif.

Kedua, pembelajaran kontras yang ditingkatkan berbeda dari metode pembelajaran kontras tradisional. Tulip tidak hanya berfokus pada pencocokan antara gambar dan teks, tetapi juga memperkenalkan gambar-gambar dan tujuan pembelajaran perbandingan teks dan teks. Metode pembelajaran kontras yang ditingkatkan ini dapat membantu model lebih memahami kesamaan visual antara gambar yang berbeda dan asosiasi semantik antara deskripsi teks yang berbeda, sehingga meningkatkan pemahaman mereka tentang informasi berbutir halus.

Akhirnya, regularisasi Rekonstruksi semakin memperkuat penyelarasan fitur visual dan linguistik. Metode ini memungkinkan model untuk merekonstruksi deskripsi teks yang sesuai dari fitur gambar atau gambar yang sesuai dari fitur teks, sehingga memaksa model untuk mempelajari asosiasi lintas-modal yang lebih dalam.

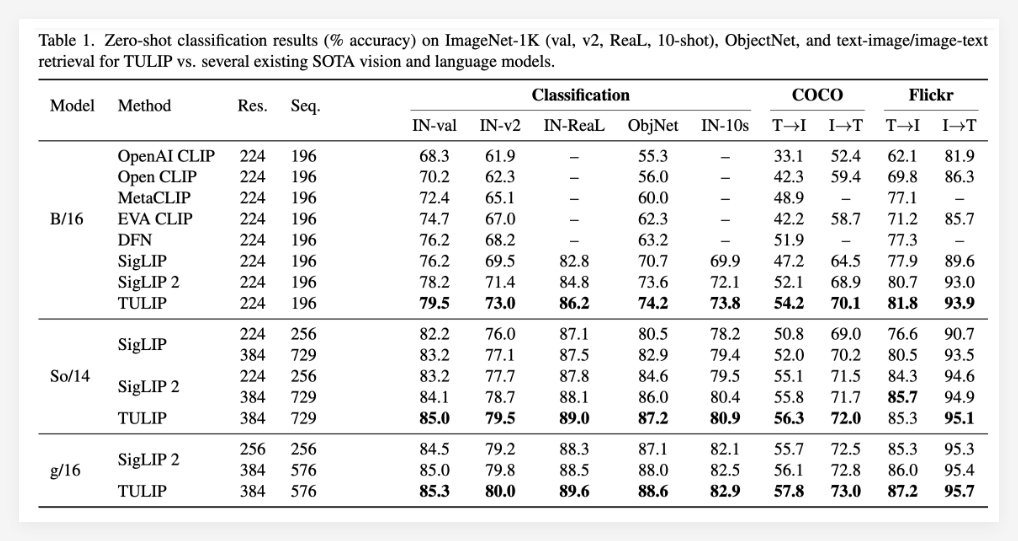

Hasil eksperimen sepenuhnya membuktikan keunggulan model tulip. Tulip telah dilaporkan telah mencapai tingkat optimal saat ini dalam berbagai tolok ukur bahasa visual dan visual yang penting (canggih). Kinerja spesifik meliputi: peningkatan signifikan dalam klasifikasi sampel nol ImageNet-1K, kemampuan pengenalan objek berbutir halus yang ditingkatkan, dan peningkatan skor inferensi multimodal.

Perlu disebutkan bahwa dibandingkan dengan metode yang ada, Tulip telah mencapai peningkatan kinerja hingga 3 kali dalam tolok ukur MMVP, dan juga telah mencapai peningkatan kinerja 2 kali dalam tugas visual yang disempurnakan. Data ini sepenuhnya menunjukkan potensi besar tulip dalam meningkatkan kinerja model.

Proyek: https://tulip-berkeley.github.io/