Das Forschungsteam an der University of California, Berkeley, hat kürzlich ein bahnbrechendes Forschungsergebnis veröffentlicht - das Tulip -Modell (in Richtung Unified Language -Image). Dieses Modell zielt darauf ab, die Leistung der visuellen Sprache vor der Ausbildung zu verbessern, insbesondere bei sehzentrierten Aufgaben, die ein hohes Verständnis erfordern, und übertrifft erfolgreich die Grenzen bestehender Kontrastlernmodelle (wie Clip).

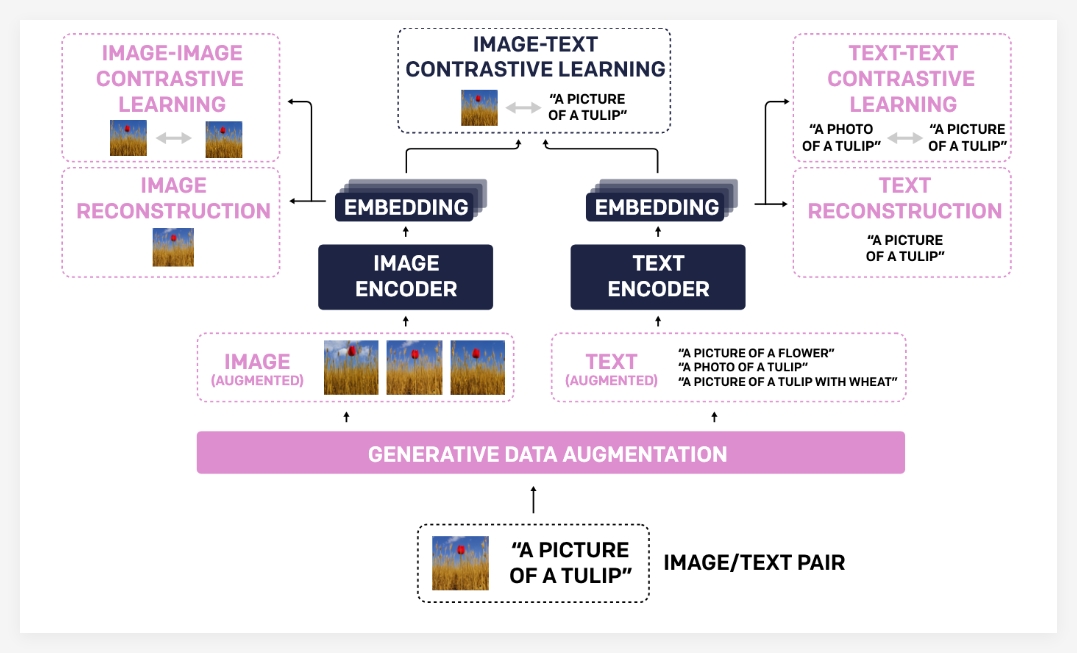

Das Tulip -Modell verbessert die Ausrichtung zwischen Vision und Sprache erheblich durch innovative Technologien wie integrierte generative Datenvergrößerung, verbessertes Kontrastlernen und die Regularisierung der Rekonstruktion. Experimentelle Ergebnisse zeigen, dass Tulip in mehreren Benchmarks eine hochmoderne Leistung erzielt hat und einen neuen Benchmark für die Klassifizierung ohne Stichprobe und visuelle Sprachbekämpfung festgelegt hat.

Der Grund, warum das Tulip -Modell einen solchen bedeutenden Fortschritt erzielt hat, ist hauptsächlich auf sein einzigartiges Technologieportfolio zurückzuführen. Erstens verwendet generative Datenvergrößerung generative Modelle, um Schulungsdaten zu erweitern, wodurch die Robustheit und die Verallgemeinerungsfunktionen des Modells verbessert werden. Durch die Synthese vielfältigerer Bild-Text-Paare kann das Modell umfassendere visuelle und sprachliche Kenntnisse erlernen.

Zweitens unterscheidet sich ein verbessertes kontrastives Lernen von traditionellen Kontrastlernmethoden. Tulip konzentriert sich nicht nur auf die Übereinstimmung zwischen Bildern und Text, sondern führt auch Bild-Image- und Text-Text-Vergleichslernziele ein. Diese verbesserte Kontrastlernmethode kann das Verständnis der visuellen Ähnlichkeiten zwischen verschiedenen Bildern und semantischen Assoziationen zwischen verschiedenen Textbeschreibungen verbessern und damit ihr Verständnis von feinkörnigen Informationen verbessern.

Schließlich stärkt die Re -Regularisierung der Rekonstruktion die Ausrichtung visueller und sprachlicher Merkmale weiter. Mit dieser Methode kann das Modell die entsprechende Textbeschreibung aus den Bildmerkmalen oder den entsprechenden Bildern aus den Textmerkmalen rekonstruieren und das Modell dazu zwingen, tiefere Kreuzmodal-Assoziationen zu lernen.

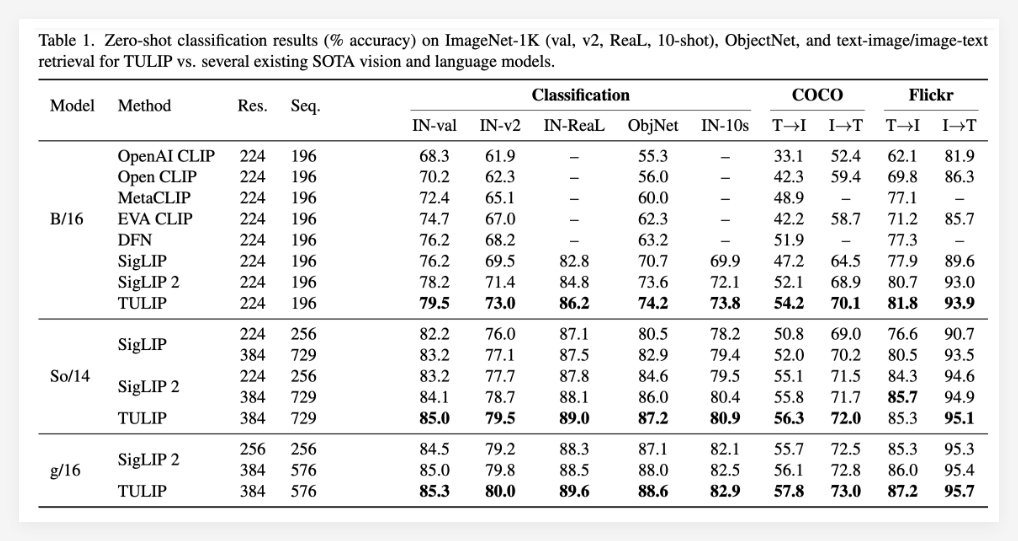

Die experimentellen Ergebnisse beweisen die Überlegenheit des Tulpenmodells vollständig. Es wurde berichtet, dass Tulip in mehreren wichtigen visuellen und visuellen Sprach Benchmarks (hochmoderne) aktuelle optimale Ebenen erreicht hat. Zu den spezifischen Leistungen gehören: signifikante Verbesserung der Klassifizierung von ImageNET-1K-Stichproben, verbesserte Funktionen für feinkörnige Objekterkennung und verbesserte multimodale Inferenzwerte.

Es ist besonders erwähnenswert, dass Tulip im Vergleich zu vorhandenen Methoden bis zu dreifache Leistungsverbesserungen bei MMVP-Benchmarks erzielt und auch zweimal Leistungsverbesserungen bei fein abgestimmten visuellen Aufgaben erzielt hat. Diese Daten zeigen vollständig das große Potenzial von Tulpe bei der Verbesserung der Modellleistung.

Projekt: https://tulip-berkeley.github.io/