버클리 캘리포니아 대학교 (University of California)의 연구팀은 최근 획기적인 연구 결과를 발표했다. 이 모델은 특히 고급 이해가 필요한 비전 중심 작업에서 시각적 언어 사전 훈련의 성능을 향상시키고 기존 대비 학습 모델 (예 : 클립)의 한계를 성공적으로 극복하는 것을 목표로합니다.

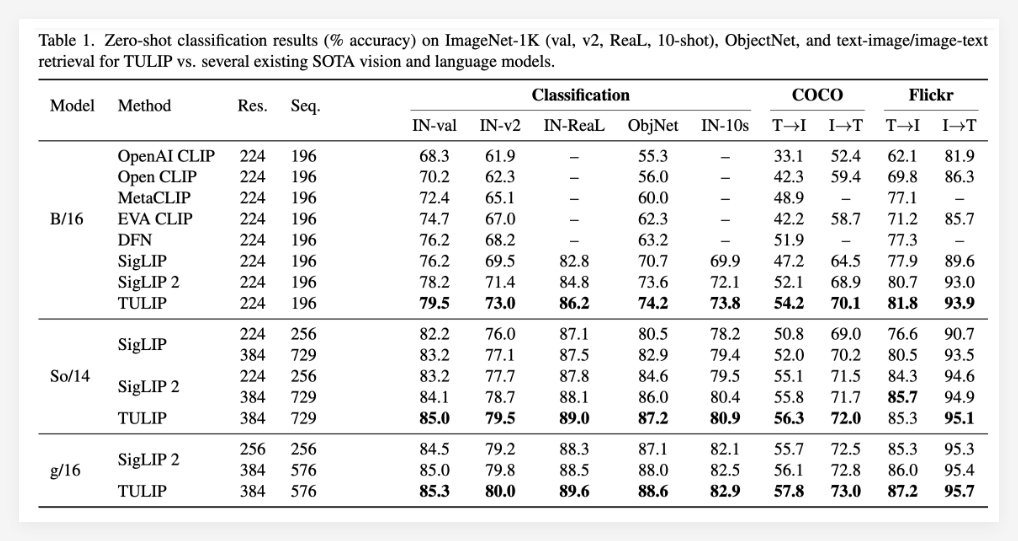

튤립 모델은 통합 생성 데이터 증강, 향상된 대비 학습 및 재건 정규화와 같은 혁신적인 기술을 통해 비전과 언어 사이의 조정을 크게 향상시킵니다. 실험 결과에 따르면 Tulip은 여러 벤치 마크에서 최첨단 성능을 달성하여 제로 표본 분류 및 시각적 언어 추론에 대한 새로운 벤치 마크를 설정했습니다.

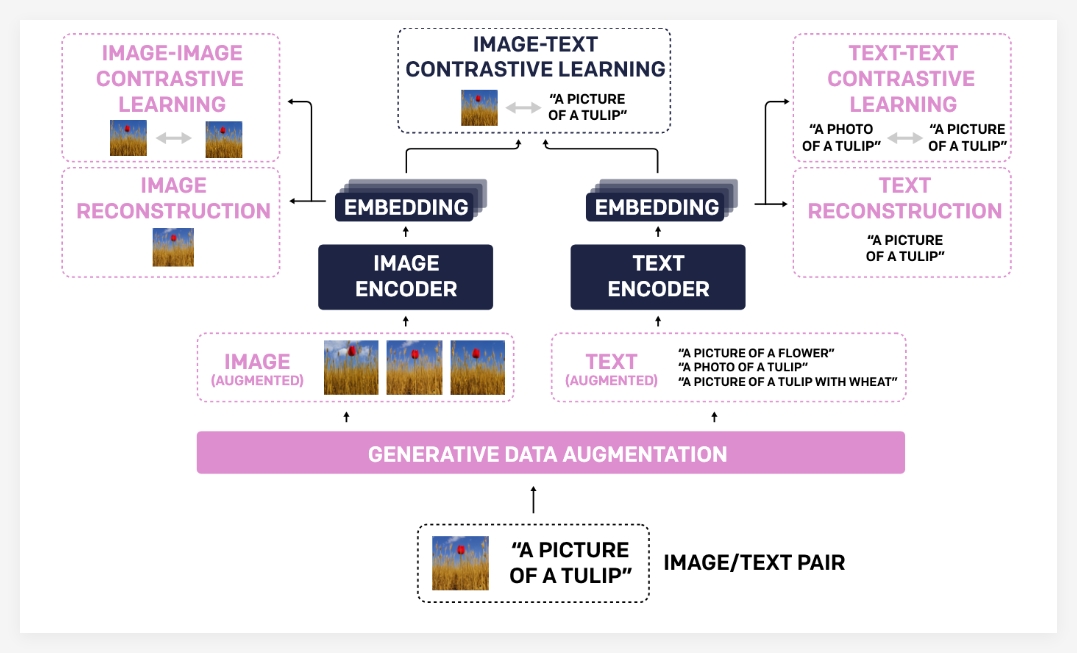

튤립 모델이 이러한 상당한 진전을 이루는 이유는 주로 고유 한 기술 포트폴리오 때문입니다. 첫째, 생성 데이터 증강은 생성 모델을 사용하여 교육 데이터를 증대시켜 모델의 견고성 및 일반화 기능을 향상시킵니다. 보다 다양한 이미지 텍스트 쌍을 합성 함으로써이 모델은보다 포괄적 인 시각적 및 언어 지식을 배울 수 있습니다.

둘째, 향상된 대비 학습은 전통적인 대비 학습 방법과 다릅니다. Tulip은 이미지와 텍스트 간의 일치에 중점을 둘뿐만 아니라 이미지 이미지 및 텍스트 텍스트 비교 학습 목표를 소개합니다. 이 향상된 대비 학습 방법은 모델 모델이 다른 이미지와 다른 텍스트 설명 사이의 시각적 유사성을 더 잘 이해하도록 도와 주므로 세분화 된 정보에 대한 이해를 향상시킵니다.

마지막으로, 재구성 정규화는 시각적 및 언어 적 특징의 정렬을 더욱 강화시킨다. 이 메소드를 사용하면 모델이 이미지 기능 또는 텍스트 기능의 해당 이미지에서 해당 텍스트 설명을 재구성 할 수 있으므로 모델은 더 깊은 교차 모달 연관성을 배울 수 있습니다.

실험 결과는 튤립 모델의 우수성을 완전히 입증합니다. Tulip은 여러 중요한 시각 및 시각적 언어 벤치 마크 (최신)에서 현재 최적 수준을 달성 한 것으로보고되었습니다. 특정 성능은 다음과 같습니다. ImageNet-1K 제로 샘플 분류의 상당한 개선, 향상된 세밀한 객체 인식 기능 및 개선 된 멀티 모달 추론 점수가 포함됩니다.

기존 방법과 비교할 때 Tulip은 MMVP 벤치 마크에서 최대 3 배의 성능 향상을 달성했으며 미세 조정 된 시각적 작업에서 2 배의 성능 향상을 달성했습니다. 이 데이터는 모델 성능 향상에 튤립의 큰 잠재력을 완전히 보여줍니다.

프로젝트 : https://tulip-berkeley.github.io/