A equipe de pesquisa da Universidade da Califórnia, Berkeley divulgou recentemente um resultado de pesquisa inovador - o modelo de tulipa (em direção a pré -treinamento de imagem de linguagem unificada). Esse modelo tem como objetivo melhorar o desempenho do pré-treinamento da linguagem visual, especialmente em tarefas centradas na visão que exigem entendimento de alta fidelidade e supera com sucesso as limitações dos modelos de aprendizado de contraste existentes (como clipe).

O modelo de tulipa melhora significativamente o alinhamento entre visão e linguagem por meio de tecnologias inovadoras, como aumento de dados generativos integrados, aprendizado aprimorado de contraste e regularização de reconstrução. Os resultados experimentais mostram que a Tulip alcançou o desempenho de última geração em vários benchmarks, definindo um novo benchmark para classificação de amostra zero e raciocínio de linguagem visual.

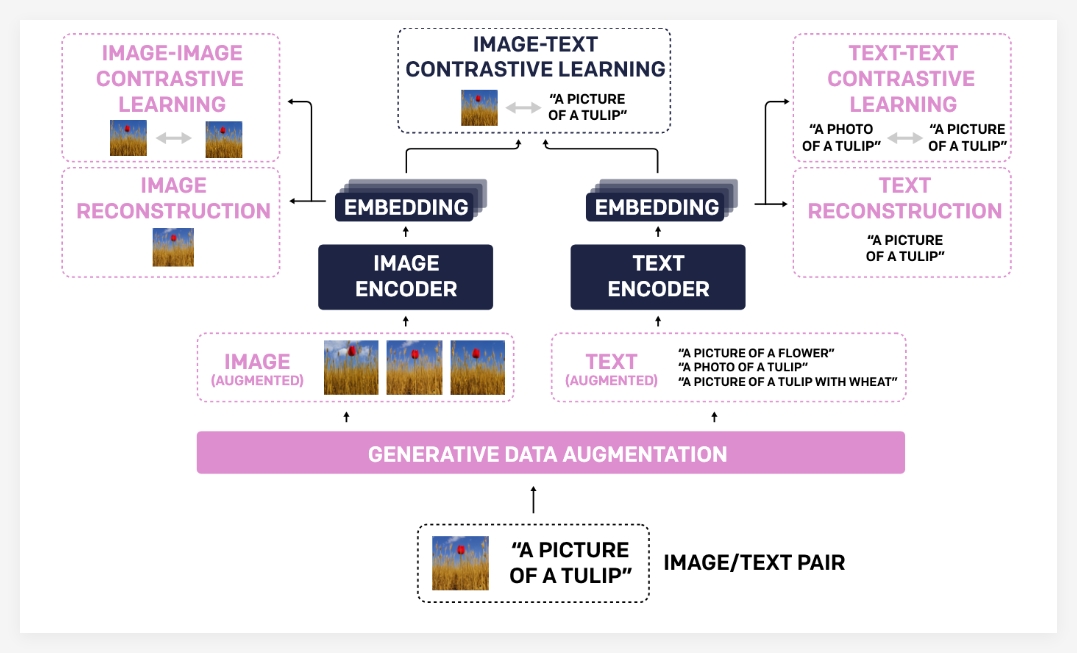

A razão pela qual o modelo de tulipa alcançou um progresso tão significativo se deve principalmente ao seu portfólio de tecnologia exclusivo. Primeiro, o aumento generativo de dados usa modelos generativos para aumentar os dados de treinamento, melhorando assim os recursos de robustez e generalização do modelo. Ao sintetizar pares de texto de imagem mais diversos, o modelo pode aprender um conhecimento visual e linguístico mais abrangente.

Em segundo lugar, o aprendizado contrastivo aprimorado é diferente dos métodos tradicionais de aprendizado de contraste. A Tulip não apenas se concentra na correspondência entre imagens e texto, mas também apresenta as metas de aprendizado de imagem de imagem e texto de texto e texto. Esse método aprimorado de aprendizado de contraste pode ajudar os modelos a entender melhor as semelhanças visuais entre diferentes imagens e associações semânticas entre diferentes descrições de texto, melhorando assim sua compreensão das informações de granulação fina.

Finalmente, a regularização da reconstrução fortalece ainda mais o alinhamento de características visuais e linguísticas. Este método permite que o modelo reconstrua a descrição do texto correspondente dos recursos da imagem ou das imagens correspondentes dos recursos de texto, forçando o modelo a aprender associações cruzadas mais profundas.

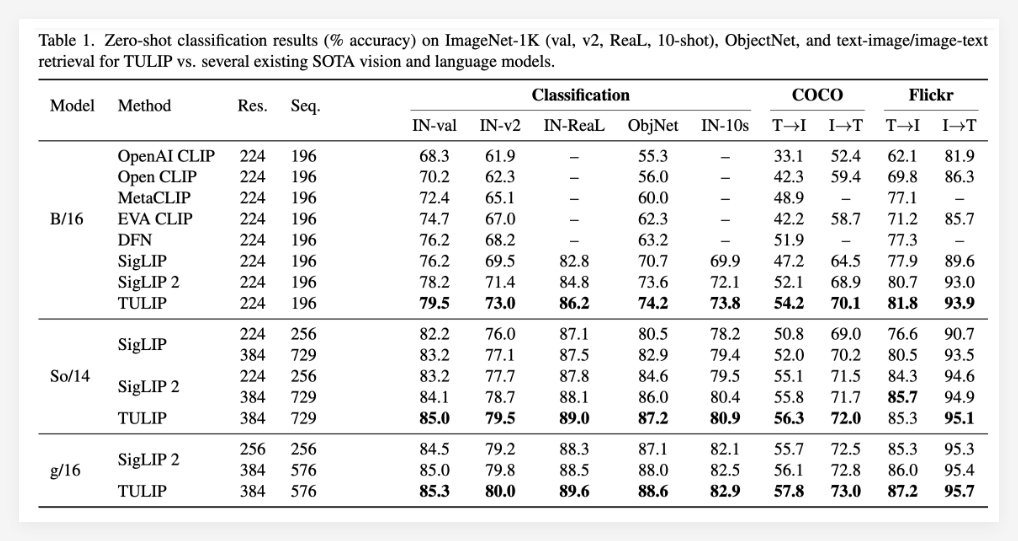

Os resultados experimentais provam totalmente a superioridade do modelo de tulipa. Foi relatado que a tulipa atingiu níveis ideais atuais em múltiplos referências importantes de linguagem visual e visual (de última geração). As performances específicas incluem: melhora significativa na classificação do ImageNet-1K de amostra zero, recursos aprimorados de reconhecimento de objetos de granulação fina e pontuações de inferência multimodais aprimoradas.

Vale a pena mencionar particularmente que, em comparação com os métodos existentes, a Tulip alcançou até 3 vezes melhorias de desempenho nos benchmarks de MMVP e também alcançou 2 vezes melhorias de desempenho nas tarefas visuais ajustadas. Esses dados demonstram totalmente o grande potencial da tulipa na melhoria do desempenho do modelo.

Projeto: https://tulip-berkeley.github.io/