Site Web officiel www.binance.com/ZH-CN :Entrez le site officiel ☜☜

Application: ☞☞Official App Download☜☜

L'équipe de recherche de l'Université de Californie, Berkeley, a récemment publié un modèle de recherche de recherche révolutionnaire - le modèle Tulip (vers unifié l'image linguistique pré-formation). Ce modèle vise à améliorer les performances de la pré-formation du langage visuel, en particulier dans les tâches centrées sur la vision nécessitant une compréhension à haute fidélité, et surmonte avec succès les limites des modèles d'apprentissage de contraste existants (tels que CLIP).

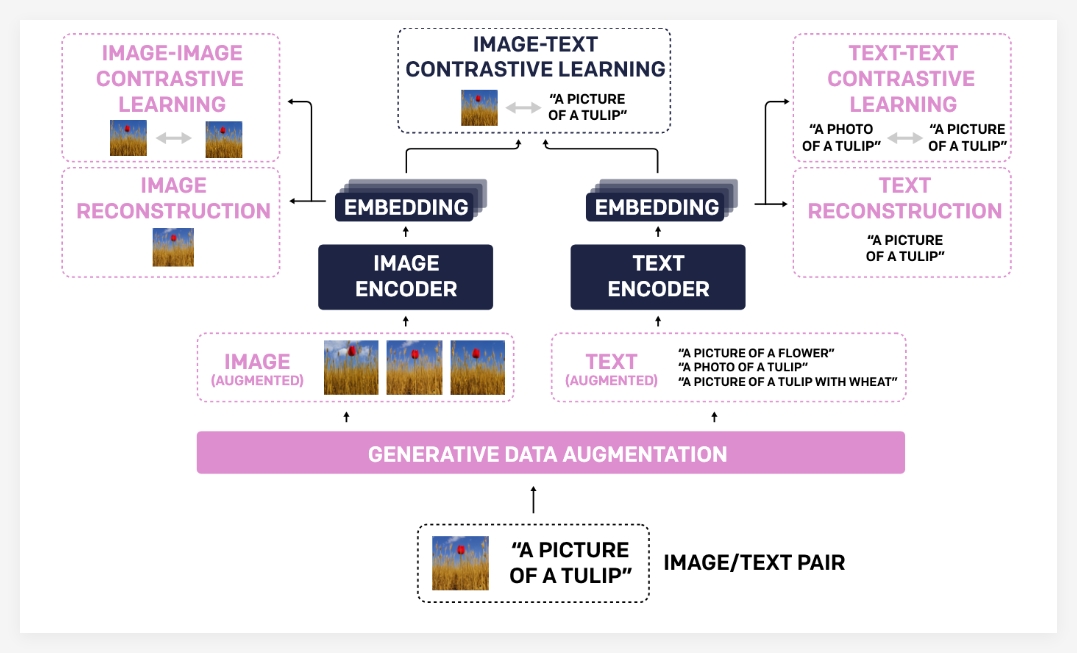

Le modèle Tulip améliore considérablement l'alignement entre la vision et le langage grâce à des technologies innovantes telles que l'augmentation intégrée des données génératrices, l'apprentissage amélioré des contrastes et la régularisation de la reconstruction. Les résultats expérimentaux montrent que Tulip a atteint des performances de pointe dans plusieurs repères, définissant une nouvelle référence pour la classification de l'échantillon zéro et le raisonnement du langage visuel.

La raison pour laquelle le modèle Tulip a réalisé des progrès aussi significatifs est principalement due à son portefeuille technologique unique. Premièrement, l'augmentation des données génératrices utilise des modèles génératifs pour augmenter les données de formation, améliorant ainsi les capacités de robustesse et de généralisation du modèle. En synthétisant des paires de texte d'image plus diverses, le modèle peut apprendre des connaissances visuelles et linguistiques plus complètes.

Deuxièmement, l'apprentissage contrasté amélioré est différent des méthodes d'apprentissage de contraste traditionnelles. Tulip se concentre non seulement sur la correspondance entre les images et le texte, mais introduit également des objectifs d'apprentissage de comparaison d'image d'image et de texte de texte. Cette méthode d'apprentissage en contraste améliorée peut aider les modèles à mieux comprendre les similitudes visuelles entre différentes images et les associations sémantiques entre différentes descriptions de texte, améliorant ainsi leur compréhension des informations à grain fin.

Enfin, la régularisation de la reconstruction renforce encore l'alignement des caractéristiques visuelles et linguistiques. Cette méthode permet au modèle de reconstruire la description du texte correspondante à partir des caractéristiques de l'image ou des images correspondantes des caractéristiques du texte, forçant ainsi le modèle à apprendre des associations croisées plus profondes.

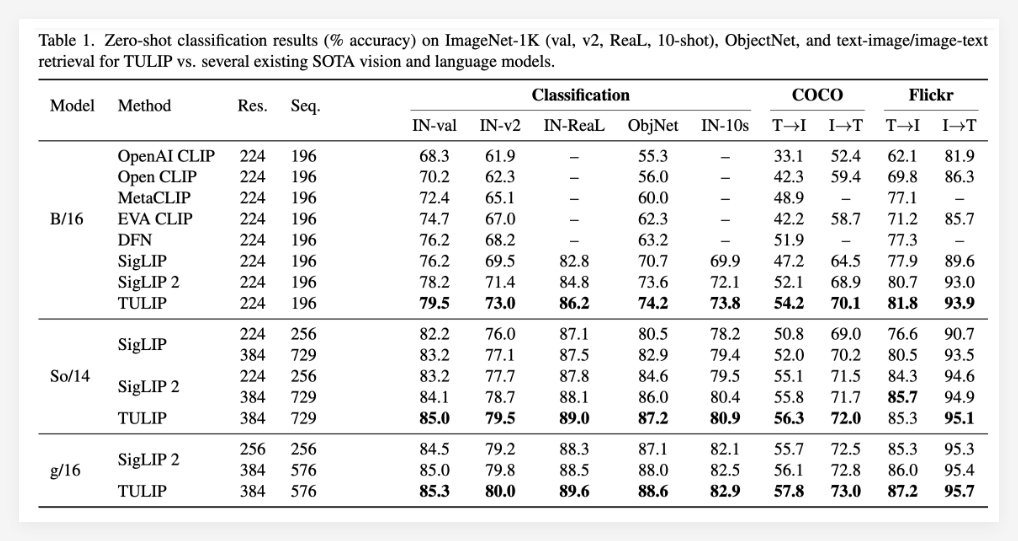

Les résultats expérimentaux prouvent pleinement la supériorité du modèle Tulip. Le tulip a été rapporté avoir atteint des niveaux optimaux actuels dans plusieurs repères de langage visuel et visuel important (de pointe). Les performances spécifiques comprennent: une amélioration significative de la classification de l'échantillon zéro ImageNet-1k, des capacités de reconnaissance d'objets à grain fin amélioré et des scores d'inférence multimodaux améliorés.

Il convient de mentionner que par rapport aux méthodes existantes, la Tulip a atteint jusqu'à 3 fois les améliorations des performances dans les références MMVP, et a également réalisé 2 fois des améliorations de performances dans les tâches visuelles affinées. Ces données démontrent pleinement le grand potentiel de la tulipe pour améliorer les performances du modèle.

Projet: https://tulip-berkeley.github.io/