Sitio web oficial www.binance.com/zh-cn :ingrese el sitio web oficial ☜☜

Aplicación: ☞☞Official App Download☜☜

El equipo de investigación de la Universidad de California, Berkeley, publicó recientemente un resultado de la investigación innovadora: el modelo Tulip (hacia el preado de imágenes de idiomas unificados). Este modelo tiene como objetivo mejorar el rendimiento del pre-entrenamiento del lenguaje visual, especialmente en las tareas centradas en la visión que requieren una comprensión de alta fidelidad, y supera con éxito las limitaciones de los modelos de aprendizaje de contraste existentes (como el clip).

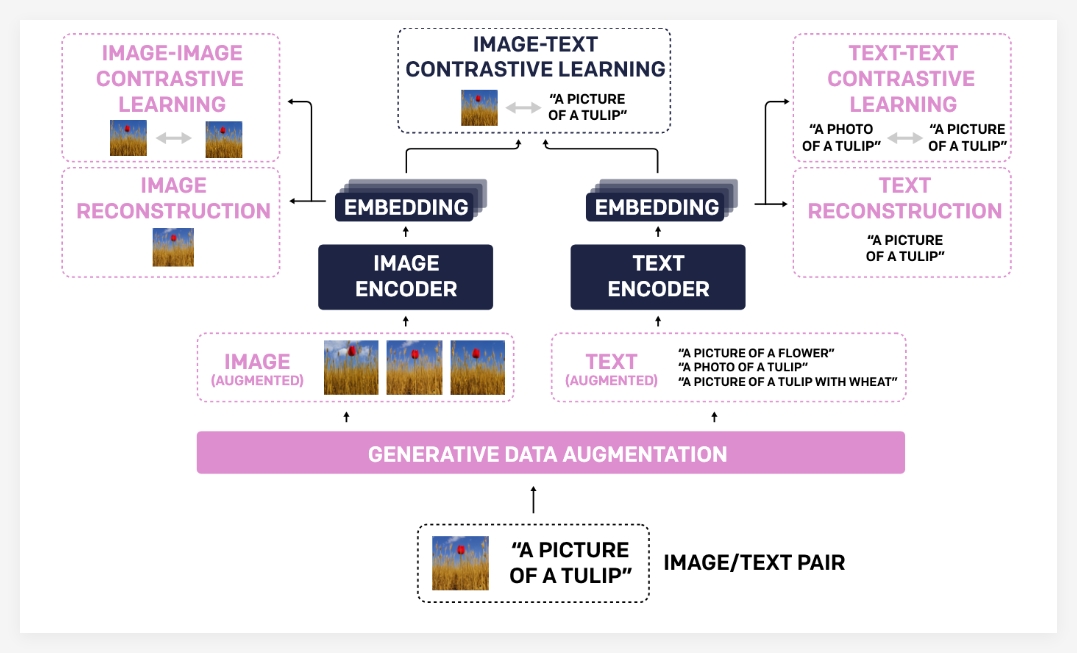

El modelo Tulip mejora significativamente la alineación entre la visión y el lenguaje a través de tecnologías innovadoras, como el aumento de datos generativos integrados, el aprendizaje de contraste mejorado y la regularización de la reconstrucción. Los resultados experimentales muestran que Tulip ha logrado un rendimiento de vanguardia en múltiples puntos de referencia, estableciendo un nuevo punto de referencia para la clasificación de muestras cero y el razonamiento del lenguaje visual.

La razón por la cual el modelo Tulip ha logrado un progreso tan significativo se debe principalmente a su cartera de tecnología única. Primero, el aumento generativo de datos utiliza modelos generativos para aumentar los datos de capacitación, mejorando así las capacidades de robustez y generalización del modelo. Al sintetizar pares de texto de imagen más diversos, el modelo puede aprender un conocimiento visual y lingüístico más integral.

En segundo lugar, el aprendizaje de contraste mejorado es diferente de los métodos de aprendizaje de contraste tradicional. Tulip no solo se centra en la coincidencia entre imágenes y texto, sino que también presenta objetivos de aprendizaje de comparación de imágenes y texto de texto. Este método de aprendizaje de contraste mejorado puede ayudar a los modelos a comprender mejor las similitudes visuales entre diferentes imágenes y asociaciones semánticas entre diferentes descripciones de texto, mejorando así su comprensión de la información de grano fino.

Finalmente, la regularización de la reconstrucción fortalece aún más la alineación de las características visuales y lingüísticas. Este método permite que el modelo reconstruya la descripción del texto correspondiente de las características de la imagen o las imágenes correspondientes de las características del texto, lo que obliga al modelo a aprender asociaciones intermodales más profundas.

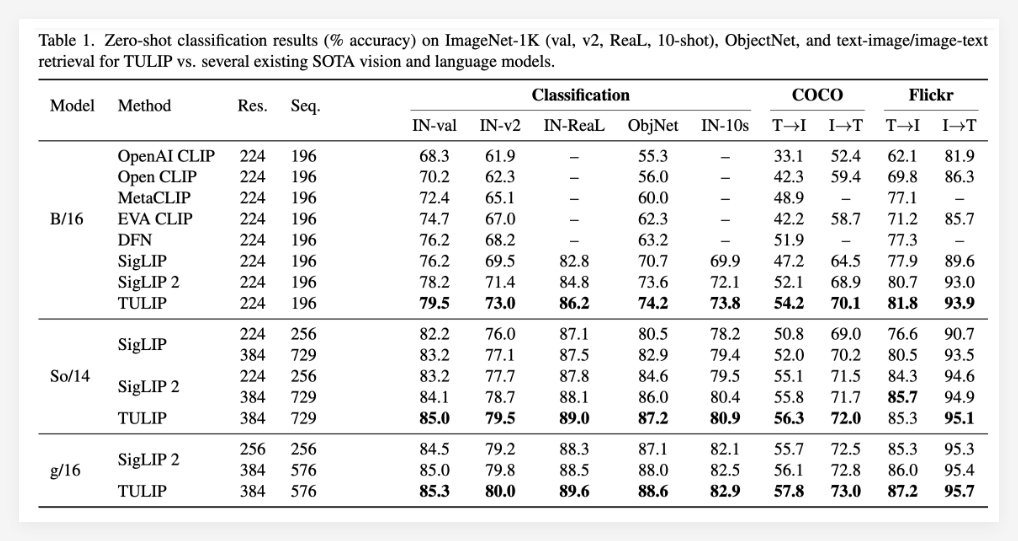

Los resultados experimentales demuestran completamente la superioridad del modelo de tulipán. Se ha informado que Tulip ha logrado niveles óptimos actuales en múltiples puntos de referencia de lenguaje visual y visual importantes (estado del arte). Las actuaciones específicas incluyen: Mejora significativa en la clasificación de muestras cero Imagenet-1k, capacidades mejoradas de reconocimiento de objetos de grano fino y puntajes de inferencia multimodal mejorados.

Vale la pena mencionar que, en comparación con los métodos existentes, Tulip ha logrado hasta 3 veces mejoras de rendimiento en los puntos de referencia MMVP, y también ha logrado mejoras de rendimiento 2 veces en tareas visuales ajustadas. Estos datos demuestran completamente el gran potencial de tulipán para mejorar el rendimiento del modelo.

Proyecto: https://tulip-berkeley.github.io/