أصدر فريق الأبحاث في جامعة كاليفورنيا ، بيركلي مؤخرًا نتيجة بحثية اختراق - نموذج TULIP (نحو تصورات اللغة الموحدة). يهدف هذا النموذج إلى تحسين أداء التدريب قبل اللغة البصرية ، وخاصة في المهام المتمحورة حول الرؤية التي تتطلب فهمًا عالي الدقة ، ويتغلب بنجاح على حدود نماذج التعلم على التباين الحالية (مثل المقطع).

يحسن نموذج TULIP بشكل كبير التوافق بين الرؤية واللغة من خلال التقنيات المبتكرة مثل زيادة البيانات التوليدية المتكاملة ، وتعزيز التعلم على التباين ، وتنظيم إعادة الإعمار. أظهرت النتائج التجريبية أن TULIP حقق أداءً على أحدث طراز في معايير متعددة ، ووضع معيارًا جديدًا لتصنيف العينة الصفرية والتفكير في اللغة البصرية.

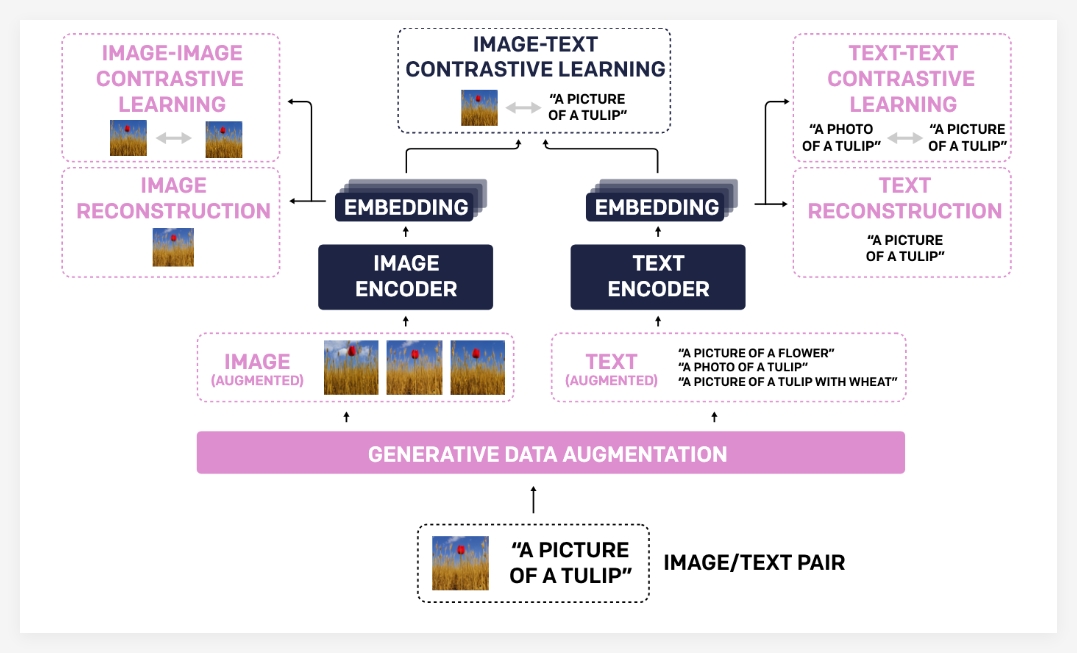

يرجع السبب في أن نموذج TULIP قد حقق مثل هذا التقدم الكبير يرجع بشكل أساسي إلى محفظة التكنولوجيا الفريدة. أولاً ، يستخدم تكبير البيانات التوليدي نماذج توليدية لزيادة بيانات التدريب ، وبالتالي تحسين إمكانيات المتانة والتعميم للنموذج. من خلال تجميع أزواج نص صور أكثر تنوعًا ، يمكن للنموذج أن يتعلم معرفة أكثر شمولاً بصرية ولغوية.

ثانياً ، يختلف التعلم المتناقض المعزز عن أساليب التعلم التقليدية للتباين. لا يركز Tulip فقط على المطابقة بين الصور والنص ، ولكنه يقدم أيضًا أهداف التعلم في صورة الصور ونص النص. يمكن أن تساعد طريقة التعلم المعززة على النقيض من النماذج على فهم أوجه التشابه البصرية بشكل أفضل بين الصور المختلفة والجمعيات الدلالية بين أوصاف النص المختلفة ، وبالتالي تحسين فهم المعلومات الدقيقة.

أخيرًا ، يعزز تنظيم إعادة الإعمار محاذاة الميزات البصرية واللغوية. تتيح هذه الطريقة النموذج من إعادة بناء وصف النص المقابل من ميزات الصورة أو الصور المقابلة من ميزات النص ، وبالتالي فرض النموذج على تعلم الارتباطات عبر الوسائط العميقة.

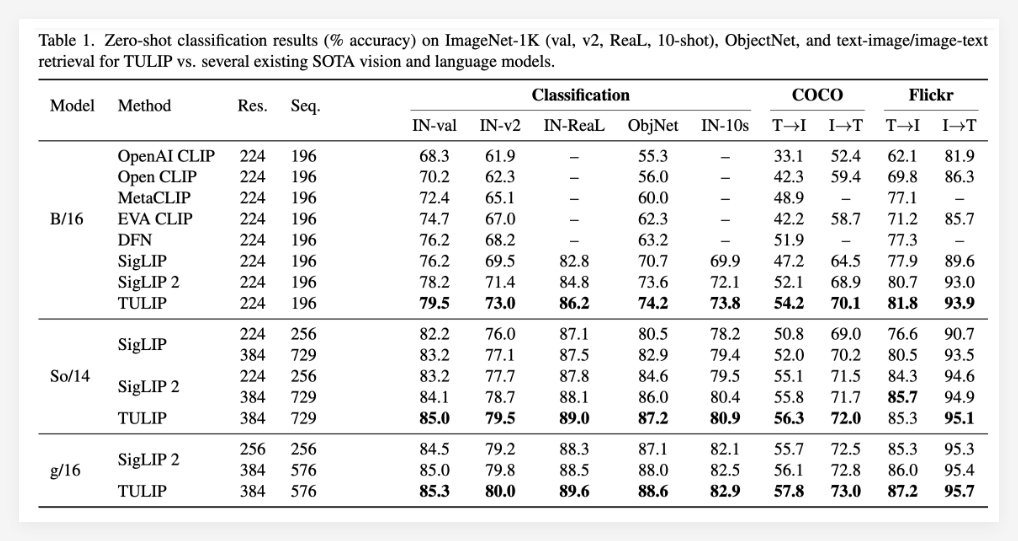

تثبت النتائج التجريبية تمامًا تفوق نموذج توليب. تم الإبلاغ عن أن TULIP حقق مستويات مثالية الحالية في معايير متعددة اللغة المرئية والبصرية المهمة (على أحدث طراز). تتضمن العروض المحددة ما يلي: تحسن كبير في تصنيف العينة الصفرية-1K ، وقدرات التعرف على الكائنات الدقيقة المعززة ، وعشرات الاستدلال متعدد الوسائط المحسنة.

تجدر الإشارة بشكل خاص إلى أنه مقارنةً بالطرق الحالية ، حقق Tulip ما يصل إلى 3 مرات تحسينات في الأداء في معايير MMVP ، وقد حقق أيضًا تحسينات في الأداء مرتين في المهام البصرية التي تم ضبطها. توضح هذه البيانات بالكامل الإمكانات الكبرى لـ TULIP في تحسين أداء النموذج.

المشروع: https://tulip-berkeley.github.io/